蔡湧达 徐佐腾 叶武剑 刘怡俊 王振友 何霁轩 刘峰

摘要:传统的字体特效通常由人工完成设计,这耗费大量的人力物力。为了提高字体特效的生成效率,提出了一种基于风格迁移的字体特效渲染方法。该方法首先使用VGG-19网络提取图片特征值,然后根据Gram矩阵计算特征值之间的差距作为损失函数。经过梯度下降迭代优化算法最小化损失函数可以将输入风格图片的风格逐渐迁移到字体中。实验结果显示大部分生成的字体能够很好地将图片中的风格信息迁移到字体图片中,达到了字体特效渲染艺术效果。

关键词:字体特效渲染;风格迁移;VGG-19; Gram矩阵;特征值

中图分类号:TP39 文献标识码:A 文章编号:1009-3044(2019)04-0151-03

Abstract: Traditional font effects were designed by artificial which is spending a lot of time and resources. In order to enhance the font effects generate effectiveness, we put forward a font effects translate method based on style neural transfer. The method firstly extract feature from style picture by using VGG-19 net. According to Gram matrix we can obtain the lost function between style picture and generated picture. Then, we minimize the lost function by using gradient descent method. The style of style picture can transfer to font picture for several times iterative optimization . The experimental result shows that lots of generated picture can transform style to font picture which achieve the art effect of font effects rendering.

Key words: font effects rendering; style transform; VGG-19; Gram matrix; feature value

1引言

字体特效在生活中无处不在,街头巷尾的广告、传单、标识和部分商标一般会使用加工过的字体以吸引人们的阅读兴趣。传统字体特效的设计过程通常是由人工完成,这耗费了大量的人力物力。而且,人工设计的艺术字还有一个缺点,设计出来的某一特定字体的风格不能迁移到另一个字体上。因此,借助计算机科学技术实现文字风格的设计逐渐成为图像风格迁移领域的一个研究热点问题。

2相关工作

随着深度学习技术发展,图像风格迁移方法取得了很大的进步。图像风格迁移方法可以歸纳为艺术风格迁移,神经风格迁移以及这两种风格迁移方法的改进和扩展三种类型 [1]。其中,神经风格迁移方法受到广泛关注 [2-3]。文献 [2]提出了基于卷积神经网络的图像风格迁移方法。这种方法通过卷积神经网络来合成纹理来融合输入风格图片的风格和输入内容图片的内容。文献 [4]提出了基于卷积神经网络的多尺度合成方法,它首先通过使用直方图损失来解决合成纹理的不稳定的问题。此外它还展示了如何进行多尺度框架中整合到风格迁移对象的风格损失。这些损失可以改善分离内容和风格的比例,使得经过迁移的图片视觉效果更加自然。为了使迁移后的风格图片更加体现细节特征,Shaohua Li等人在卷积神经网络中引入拉普拉斯损失 [5]。实验结果显示该损失能够保存输入内容图片的很多细节信息。

上面介绍的大多数是图像优化慢神经方法,还有一种图像优化快速神经方法 [1]。文献 [3]提出使用感知损失函数来训练前馈网络以进行图像转换任务。该方法结合了输入图片与目标图片之间的像素级损失和从预训练网络提取的高级特征来定义和优化感知损失函数。论文中的结果显示其优化速度得到很大的提高。Yijun Li提出了一种深度生成的前馈网络,它可以在一个网络中有效地合成多个纹理,并在它们之间进行有意义的插值 [6]。这是一种一个模型融合多种风格的迁移方法。另外,还有一种一个模型融合任意风格的方法 [7]。该方法的核心是一个自适应实例正则化(AdaIN)层,用于对齐平均值和方差内容功能与样式功能。这种方法具有很快的速度,没有对预定义样式集的限制。

作为图像风格迁移方法研究和应用领域的一个延伸,文本风格迁移正受到学者的关注 [8]。文献 [8]提出了基于统计的方法来进行文本风格迁移。文中提出了一个具有三个互补项的目标函数,以综合考虑图像局部多尺度纹理、图像全局分布和视觉效果。但是,这种方法对输入图片的要求比较高,扩展应用相对困难。

在本文中提出了基于卷积神经网络的字体特效迁移方法。应用Gatys [2]的风格化方法对字体特效风格进行特效迁移,实现内容图到特效图的转换。生成图的初始图片为一般字体图片,这样的好处是在迭代过程中可以不用计算内容损失只需要考虑风格损失的问题,本方法可实现任意字体的特效渲染,并取得不错效果,有利于辅助字体效果设计等相关领域。

3 文本风格转换原理

3.1 VGG网络

VGG网络主要是从Alex-Net发展而来的。它采用3*3的卷积核能够很好地提取图像的特征信息。由于其结构是多个卷积层与非线性的激活层相互替换的,深层的特征信息得以被挖掘。VGG-19网络如图1所示 [10],它包含输入和输出,五个卷积层,五个池化层以及三个全连接层。其中,Conv_layer1包含2层3*3的卷积核64个,Conv_layer2包含2层3*3的卷积核128个,Conv_layer3包含4层3*3的卷积核256个,Conv_layer4包含4层3*3的卷积核512个,Conv_layer5也是含有4层3*3的卷积核512个。池化层对特征数据进行最大池化。由于在风格转换过程中使用VGG网络是为了提取特征,所以在本文中只使用Conv_layer5输出的特征数据。

3.2 风格转换原理

假设有一张风格图像[s]和字体图像[c]。对风格图像[s]使用VGG-19卷积网络提取特征值,特征值组成的集合记为[S]。

与此同时,对字体图像 使用VGG-19卷积网络提取特征值,特征值组成的集合记为集合[C]。我们的优化目的是使得重构图片[r]的内容可以保持字体图像的内容信息同时又具有风格图像的风格。

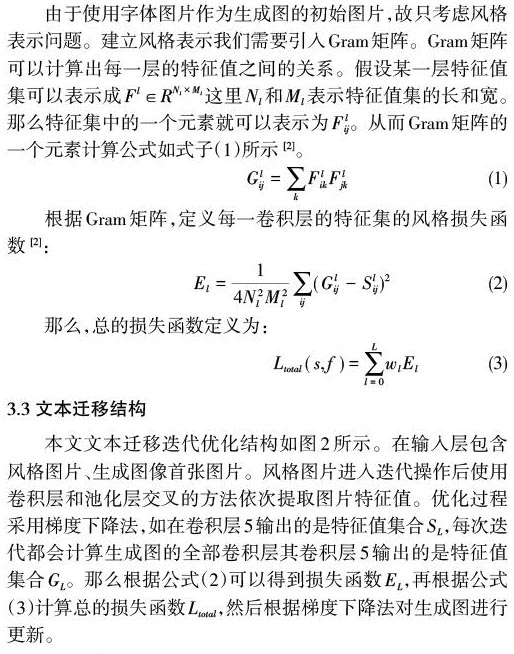

由于使用字体图片作为生成图的初始图片,故只考虑风格表示问题。建立风格表示我们需要引入Gram矩阵。Gram矩阵可以计算出每一层的特征值之间的关系。假设某一层特征值集可以表示成[Fl∈RNl×Ml]这里[Nl]和[Ml]表示特征值集的长和宽。那么特征集中的一个元素就可以表示为[Flij]。从而Gram矩阵的一个元素计算公式如式子(1)所示 [2]。

3.3 文本迁移结构

本文文本迁移迭代优化结构如图2所示。在输入层包含风格图片、生成图像首张图片。风格图片进入迭代操作后使用卷积层和池化层交叉的方法依次提取图片特征值。优化过程采用梯度下降法,如在卷积层5输出的是特征值集合[SL],每次迭代都会计算生成图的全部卷积层其卷积层5输出的是特征值集合[GL]。那么根据公式(2)可以得到损失函数[EL],再根据公式(3)计算总的损失函数[Ltotal],然后根据梯度下降法对生成图进行更新。

4 实验结果

如图3,分析实验结果可以发现经过500次优化迭代,风格图的风格已经能够迁移一部分到字体中。经过3000次迭代,生成的艺术字已经能够达到良好的艺术效果。但是,实验发现艺术字生成效果受原始的迁移文本图的影响很大。如图4所示,输入白底黑字的“竹”字,即使经过2500次优化迭代其生成效果也很糟糕。这说明只有迁移文本图的背景与风格图的背景相同或相似才能在使用本文方法中获得良好的艺术效果。

这是因为在特征提取过程中,从风格图片中提取的特征值已经把风格和背景分别提取出来了。当输入字体的背景与风格背景相同或者相似时,风格就能够迁移到字体上。反之,如果风格背景与字体颜色相近,生成的字体也就更多地体现背景特征而不能够把风格迁移到字体上。

第1列为输入的风格图片,第2列为输入的字体图片它作为生成图的首张图片,第3列为500次迭代优化的艺术字生成图,第4列为3000次迭代优化的艺术字生成图。

第1列为输入的风格迁移文本图,第2-6列为迭代不同次数的实验结果图。

4 结论

本文提出了一种基于风格迁移的字体特效渲染方法。该方法通过输入一张风格图片和一张字体图片,经过数次迭代优化就可以生成具有艺术效果的字体特效。但是,部分字体图片中字体颜色与风格图片背景颜色相同或者相似的在实验中不能起到很好的渲染效果。所以下一步要对现有方法进一步改进,使该方法对输入的任何字体背景都能进行很好地进行风格渲染。

参考文献:

[1] Jing Y, Yang Y, Feng Z, et al. Neural Style Transfer: A Review[OL]. [2017-05-11], http://cn.arxiv.org/abs/1705.04058.

[2] Gatys L A, Ecker A S, Bethge M. Image Style Transfer Using Convolutional Neural Networks[C]. Computer Vision and Pattern Recognition. IEEE, 2016:2414-2423.

[3] Johnson J, Alahi A, Li F F. Perceptual Losses for Real-Time Style Transfer and Super-Resolution[C]. European Conference on Computer Vision. Springer, Cham, 2016:694-711.

[4] Risser E, Wilmot P, Barnes C. Stable and Controllable Neural Texture Synthesis and Style Transfer Using Histogram Losses[OL]. [2017-02-01] http://cn.arxiv.org/abs/1701.08893.

[5] Li S, Xu X, Nie L, et al. Laplacian-Steered Neural Style Transfer[C. Proceeding MM '17 Proceedings of the 2017 ACM on Multimedia Conference 2017:1716-1724.

[6] Y. Li, C. Fang, J. Yang, Z. Wang, X. Lu and M. Yang. Diversified Texture Synthesis with Feed-Forward Networks[C]. 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Honolulu, Hawaii, USA. 2017:266-274.

[7] X. Huang and S. Belongie. Arbitrary Style Transfer in Real-Time with Adaptive Instance Normalization[C]. 2017 IEEE International Conference on Computer Vision (ICCV), Venice, Italy, 2018:1510-1519.

[8] S. Yang, J. Liu, Z. Lian, and Z. Guo. Awesome typography: Statistics-based text effects transfer[C]. in Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2017:7464-7473.

[9] Isola P, Zhu J Y, Zhou T, et al. Image-to-Image Translation with Conditional Adversarial Networks[C]. 30th IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR),2016:5967-5976.

[10] Simonyan K, Zisserman A. Very Deep Convolutional Networks for Large-Scale Image Recognition[OL]. [2015-08-10], http://cn.arxiv.org/abs/1409.1556.

【通聯编辑:唐一东】

- 石油物流网络的建构及其实现途径

- 关于基建项目全过程管理的探讨

- 新时期加强社保基金财务管理的对策思考

- 以国内信用证促进国内贸易

- 浅谈城市轨道交通供电系统的节能措施与经济运行

- 网络经济时代市场营销策略的转变探究

- 浅析工程概预算编制对工程造价的影响

- 浅谈工业园区规划环评中大气环境影响评价方法

- 行业期望落差、股权集中度与探索式创新投入分析

- 建立电力系统通信网可靠性管理体系相关问题的探讨

- 对新时期我国城市规划若干问题的探讨

- 基于DEA的高校创业孵化器的绩效分析

- 基于KPI的航天科研项目绩效考核研究

- 建筑室内设计与建筑整体设计一体化的具体措施探讨

- 加快边疆城市城镇化建设路径研究

- 阿里巴巴并购饿了么的动因和财务风险分析

- 新零售模式下快消品行业创新模式探究

- 大数据时代内部审计面临的风险及应对策略

- 减税降费背景下小微企业财务管理研究

- 行政机关单位内部会计控制探讨

- 分析大数据时代企业财税管理

- 财务预算管理降低企业成本费用的探析

- 关于加强国有企业内部审计工作的思考与对策

- 新时代企业总账会计从核算型迈向管理型的思考

- 加强行政事业单位内部会计控制的若干思考

- pay-back

- payback

- pay back for

- pay-back-in-own-coin

- paybackperiod

- payback period

- paybacks

- paycable

- pay cable

- pay channel

- paychannel

- paycheck

- paycheque

- pay cheque

- pay child support

- pay claim

- payclaim

- pay comparability

- paycomparability

- pay day

- payday

- paydays

- self-commitments

- self-committing

- self-communication

- 全是虚货

- 全是软的

- 全是酸的

- 全是鬼事

- 全是鬼(诡)计

- 全景

- 全景式

- 全景电影

- 全智全能

- 全月

- 全本

- 全本连台

- 全权

- 全权代表

- 全权大使

- 全权裁决

- 全权证书

- 全权证书的写法

- 全村

- 全来到

- 全武行

- 全歼

- 全歼敌军

- 全民

- 全民健身日