蒋志文 郑怡亭 邓娇 张宜放

摘要:深度学习算法在很多领域取得了卓越的成就,但同时也容易受到对抗样本的攻击。使用对抗样本训练模型是抵御模型被攻击的有效手段,但这需要大量对抗样本的支持。为了提升对抗样本的生成效率,本文提出了一种基于抽样向量扰动的对抗样本生成方法(SPVT)。实验结果表明,该方法可以在短时间内生成大量有效对抗样本,并且能够自适应计算出FGSM算法的扰动幅度,并且和人为设定参数的FGSM算法相比对抗成功率提升了0.77%;生成相同数量的对抗样本,SPVT方法与DeepFool算法相比能够节约1/6的时间,解决了对抗样本生成效率不高的问题。

关键词: 对抗样本;深度学习;白盒攻击

Abstract: The deep learning algorithm has achieved remarkable achievements in many fields, but it is also vulnerable to adversarial examples. Adversarial training is an effective means to improve the robustness of deep learning models, but it needs a large number of adversarial examples. In order to improve the efficiency of generating adversarial examples, this paper proposes SPVT method that based on sample vector perturbation. Firstly, sampling from the test dataset and use an optimized based generation algorithm to calculate the perturbation vectors; Secondly, transform the perturbation vectors into the disturbance amplitude; Finally, using a gradient-based generation algorithm to generate a large number of adversarial examples. The experimental results show that SPVT can generate a large number of effective adversarial examples in a short time, and it can adapt the disturbance amplitude of FGSM, which has 0.77% higher success rate than that of FGSM with artificial parameters. When generating the same number of counter samples, SPVT method can save 1/6 of times compared with Deepfool, which solves the problem of low efficiency of adversarial examples generation problems.

Key words: adversarial example; deep learning; robustness of model

1前言

深度學习是人工智能的一个重要分支,被广泛地运用于计算机视觉和图像识别等领域,如人脸识别[1]和图片分类预测[2]等。在深度学习技术在生产和生活等领域普及的同时,其本身的安全性问题也越来越受到研究者的关注。目前CNN等深度学习模型在图像分类问题上的应用和效果表现得尤为突出,但这些高性能的图像分类器在面对对抗样本攻击的时候却暴露了其脆弱性。这些攻击深度学习模型的对抗样本只是在原始的输入图片上加入了微小量的像素扰动,却能够导致模型无法获得最终正确的分类结果,从而让对抗样本攻击对图像分类系统产生巨大的危害[3],因此构造高鲁棒性的深度学习模型具有重要的研究意义。通过在训练神经网络模型的训练数据中加入对抗样本进行模型的训练,能够加强模型的鲁棒性[4],从而能够更好地抵御来自对抗样本的攻击。模型鲁棒性是用于分析模型对于微小的数据扰动的抵抗能力的评测标准,在模型面对相同的扰动下,模型的准确率越高,则模型的鲁棒性越好[5]。

为了平衡对抗样本的生成速度和样本质量扰动质量大小之间的矛盾,本文提出了一种基于抽样扰动向量的快速对抗样本生成方法(adversarial method based on Sampling Perturbation Vector Transform):首先,随机地从样本数据集中抽取部分样本,使用对抗成功率更高的基于单个样扰动向量的对抗样本生成方法(DeepFool算法[6]),迭代地计算每个样本可达到误分类的扰动向量,获取样本的所有扰动幅度的集合;其次,计算扰动幅度集合中所有样本的平均扰动幅度;最后,将这个计算出来的扰动幅度应用于FGSM算法[7]生成对抗样本。

2 SPVT方法

SPVT方法结合了基于优化的DeepFool对抗样本生成方法和基于梯度的FGSM对抗样本生成方法。SPVT方法的流程图如图1。本节主要介绍了使用SPVT方法生成对抗样本的具体步骤,包括:抽样扰动向量集构建,扰动幅度生成和对抗样本生成。

2.1抽样扰动向量集构建

在统计学中,为了减少计算量,通常采用抽样的方式使用抽样样本特征预估整体样本特征。基于统计学中以部分代替总体的思想,本文使用抽样后的数据集中样本的扰动特征来预估总体数据集的扰动特征,这样可以减少计算时间。

2.2扰动幅度生成

对于在抽样扰动向量集构建步骤中获取到的扰动样本集RS,可以通过以下的方法将该扰动样本集RS中的扰动向量转化为整体样本数据集中的扰动幅度。生成扰动幅度方法的具体过程推导如下:

假设对于单个对抗样本而言,不同的对抗样本生成方法都有可能产生近乎一致的扰动向量。这个扰动向量和使用的对抗样本生成方法无关,只与该样本有关。那么对于单个的对抗样本,则可以使用如下的转换方法来讲将扰动向量转化为扰动幅度。

首先,将样本集D的扰动比例定义为:

2.3对抗样本生成

FGSM算法是一种基于梯度的白盒攻击方法。该方法依据图像的梯度来生成对抗样本,首先输入图片和一个神经网络,之后计算图片的梯度,最后将梯度叠加到原始的输入图像上来生成对抗样本。

3实验

3.1实验方法

我们实现了在SPVT方法中提出的转换方法,该方法将基于优化的对抗样本生成方法生成的扰动和基于梯度的对抗样本生成方法的扰动连接起来,综合了两者的优点,提高了对抗样本的生成效率。为了评估我们方法的有效性,我们将通过实验来验证使用SPVT方法是否能提高对抗样本的生成效率。

3.2实验结果及分析

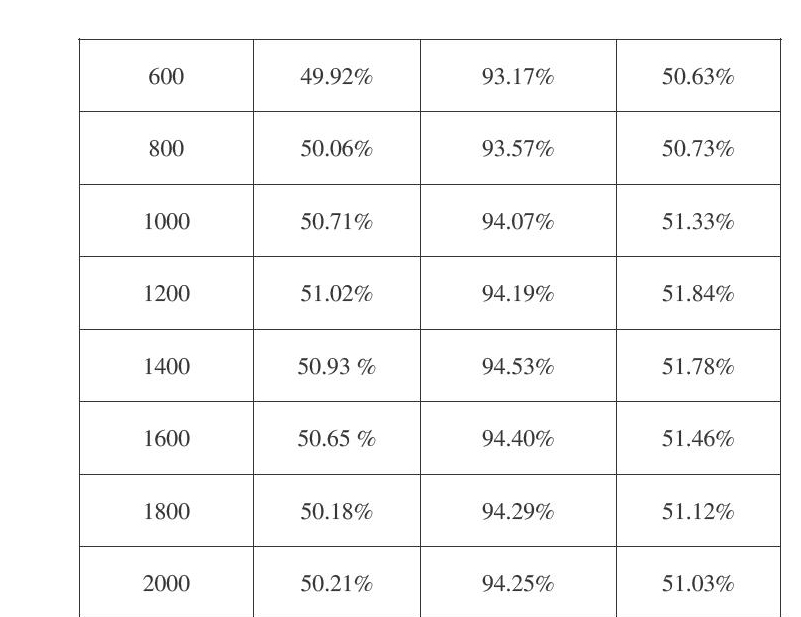

对于使用MNIST数据集训练好的神经网络,我们分别使用了三种不同算法生成200至2000个成功的对抗样本,观察其对抗成功率(对抗成功率=对抗成功的数量/实验总数),实验结果如表1所示。对于每种不同的对抗攻击方法,我们都让其在LetNet(MNIST)数据集上生成100~1000张成功的对抗样本,将其对抗成功率记录在表1中。

从表1中可以看出,生成200~2000个对抗样本,FGSM、DeepFool、SPVT算法的平均对抗成功率为49.98%,93.47%和50.75%。相较于FGSM算法我们将其对抗成功率提高了0.77%,并且使用SPVT方法不需要自己设定FGSM算法的扰动幅度值来生成对抗样本,它能够根据扰动推导公式自适应地获取扰动幅度值进行对抗样本生成。

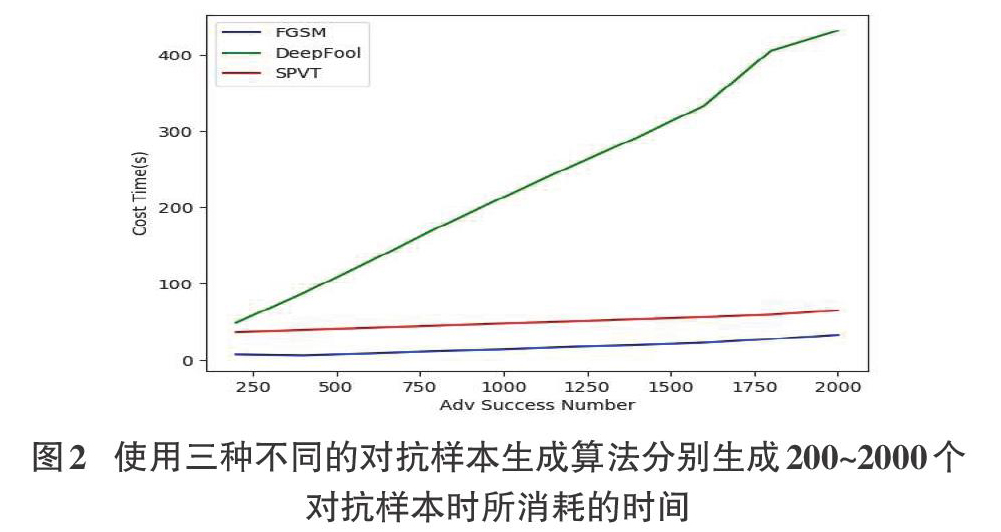

从图2中可以直观地看出SPVT方法在生成相同数量的对抗样本时消耗的时间大约为DeepFool算法消耗时间的1/6,比FGSM算法消耗的时间略高。通过分析曲线的趋势,如果生成更多的对抗样本,SPVT方法相较于DeepFool算法的生成优势会变大。

通过以上实验结果及分析,SPVT方法相较于DeepFool算法而言,虽然对抗成功率不如DeepFool算法高,但使用SPVT方法能够将生成相同数量对抗样本花费的时间降低到1/6左右。SPVT相较于FGSM算法的优势在:SPVT方法生成对抗样本时不需要人为指定扰动幅度的超参数,能够进行参数自适应地生成对抗样本。使用SPVT方法生成对抗样本,能够提升对抗样本的生成效率,并且尤其适用于大批量的对抗样本生成任务。

4结论和总结

在这篇论文中,我们基于FGSM算法和DeepFool算法提出了一种SPVT算法,可以解决在短时间内生成大量对抗样本的问题。使用SPVT方法生成对抗样本可以自适应地计算出样本的扰动幅度,从而可以将一个合适的扰动幅度值输入给FGSM算法进行对抗样本生成,避免生成扰动过大或者过小的图片。

参考文献:

[1] Blessing of Dimensionality: High-dimensional Feature and Its Efficient Compression for Face Verification. Dong Chen. Xudong Cao. Fang Wen. Jian Sun. CVPR 2013.

[2] Zheng H, Fu J, Mei T, et al. Learning multi-attention convolutional neural network for fine-grained image recognition[C]//Proceedings of the IEEE international conference on computer vision. 2017: 5209-5217.

[3] Moosavi-Dezfooli S M, Fawzi A, Fawzi O, et al. Universal adversarial perturbations[C] //Proceedings of the IEEE conference on computer vision and pattern recognition. 2017: 1765-1773.

[4] Cheng Y, Jiang L, Macherey W. Robust neural machine translation with doubly adversarial inputs[J]. arXiv preprint arXiv:1906.02443, 2019.

[5] Hampel F R, Ronchetti E M, Rousseeuw P J, et al. Robust statistics: the approach based on influence functions[M]. John Wiley & Sons, 2011.

[6] Moosavi-Dezfooli S M, Fawzi A, Frossard P. Deepfool: a simple and accurate method to fool deep neural networks [C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2016: 2574-2582.

[7] Goodfellow I J, Shlens J, Szegedy C. Explaining and harnessing adversarial examples[J]. arXiv preprint arXiv:1412.6572, 2014.

【通聯编辑:光文玲】

- 冷却液/防冻液储备碱度—重要质量指标

- 高职院校教师绩效考核体系创新研究

- 高校修缮工程审计的问题及解决方法

- 浅析水情教育与生态文明建设的关系

- 军民专利权转移过程中信息传递障碍及对策研究

- 地理国情普查数据支持下的人口分布影响因素分析

- ‘庄子切棒悖论’、‘调和级数悖论’等的浅简彻底解决

- 浅析近年锦州地区水体环境质量问题及原因

- 企业内部治安保卫工作的现状及对策研究

- 以就业为导向的高职纺织服装专业人才培养模式探究

- 装表接电及防盗电分析

- 黔西南州太阳能资源开发利用条件分析

- 微波消解原子荧光光度法测定土壤中汞

- 园林养护精细化管理对园林景观的影响

- 关于松果球开闭现象的探究

- 食用植物性农产品中重金属检测的重要性

- 风景园林施工的常见问题及解决策略

- 解析园林绿化施工技术要点及保障措施

- 芹菜素的生物学活性研究进展

- 智能变电站继电保护系统可靠性分析

- 电厂如何做好精细化安全管理研究

- 垃圾电厂风机水泵变频节能改造

- 高压输电线路状态检修技术管理

- 输配电线路带电作业技术的应用研究

- 浅谈输电线路的运维与检修技术

- supremity

- supt.

- supt

- supˌply and demand

- supˌply chain event management

- surcharge

- surcharged

- surcharger

- surchargers

- surcharges

- surcharging

- sure

- surefire

- sure-fire

- sure fire

- surely

- surenesses

- sure/not sure

- sure of yourself

- surer

- surest

- sureties

- surety

- suretyships

- sure²

- 蛇莓

- 蛇蓝

- 蛇蔗

- 蛇藨

- 蛇虫

- 蛇虫百脚

- 蛇虹

- 蛇虺

- 蛇蚓

- 蛇蚹

- 蛇蛇

- 蛇蛛

- 蛇蜕

- 蛇蜕下来的皮

- 蛇蜥

- 蛇蜥等特有的鳞

- 蛇蜮

- 蛇蝎

- 蛇蝎其心

- 蛇蝎心肠

- 蛇螈

- 蛇螫断腕

- 蛇蟊

- 蛇蟠鬼附

- 蛇行