尚建伟 蒋红海 喻刚 陈颉颢 王博 李兆旭 张伟平

摘 要:田间除草技术在农业生产中具有重要意义。针对复杂背景下农作物与杂草识别率低、算法鲁棒性差等问题,提出一种图像分割网络Res-Unet。该网络为unet网络的改进版本,采用resnet50网络代替unet主干网络,解决复杂背景下农作物与杂草区域提取困难、小植株检测效果差、分割边缘震荡、变形问题。将图像的平均交并比、准确率、训练时长作为评价指标进行实验。结果表明:使用Res-Unet模型的平均交并比为82.25%,平均像素准确率为98.67%。改进的Res-Unet模型相对于Unet平均交并比高出4.74%,相較于segnet平均交并比高出10.68%,训练时间减少3小时。该方法对复杂背景下甜菜杂草检测效果良好,可为机器人精确除草提供参考。

关键词:图像分割;卷积神经网络;深度学习;图像识别;杂草识别

DOI:10. 11907/rjdk. 201392 开放科学(资源服务)标识码(OSID):

中图分类号:TP319文献标识码:A 文章编号:1672-7800(2020)007-0127-04

Weed Identification System Based on Deep Learning

SHANG Jian-wei1, JIANG Hong-hai1, YU Gang1, CHEN Jie-hao1, WANG Bo1, LI Zhao-xu1, ZHANG Wei-ping2

(1. School of Mechanical and Electrical Engineering, Kunming University of Science and Technology, Kunming 650504, China;

2. 78098 Military Training Team, Chengdu 610200,China)

Abstract: The field weeding technology is of great significance in agricultural production. The traditional weed identification technology has the disadvantages of low efficiency or great limitations. To solve the problem of low recognition rate of crops and weeds in complex background and poor robustness of algorithm, an image segmentation network res UNET is proposed. Res UNET is an improved version of UNET network. It uses resnet50 network instead of the main network of UNET to solve the problem of crop and weed area extraction under complex background, poor detection effect of small plants, edge vibration and deformation of segmentation. The average intersection ratio, accuracy and training time of the image are selected as evaluation indexes. The results show that the average cross union ratio of res UNET model is 83.25%, and the average pixel accuracy is 98.67%. The improved res UNET model is 4.74% higher than the UNET average, 10.68% higher than the segnet average, and the training time is reduced by 3 hours. This method has a good detection effect on beet weeds in complex background, and can provide a reference for the follow-up robot precision weeding.

Key Words: image segmentation; convolutional neural network; deep learning; image identification; weed identification

0 引言

杂草控制是农场最重要的作业之一,因为不受控制的杂草会对作物产量和质量产生重大影响。喷洒除草剂和人工除草是最常用的除草方法,但从经济和环境角度看都不可取。人工除草成本较高且效率较低。机器视觉在取代人类进行植物识别方面显示出巨大潜力,自动精确除草系统有望填补这一空白[1]。自动除草关键是快速准确获取作物与杂草位置[2]。颜色、形状[3-4]、光谱和纹理[5]是杂草识别的主要特征。

Cho等[6]对萝卜的长径比、细长度及周长等形状特征进行评价,以区分萝卜和杂草。除圆度外,还包括7个不变中心矩(ICM)用于从杂草物种中识别出玉米和大豆[7]。对大豆、玉米和玉米田低水平纹理特征均作出评价,指标如偏度、平均值、方差[8]、灰度共生矩阵、角二阶矩、惯性、熵、局部均匀性等[9];之后Gabor小波纹理特征占据主流,对杂草/作物分类技术形成了较大改进[10]。纹理特征与现代分类器,如模糊聚类、贝叶斯分类器、支持向量机和神经模糊分类器[11-13]已用于作物识别系统。

近年兴起的深度学习方法在杂草识别方面表现卓越。彭明霞等[14]融合特征金字塔网络(Feature Pyramid Networks,FPN)的Faster R-CNN,提出在复杂背景下高效识别棉田杂草方法,检测效果较好;孙俊等[15]提出一种空洞卷积与全局池化相结合的卷积神经网络识别作物幼苗与杂草方法,平均识别准确率与分类成功率均较高。上述方法显示深度学习方法在杂草识别领域的光明前景,但这些模型参数量大,结构较为复杂。

针对现有模型网络复杂度高、不易训练问题,提出Res- Unet杂草检测模型。以Unet為主要框架,用Resnet50代替Unet主干网络。使用resnet50卷积神经网络进行下采样,从加深网络结构、提取多尺度特征、减小模型数据量等方面优化网络。

1 图像分割与实验

1.1 图像采集与实验设计

本研究图像数据来源于德国波恩大学采集的甜菜与杂草图片[16]。图像采集由博世DeepField Robotics公司生产的多用途机器人完成,采集设备为JAI AD-130GE摄像头,提供最大分辨率1 296×966像素图像,采集时间为2016年5月23日。图1为农田信息采集机器人 BoniRob、数据采集样本样例及标签图。红色标签为甜菜,其它颜色为杂草。

由于卷积残差网络能够自动从不同尺寸图像中提取特征,所以样本图像可直接用于本文的图像分割模型进行训练与测试,不需要缩放等预处理操作。将甜菜和杂草样本分为训练集、验证集和测试集。其中训练集910张,测试集390张,验证集100张。训练集用于训练模型参数,测试集用于评估模型泛化能力,验证集用于模型超参数调优。最后应用典型评测指标——平均交并比(Mean-IOU)衡量模型检测器性能。

1.2 图像分割

1.2.1 残差卷积网络

2015年何凯明等[17]提出Resnet网络结构,该网络大幅提高神经网络深度,并在与ISLVRC和COCO比赛中胜出。常规的网络优化思想是通过大量网络堆叠提高网络性能,但深层神经网络带来梯度消失和梯度爆炸问题,Resnet网络的残差块思想使神经网络深度提高,从而取得更好的训练结果。

图2 (a)为Conv Block网络结构,图2(b)为Identity Block网络结构,图2(c)为resnet50网络结构。Resnet50由Conv Block与Identity Block两个基本残差块组成,两个基本块有主路径和跳跃路径,主路径有3个卷积层,3层卷积核分别为1×1、3×3和1×1;Conv Block的跳跃路径经过1×1卷积网络后与主路径输出相加,Identity Block跳跃路径直接与主路径输出相加。当网络输入与输出维度一致时,可选用Identity Block直接将输入与输出相加。当网络输入与输出维度不一致时,选用Conv Block改变网络维度。

1.2.2 Res-Unet图像分割模型

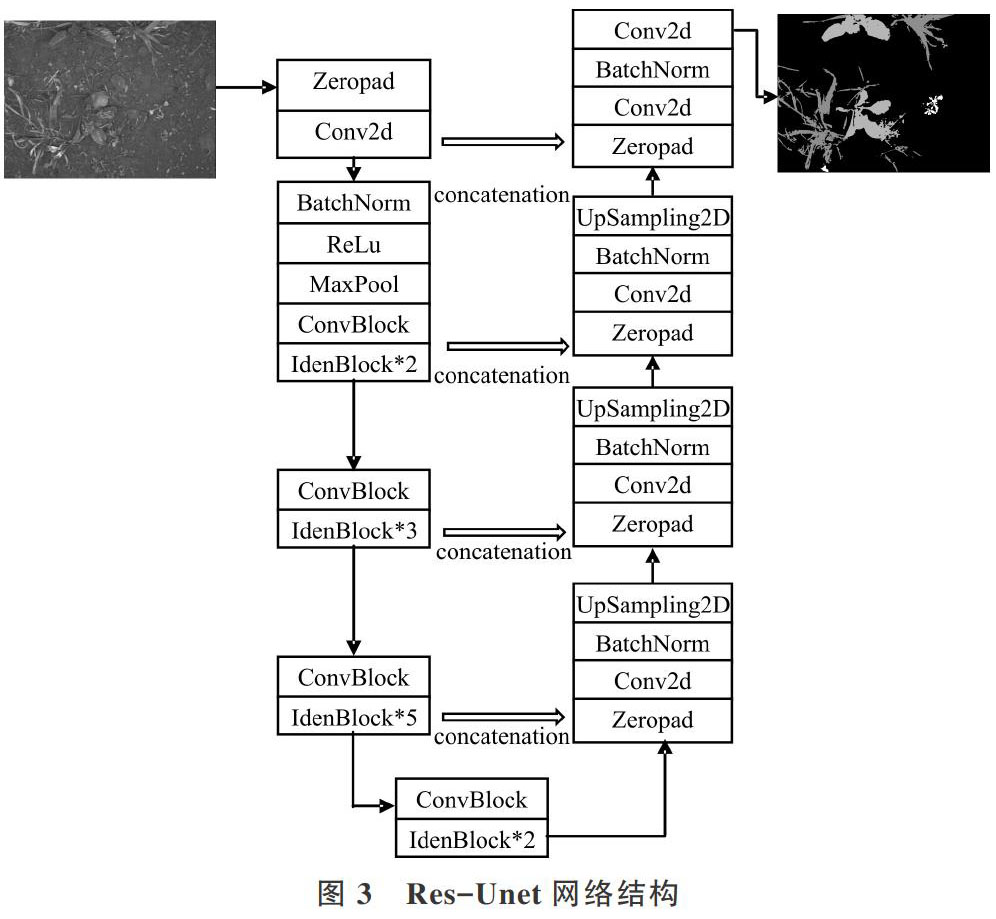

图像分割是从像素层次识别图像,为图像中的每个像素指定类别标记。UNet是一种编码—解码网络结构的语义分割模型。Res-Unet模型将Unet主干网络替换为Resnet50,该模型不仅保留resnet网络收敛速度快、网络深的优点,还兼顾unet网络结构简单、数据量小优势。图3为Res-Unet网络结构,左边为编码器,将输入图片送入resnet50进行下采样,图片被4次压缩,得到较低分辨率但经学习可高效区分类别的特征图;右边为解码器,下采样特征为全分辨率分割图,下采样中的层与上采样中的层之间存在许多合并连接,有助于解码器使用上采样恢复图像细节。

2 模型训练

2.1 实验条件

本文使用keras与tensorflow深度学习开源框架训练模型。实验配置为:处理器:Intel(R) Core? i7-8550U 四核,主板:惠普8471,内存:8GB(三星 DDR4 2666MHz),硬盘:英特尔SSDPEKKF360G7H(360GB/固态硬盘),显卡:Nvidia GeForce MX150 (2 GB),环境为keras2.2.0,tensorfolw1.13.1,python3.6。

2.2 网络模型训练方法

采用910张甜菜杂草图像进行网络训练,选用Adam优化器[18]使错误最小化。Adam优化器是一种基于一阶梯度的随机目标函数优化算法,基于低阶矩自适应估计。使用Adam优化器计算效率高、内存要求低、梯度对角重新缩放不变以及非常适合数据或参数较大场合。Adam优化器学习速率设置为1×[10-3]。分类交叉熵函数用作损失函数,使用Mean-IOU评估网络模型。使用Xavier初始化权重[19]。Xavier初始化通过在整个层中将信号保持在合理值范围确保合适权重。其保持输入梯度和输出梯度方差相同,有助于保持整个网络中梯度大小基本相同。

3 实验结果与分析

3.1 损失函数变化情况

本文研究属于3类别图像分割问题,分别为甜菜、杂草、土壤。选择分类交叉熵函数作为图像分割模型的损失函数,计算公式如下:

式(1)中,N为样本数,K为标签数,[yik=1]为正样本真实标签,[yik=0]为负样本真实标签,[y*ik]为样本预测概率。loss值为实际输出概率与期望输出概率之差。交叉熵的值越小,两个概率分布就越接近。

首先将1 300张甜菜杂草数据集和它们对应的标签图送入Res-Unet图像分割模型中训练,训练集图片910张,测试集图片390张,观察网络训练过程中训练集和测试集损失函数的变化。图4显示分类交叉熵损失函数变化情况,其中横坐标表示训练轮数,纵坐标表示交叉熵损失函数数值。为控制网络的过拟合情况,对网络进行不同的Dropout值(50%、65%和80%)训练,以找到损失函数最低值,并选择50%作为网络的dropout值。图4显示Dropout值为50%的均损失函数。从图4可以很明显看出网络迅速融合。网络训练前20轮学习率较大,网络参数更新速度快,损失函数波动较大。网络训练20~40轮之间,损失函数逐渐达到平稳数值范围,此时训练集损失函数为0.016,测试集损失函数为0.021。

3.2 甜菜雜草目标识别结果与分析

网络训练完成后,将100张验证集图片输入训练完成的模型中。尽管在复杂环境背景田地中,但网络对于图像依旧表现良好。图5为预测图像与真实标签对比,图5(a)为采集的原始图像,图5(b)为其对应的像素级标签,图5(c)为预测图像。

3.3 结果评估

图像分割中评估模型性能标准很多,本文使用mean-iou作为评估指标。mean-iou计算如下:

式(2)中,k为图像中标签类别数,i表示真实类别,[pij]表示属于i类但被判定为j类的像素数量,即假阳性像素数量,[pji]为假阴性像素数量,[pii]为预测正确的像素数量。

如图6所示,在训练的前20轮,训练集和测试集的mean-iou波动很大,拟合度很低。在训练的20~40轮之间,两个数据集中的mean-iou一直平稳增加,且曲线拟合度慢慢增大。40轮后,模型的mean-iou不再增加。在40轮时,测试集的mean-iou达到82.25%。

3.4 与其它技术比较

将模型结果与几种方法进行对比,这里比较Segnet[20]、Unet[21]图像分割网络效果。如表1所示,将网络模型的训练时长、平均交并比、平均像素准确率进行对比。其中训练时长Res-Unet和Unet远远优于Segnet。Res-Unet在Mean-IOU和Accuracy指标上表现最为优异,最高值分别为82.25%、98.67%,高于Unet和Segnet网络。

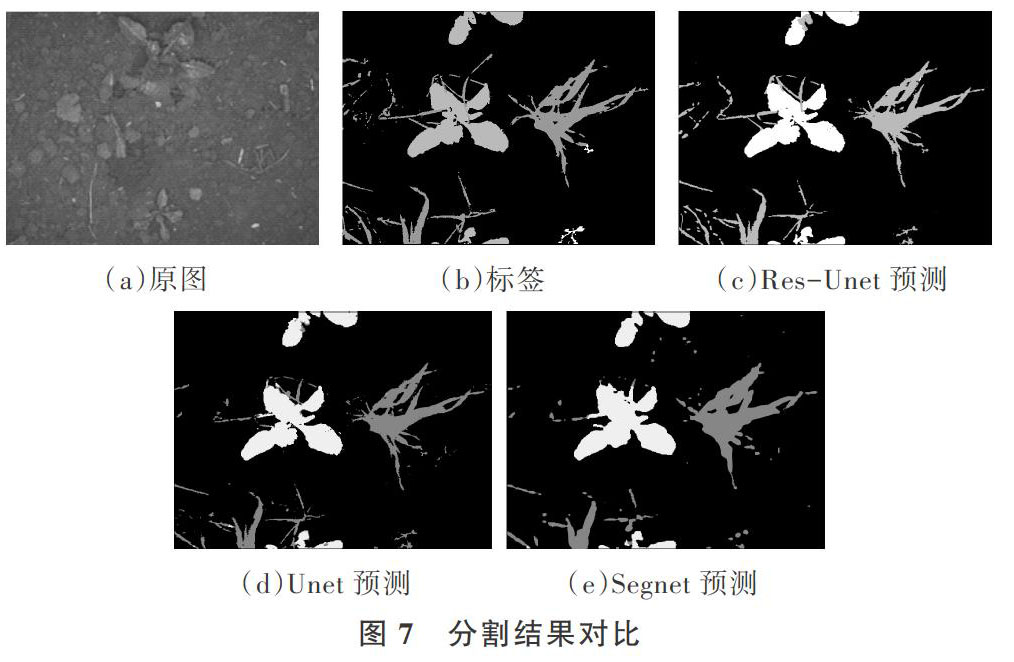

图7为Res-Unet、Unet和Segnet网络的分割效果。对比发现,Res-Unet图像分割网络可以很清晰地识别出杂草与甜菜,而Unet和Segnet有很大的假阳率和假阴率,并且Res-Unet网络对小植株识别明显优于其它两个模型。面对图像分割模型遇到的图像分割边缘震荡问题,Res-Unet网络表现更优秀,边缘更加清晰。复杂背景下的杂草识别受很多因素影响,Res-Unet网络从多尺度提取图像特征,算法鲁棒性更好。

4 结语

本文基于深度学习的图像分割技术对杂草和作物进行识别,对传统的Unet网络进行改进,采用Resnet50代替Unet网络下采样部分,与原始模型相比加深了网络结构,不需要进行缩放等预处理操作,能够更有效地提取甜菜和杂草的特征信息。通过对复杂背景下甜菜和杂草的田间试验,验证了模型的有效性:平均交并比达到82.25%,平均像素准确率达到98.67%,具有较高的分割识别精度,为研制智能除草机提供了理论依据。

参考文献:

[1] SUJARITHA M, ANNADURAI S. Weed detecting robot in sugarcane fields using fuzzy real time classifier[J]. Computers and Electronics in Agriculture,2017, 134(6):160-171.

[2] LI N, T E GRIFT, YUAN T, et al. Image processing for crop/weed discrimination in fields with high weed pressure[C]. In 2016 American Society of Agricultural and Biological Engineers Annual International Meeting, 2016.

[3] PEREZ A J,LOPEZ F,BENLLOCH J V, et al. Colour and shape analysis techniques for weed detection in cereal fields[J].? Computers and Electronics in Agriculture. 2000,25(3):197-212.

[4] LAMM R D, SLAUGHTER D C, GILES D K. Precision weed control system for cotton[J]. Transactions of the ASAE,2002,45(1):231-238.

[5] GUIJARRO M,PAJARES G,RIOMOROS I,et al. Automatic segmentation of relevant textures in agricultural images[J]. Computers and Electronic in Agriculture,2011,75(1):75-83.

[6] CHO S I,LEE D S,JEONG J Y. Weed-plant discrimination by machine vision and artificial neural network[J]. Biosystems Engineering, 2002,83(3):275-280.

[7] WOEBBECKE D M, MEYER G E, VON BARGEN K, et al. Shape features for identifying young weeds using image analysis[J]. Am,Soc,Agric, Eng,1995,38 (1):271-281.

[8] FRANZ E, GEBHARDT M R, UNKLESBAY K B. Shape description of completely visible and partially occluded leaves for identifying plants in digital images[J]. Transactions of the ASAE,1991,34 (2):673-681.

[9] MEYER G E, NETO J C. Verification of colour vegetation indices for automated crop imaging applications[J].? Computers and Electronic in Agriculture,2008,63(2):282-293.

[10] TANG L, TIAN L F, STEWARD B L, et al. Texture-based weed classification using gabor wavelets and neural network for real-time selective herbicide applications[J].? Urbana,1999,51(9):61-80.

[11] TANG L, TIAN L, STEWARD B L. Classification of broadleaf and grass weeds using gabor wavelets and an artificial neural network[J]. Transactions of the ASAE,2003,46 (4):1247-1254.

[12] CRUZ G,JESúS M,ROMEO G,et al. A new expert system for greenness identification in agricultural images[J]. Expert Syst, Appl,2013,40 (6):2275-2286.

[13] RAINVILLE F M, DURAND A, FORTIN F A, et al. Bayesian classification and unsupervised learning for isolating weeds in row crops[J]. Pattern Anal, Appl,2014,17 (2):401-414.

[14] 彭明霞,夏俊芳,彭輝. 融合FPN的Faster R-CNN复杂背景下棉田杂草高效识别方法[J]. 农业工程学报,2019,35(20):202-209.

[15] 孙俊,何小飞,谭文军,等. 空洞卷积结合全局池化的卷积神经网络识别作物幼苗与杂草[J]. 农业工程学报,2018,34 (11):159-165.

[16] CHEBROLU N, LOTTES P, SCHAEFER A, et al. Agricultural robot dataset for plant classification, localization and mapping on sugar beet fields[J]. The International Journal of Robotics Research,2017,36(10):1045-1052.

[17] HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[DB/OL]. http://arxiv.org/abs/1512.03385.

[18] KINGMA D, BA J. Adam:a method for stochastic optimization[J].? arXiv, 2014, 13(5):12-44.

[19] GLOROT X,BENGIO Y. Understanding the dif?culty of training deep feedforward neural networks[J]. Aistats,2010,9(2):249-256.

[20] VIJAY BADRINARAYANAN, ALEX KENDALL, ROBERTO CIPOLLA. Segnet: a deep convolutional encoder-decoder architecture for scene segmentation[J]. IEEE,2017,56(15):2481-2495.

[21] OLAF RONNEBERGER,PHILIPP FISCHER,THOMAS BROX. U-net: convolutional networks for biomedical image segmentation[J].? MICCAI, 2015, 9351(3):234-241.

(责任编辑:杜能钢)

- 中职英语教学中微课的应用与设计

- 浅析如何构建初中数学高效课堂

- 问题引领课堂 互动更有成效

- 浅谈高效课堂分组模式的建立

- 浅析导学案在课堂中的应用

- 多元情景教学模式如何有效应用到中职英语课堂

- 小学数学高效课堂教学策略浅议

- 小学数学概念课的课堂问题设计的研究

- 如何提高小学数学课堂教学效率

- 优化初中生物课堂教学之我见

- 微微风簇浪 散作满河星

- 让温情蔓延在低年级语文课堂

- 数学史融入初中数学课堂教学的策略

- 浅谈微课在中学化学实验课堂教学中的应用

- 浅谈小学数学兴趣课堂培养

- 优化初中化学“微课堂”有效教学的策略与方法

- 农村初中数学课堂教学中小组合作现状与对策

- 激发兴趣打造农村初中美术高效课堂

- 论游戏化教学在初中化学课堂教学中的应用

- 浅谈微课教学在小学语文教学中的应用

- 游戏教学——小学数学课堂中的“调味剂”

- 开展电脑作品制作提升信息课堂效率

- 重视生活数学,建构体验课堂

- 试论活动教学法运用于小学数学课堂教学的价值

- 新基础理念下初中语文互动生成式课堂教学有效性尝试

- subcivilization

- subcivilizations

- subcivilized

- subclan

- subclans

- subclausal

- subclauses

- subclavicular

- subclerk

- subclerks

- subclerkship

- subclerkships

- subclimate

- subclimates

- subclimatic

- subclique

- subcliques

- subcluster

- subclusters

- subcode

- subcodes

- subcollection

- subcollections

- subcollector

- subcollectors

- r2012111570014601

- r2012111570014604

- r2012111570014609

- r2012111570014612

- r2012111570014615

- r2012111570014619

- r2012111570014622

- r2012111570014628

- r2012111570014631

- r2012111570014639

- r2012111570014642

- r2012111570014645

- r2012111570014648

- r2012111570014660

- r2012111570014665

- r2012111570014670

- r2012111570014673

- r2012111570014679

- r2012111570014682

- r2012111570014685

- r2012111570014688

- r2012111570014693

- r2012111570014698

- r2012111570014706

- r2012111570014710