张晶晶 高永兵

摘要:该文对用户及产品信息进行分析,并尝试建立一个评论写作助手以帮助用户撰写评论。使用编码器-解码器框架以及注意力机制,通过编码用户历史评论、产品标题以及评级,经注意力增强的解码器解码,最终达到生成个性化评论的效果。在亚马逊电子产品数据集上的实验结果表明,我们的模型相比现有的基准模型在各项指标上都有所提升,且能够生成准确、个性化的评论。

关键词:编码器-解码器模型;自动生成评论;注意力机制

中图分类号:TP311? ? ? ? 文献标识码:A

文章编号:1009-3044(2020)23-0227-02

1 引言

由于越来越多的在线网站允许用户通过撰写评论来表达他们对产品的看法,例如亚马逊、淘宝和Yelp。然而,人工编写评论过于烦琐且浪费人力。因此,评论生成受到了研究人员的广泛关注,成为热点话题。

评论生成的目标是生成语言描述性能与人类语言相媲美的文本。此前,Lipton、Tang及Wang等团队提出了有关自动生成评论的方法。但是,他们只考虑数字上下文,如评级、用户ID或产品ID;又或者在解码时加入复制机制,从用户偏好词中复制一个词进行评论的生成。由于已提出的方法提供的信息有限,倾向于生成机械相似的评论,这导致在为不同的用户或产品生成评论时缺乏多样性 ,难以吸引顾客的注意。

因此,除了对用户的历史评论进行信息提取,以生成带有用户评价习惯的评论;我们还引入了产品标题信息,以生成更加多样化的评论。

2 相关工作

评论生成的目的是在特定的背景下生成现实的评论,这是一种文本生成。有一些关于评论生成的工作。Liption等人[7]使用字符級串联输入递归神经网络(RNN)作为生成模型来预测评论的评级和类别。而Tang等人[6]为了将用户ID、产品ID和评级三者结合在一起,提出了一种基于编码器-解码器的框架,该框架首先将上下文编码为向量,然后对其进行解码以生成评论。我们的模型采用了与Tang等人[6]相似的框架,且在模型中使用了注意机制,能够在每个时间步骤中注意不同的上下文。此外,我们的任务还涉及用户个性化。Wang等[1]提出了一种用户偏好感知的评论生成模型(UPRG), 利用用户偏好词来提高生成评论的多样性,在解码过程中引入用户偏好词,以生成不同的评论。我们则从用户的历史评论中分析了用户的评价习惯,提取了用户偏好词,丰富了用户相关信息。同时,利用了产品标题,丰富了产品相关信息。我们的方法可以为每个用户生成更准确、更个性化以及多样化的评论。

3 模型

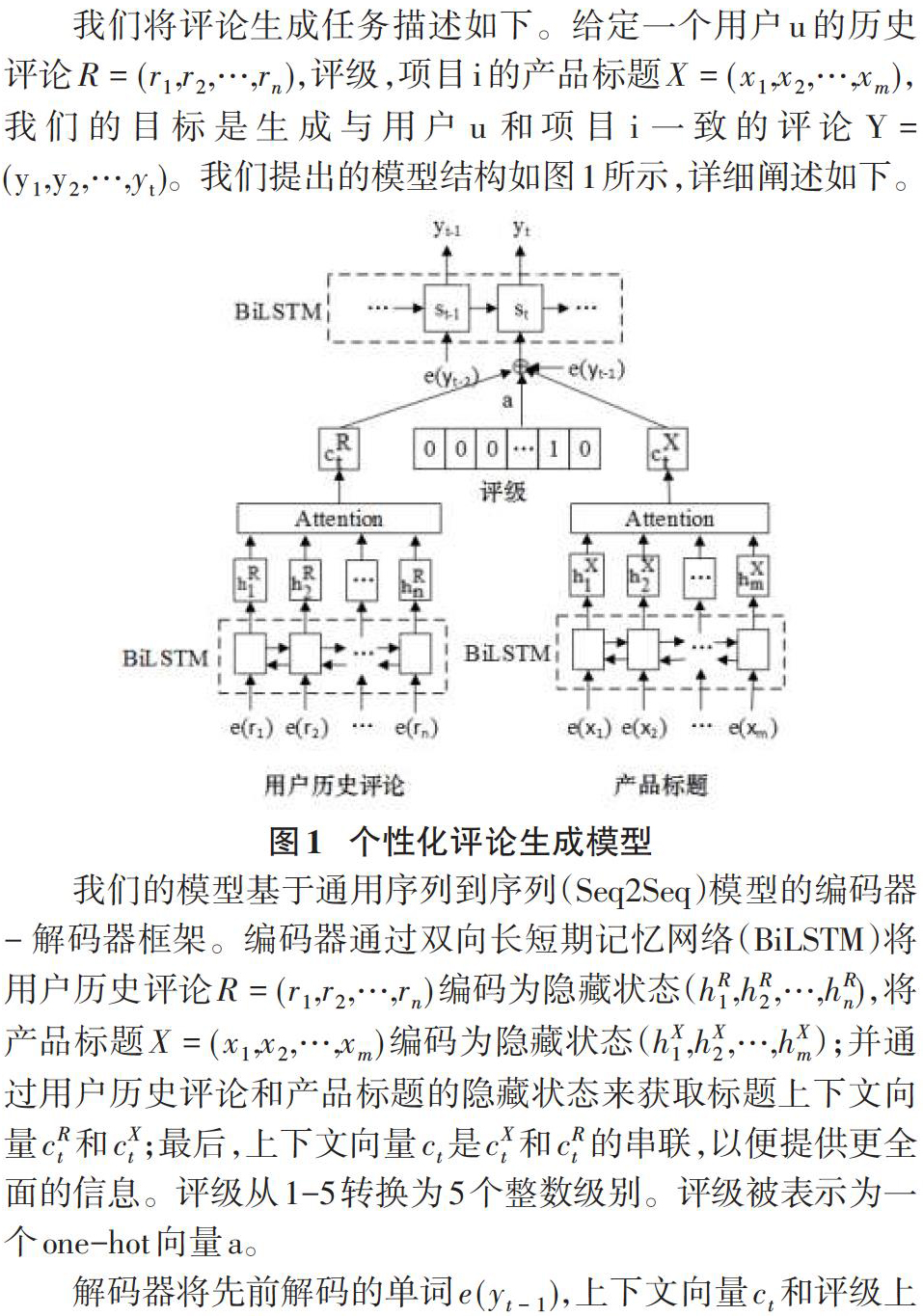

我们将评论生成任务描述如下。给定一个用户u的历史评论[R=(r1,r2,…,rn)],评级,项目i的产品标题[X=(x1,x2,…,xm)],我们的目标是生成与用户u和项目i一致的评论[Y=(y1,y2,…,yt)]。我们提出的模型结构如图1所示,详细阐述如下。

我们的模型基于通用序列到序列(Seq2Seq)模型的编码器 - 解码器框架。编码器通过双向长短期记忆网络(BiLSTM)将用户历史评论[R=(r1,r2,…,rn)]编码为隐藏状态([hR1,hR2,…,hRn]),将产品标题[X=(x1,x2,…,xm)]编码为隐藏状态([hX1,hX2,…,hXm]);并通过用户历史评论和产品标题的隐藏状态来获取标题上下文向量[cRt]和[cXt];最后,上下文向量[ct]是[cXt]和[cRt]的串联,以便提供更全面的信息。评级从1-5转换为5个整数级别。评级被表示为一个one-hot向量a。

解码器将先前解码的单词[e(yt-1)],上下文向量[ct]和评级上下文向量a嵌入作为输入以更新其状态[st]。最后,解码器从输出概率分布中抽取一个单词[yt]。该模型通过最大化地真值[Y*=(y*1,…,y*n)]的对数似然来训练。

4 实验

4.1 实验数据

我们使用来自亚马逊的真实电子数据集评估我们的模型。我们将单词的出现次数保持为词汇的10倍,过滤掉少于两个和超过100个词的评论,并删除评论和产品标题中具有低频率的单词。我们将数据集分为训练集(80%),验证集(10%)和测试集(10%)。

4.2 结果

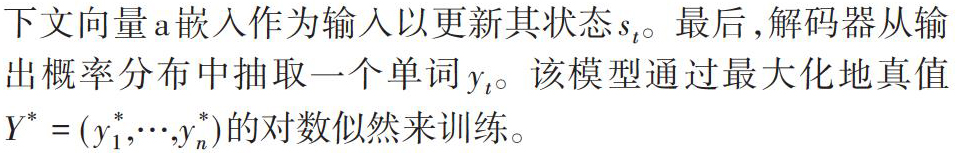

我们在五个评价指标上与基线模型Attr2Seq进行了比较。比较结果如表1所示。

由上表可知,我们的模型在各项指标上都获得最佳性能。并且,可以观察到Attr2Seq模型的Distinct指标非常低,是因为在生成过程中没有考虑产品信息,从而导致生成的评论缺乏多样性。相比之下,我们的模型有效地利用了产品信息,提高了生成结果的准确性和多样性。

4.3 生成示例

我们的样本生成示例如图2所示。

5 结论

在本文中,我们介绍了自动生成个性化评论的任务。我们利用用户的历史评论以生成个性化的评论;同时,利用评级、产品标题信息丰富上下文,最终生成满足用户需求的评论。评估结果表明,我们的模型超越了基线模型,且能够生成多样化、个性化的评论。

参考文献:

[1] Wang W, Zheng H T, Liu H.User Preference-Aware Review Generation[C].? Macau:Springer, 2019: 225-236.

[2] Li P, Tuzhilin A. Towards Controllable and Personalized Review Generation[C].Hong Kong:Association for Computational Linguistics, 2019: 3235-3243.

[3] Ni J, Mcauley J. Personalized Review Generation By Expanding Phrases and Attending on Aspect-Aware Representations[C]. Melbourne:Association for Computational Linguistics, 2018: 706-711.

[4] Dong L, Huang S, Wei F, et al. Learning to Generate Product Reviews from Attributes[C].Valencia:Association for Computational Linguistics, 2017: 623-632.

[5] He R, Lee W S, Ng H T, et al. An Unsupervised Neural Attention Model for Aspect Extraction[C]. Vancouver:Association for Computational Linguistics, 2017: 388-397.

[6] Tang J, Yang Y, Carton S, et al. Context-aware Natural Language Generation with Recurrent Neural Networks.[J]. arXiv: Computation and Language, 2016.

[7] Lipton Z C, Vikram S, Mcauley J, et al. Capturing Meaning in Product Reviews with Character-Level Generative Text Models[J]. arXiv: Computation and Language, 2015.

【通联编辑:代影】

- 浅谈大一新生班干部的选拔与培养

- 习近平关于党支部建设的重要论述

- 高校贫困生资助效益现状分析及其对策

- 论《习近平在文艺工作座谈会的重要讲话》的人文关怀

- 提高师范生素质和修养途径探析

- 浅议习近平“党性与人民性相统一”的思想

- 高校社团与专业学科协调发展模式构建探析

- 毛泽东认识论研究

- 网络技术优化高校校园文化建设路径探析

- 西宁市发展民族经济的调研报告

- 绿色发展理念下探索肇庆高质量发展路径

- 微信时代如何做好医学大学生党建工作的探讨

- 成都市驷马桥社区加强和改进社区居民思想政治工作调研

- 基于O2O模式的基层学生党组织建设探析

- 浅谈唐顺陵石狮的艺术特征与价值

- 浅谈陕北特色古镇的旅游发展

- 高校学生党员管理模式创新探究

- 信息化环境下高校人才培养保障体系构建探索

- 农村中小学汉语教学存在的问题与对策

- 微信使用对大学生人际交往的影响研究

- 浅析高校招生工作特点及对工作人员的素质要求

- 材料类专业开放性实验项目探索与完善

- 推行高校教师学术休假制度初探

- 全日制专业学位硕士教育调查与对策

- 人的初级本质与社会主义初级阶段

- resignals

- re-signals

- resignation

- resignationism

- resignationist

- resignations

- resigned

- resignedly

- resignedness

- resignednesses

- resignedness's

- resignee

- resigner

- resigners

- resigning

- resignment

- resigns

- resign yourself to/be resigned to

- resign yourself to sth

- resilience

- resiliences

- resiliency

- resilient

- resiliently

- resilver

- 精神体

- 精神体力都很疲惫

- 精神充沛

- 精神充满

- 精神充足

- 精神充足旺盛

- 精神兴奋

- 精神兴奋得意

- 精神冰雪

- 精神分析学派

- 精神分析的重要先驱

- 精神分裂症

- 精神力气

- 精神卫生

- 精神反常

- 精神发育迟滞

- 精神发育重度不全的病

- 精神受到严重刺激而发生精神病的症状

- 精神变态

- 精神可嘉

- 精神和体力

- 精神和体力都极度劳累

- 精神和志气丧失

- 精神和物质享受

- 精神和身体