张翠 周茂杰

摘? 要: 现在文本情感分类普遍采用深度学习的方法。卷积神经网络可以较好地提取局部特征,但是缺少對上下文的理解。长短记忆网络可以有效记忆较长距离的信息,有较强的全局性。为实现全局特征与局部特征的有效融合,研究了一种融合两种特征的深度学习方法,构建深度学习网络模型。利用互联网中获取的文本作为训练语料及测试语料,在百度开源平台PaddlePaddle上进行实验。实验结果显示,该算法与传统CNN和LSTM模型算法相比,识别的准确率分别提高了2.65和1.87个百分点,说明该模型算法在文本情感分类的性能上有所提高。

关键词: 卷积神经网络; 双向长短记忆网络; 融合; 情感分类

中图分类号:TP311? ? ? ? ? 文献标志码:A? ? ?文章编号:1006-8228(2019)12-38-04

A text emotion classification method based on CNN and bidirectional LSTM fusion

Zhang Cui1, Zhou Maojie2

(1. BowenCollege of Management, Guilin University of Technology, Guilin, Guangxi 541006, China; 2. Guilin University of Technology)

Abstract: Nowadays, deep learning is widely used in text emotion classification. CNN (convolutional neural networks) can extract local features well, but it lacks the understanding of context. LSTM (long and short memory networks) can effectively memorize long-distance information and have a strong global character. In order to achieve the effective integration of global and local features, this paper studies a deep learning method with the fusion of the two, and constructs a deep learning network model. Using the text obtained from the Internet as training corpus and testing corpus, experiments are carried out on Baidu open source platform PaddlePaddle. The experiment results show that compared with the traditional CNN and LSTM models, the recognition accuracy of the proposed algorithm is improved by 2.65 and 1.87 percentage points respectively, which shows that the performance of this model in text emotion classification is improved.

Key words: convolutional neural networks; bidirectional long-short memory networks; fusion; emotion classification

0 引言

随着互联网的高速发展,自媒体时代已经到来,人们可以随时随地发表观点和评论,互联网中的文本呈爆炸式增长。如何在网络文本中挖掘有价值的信息,这是当前一个重要的课题。网络文本具有一定语义,同时带有情感倾向,对于如何评价一类文本,人们更关心的是这条信息属于正面还是负面,也就是情感极性,而不是具体的评论细节,只要了解评论的极性就实现了文本的价值,进而可以通过大量的评价数据做出正确的决策。由于网络文本较多,我们很难通过人工分析来完成所有的文本情感分类。机器学习方法能自动完成文本的情感分析,为文本的情感分类提供了便利。

近年来,深度学习取得了较大的进展。深度学习首先是在图像处理及音频识别领域中取得了成功,一些学者将此方法推广应用到文本处理上,经过多年的应用实践,证明深度学习方法用在文本处理上是可行的。与传统的文本分类算法相比,深度学习算法能自动提取特征,加快处理速度,显著提高分类效果。

深度学习的核心是利用多重非线性变换结构对数据进行高阶抽象,并最终完成数据特征识别的一种算法[1]。神经网络是深度学习中重要的模型之一,经过多年的发展,产生了多个变种,每种神经网络都有自己的优势。卷积神经网络(CNN)利用卷积核进行移动计算,可以较好的提取局部特征[2-4],但利用CNN进行文本识别,不能解决长文本的上下文依赖。

循环神经网络(RNN)以序列形式输入数据[5],输出数据要对当前数据及前后数据都有所依赖,可以提取全局特征,LSTM(Long Short-Term Memory)是循环神经网络的一种,利用三门设计方法,解决了长期依赖导致的梯度消失和梯度爆炸问题[6]。

本文设计一种CNN与LSTM结合的深度学习模型,发挥CNN的局部特征提取优势,并且从全局上理解文本的情感特征。首先利用CNN提取局部特征,利用LSTM获取上下文相关信息,然后将两种特征信息的向量进行拼接,拼接后的特征向量作为文本的特征向量,将两种神经网络有机结合,在文本情感识别上取得较好效果。

1 相关工作

情感分析的原理是通过对情感文本的分析,挖掘出文本所表达情感的极性和强烈程度。目前,情感分类主要是通过规则、情感词典和机器学习两种方法。近年来,机器学习方法取得了较大进步,情感分类的效果也大大改善。

机器学习方法中用得最多的是卷积神经网络(CNN)和循环神经网络(RNN)。Kalchbrenner等提出了利用CNN来进行自然语言处理[7],提出了动态卷积神经网络(DCNN) 模型,适应不同长度的文本,对不规则文本的处理效果较好;Kim在利用词向量与卷积神经网络结合实现了句子级的分类任务[8]。卷积神经网络在文本分类应用中取得了较大的进步,但是它更关注局部特征,忽略了上下文的关系,文本的语义和情感都对上下文有较强的依赖作用,所以在文本的语义情感分类中,准确率有一些影响。

循环神经网络以序列形式接受文本中的词向量输入,不但有当前位置上的信息,而且有临近位置的信息,可以有效地解决上下文依赖问题[9]。长短记忆网络模型是循环神经网络的一个子类,它在神经网络单元中加入三个门,可以避免长距离依赖产生的梯度消失问题,同时具有更强的记忆功能,对文本的识别能力更强。

2 情感模型研究

2.1 CNN模型

卷积神经网络利用卷积核与原始数据相乘,提取局部特征,因为在一个卷积神经网络中可以采用多个不同类型的卷积核,从而提取多个局部特征,因此具有较强的局部特征提取能力。因为相邻的词之间具有一定的修饰关系,并可以表达出情感倾向,所以本文在进行文本情感识别时,首先利用word2vec方法将文本构造成向量集,在文本的向量集合中采用卷积运算,进行局部特征提取,经过池化层后得到用于分类的输出向量,最后利Softmax函数进行数据分类。

例如,句子分词后得到n个词,表示为:[S=w1,w2,…,wn],其中wi表示句中第i个词,向量化后可得[wi=Vwi],其中[Vwi∈Rn*d],表示S由组成n个词构成,每个词转化为d维向理,构成了向量矩阵。

在分类时,把词向量当作独立的个体,所以采用Fk=k*d维卷积核与向量矩阵进行卷积计算,分别表k个词之间的局部联系,特征提取如公式⑴所示。

⑴

Ci表示经过一次卷积计算得到的局部特征值,f表示一个RELU函数,Fk表示k*d维滤波器,b表示偏置值,经过卷积核在矩阵上滑动计算一轮后得到完成的一个完整的局部特征向量C,记为:

⑵

为了降低向量维度,采用最大池化函数对C进行池化操作,。其中m为池化宽度。

⑶

di为卷积所提取特征,将所有的特征向量送到全连接层,最后的用Softmax激活函数的输出层。可以根据输出数据判断出输入词向量的情感极性。

2.2 LSTM模型

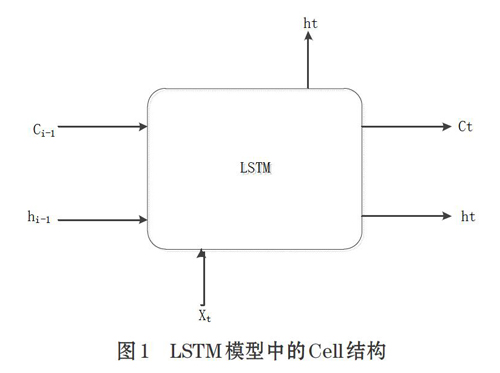

1997年,Hochreiter首先提出了长短记忆网络LSTM(Long Short-Term Memory)[7],它是一种特殊循环神经网络(RNN),它可以有效解決RNN的梯度消失或梯度爆炸的问题,能够学习到长期的依赖关系。与RNN相比,LSTM对神经单元(Cell)的控制器进行了设计,能够判断信息是否有用,Cell控制单元如图1所示。

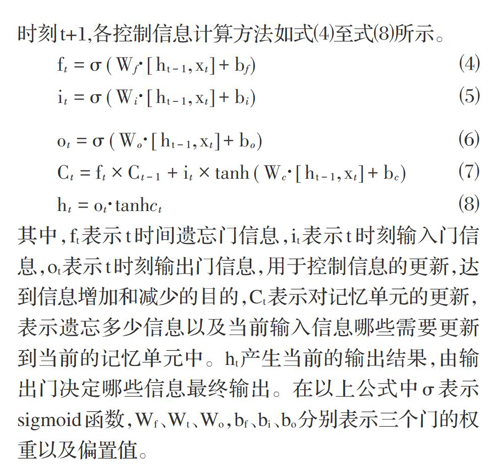

在 LSTM模型中的控制单元由一个用于记录状态的记忆单元C和3控制数据流向的门(输入门i、输出门o和遗忘门f)组成。在时间节点t,数据进入控制单元后,通过计算,LSTM可以选择记住或者遗忘某些信息,控制信息输出,并将这些状态信息传递到下一时刻t+1,各控制信息计算方法如式⑷至式⑻所示。

其中,ft表示t时间遗忘门信息,it表示t时刻输入门信息,ot表示t时刻输出门信息,用于控制信息的更新,达到信息增加和减少的目的,Ct表示对记忆单元的更新,表示遗忘多少信息以及当前输入信息哪些需要更新到当前的记忆单元中。ht产生当前的输出结果,由输出门决定哪些信息最终输出。在以上公式中[σ]表示sigmoid函数,Wf、Wt、Wo,bf、bi、bo分别表示三个门的权重以及偏置值。

利用LSTM解决了对当前词的前文的依赖问题,但不能利用当前词之后的信息。一个词的语义和情感不仅与之前的历史信息有关,还与当前词之后的信息有着密切关系,所以本文利用采用双向LSTM,一组词向量分别作为正向和反向LSTM网络的输入,两个LSTM的输出合并之后,采用Softmax函数进行分类。如图2所示。

2.3 CNN与LSTM融合模型

为了更好的利用文本的局部信息和全局信息,将两种特征融合在一起,作为文本情感识别的判别依据。系统模型采用分层结构,第一层为已经进行了预处理的词向量,可以直接在系统中使用,第二层中包括一个CNN神经网络和一个LSTM网络。第三层为特征融合层,先对两个输出值拼接,接到一个全连接层上。第四层为输出层,采用softmax函数计算出文本的情感词性。CNN与LSTM融合模型如图3所示。

3 实验分析

本文采用百度paddlepaddle开源实平台及并利用AIStudio提供的计算资源进行实验,所配置的环境是双核CPU和8G内存。

实验数据集采用网络中获取的文本资料,一共10000条,包括:政治、经济、文学、体育、美食五个大类,每类数据2000条。

首先采用结巴分词将这些语料进行分词操作,然后采用word2vec转化成词向量,导入paddlepaddle系统模型中,对本文构建的系统模型进行训练,并进行调参操作,通过固定参数的方法,取100维词向量,滑动窗口大小比较2、3、4,滑动窗口数量分别取40、80、120,在学习率为0.01时效果最佳。实现结果如表1所示。

4 总结

本论文采用CNN与双向LSTM结合的方法进行文本情感分类,结合到了CNN的局部特征提取能力及LSTM的上下文依赖能力,在PaddlePaddle开源平台上进行实验,利用Python语言实现此模型的构建,利用同一数据集作为输入,对本文设计的模型与CNN模型,以及LSTM模型进行实验,输出文本情感识别的准确率,比较识别效果,本文算法均有所提高。接下来的研究,可以增加LSTM网络的堆叠层数及改变融合方式,增加注意力机制,以达到进一步提高情感识别效果的目的。

參考文献(References):

[1] Qi Fang,Heng Li,et al.A deep learning-based method for detecting non-certified work onconstruction sites [J].Advanced Engineering Informatics 35 (2018) 56–68

[2] LIU C Y,SUN W B,CHAO W H,et al.Convolution neural network for relation extraction[C]// International Conference on Advanced Data Mining and Applications. 2013.

[3] ZENG D J,LIU K,CHEN Y B,et al. Distant supervision for relation extraction via piecewise convolutional neural networks[C]// The 2015 Conference on Empirical Methods in Natural Language Processing. 2015.

[4] KALCHBRENNER N,GREFENSTETTE E,BLUNSOM P. A convolutional neural network for modelling sentences [J/OL] arXiv preprint,2014,2014:arXiv:1404.2188[2014-04-08].https: //arxiv.org /abs /1404.2188.

[5] EBRAHIMI J,DOU D. Chain based RNN for relation classification. [EB/OL].[2014-09-03]. http//www.aclweb.org/anthology/N/N15/N15-1133.pdf.

[6] HOCHREITER S,SCHMIDHUBER J. Long short-term memory[J].Neural Computation,1997,9(8):1735 -1780

[7] KIM Y. Convolutional neural networks for sentence classification[EB/OL].[2014-09-03]. http://emnlp2014.org/papers/pdf/EMN-LP2014181.pdf.

[8] ZHANG S, ZHENG D Q, HU X C, et al. bidirectional long short-term memory networks for relation classification[C]// PACLIC. 2015.

[9] CHO K, van MERRIENBOER B, CULCEHRE C,et al. Learning phrase representions using RNN encoder decoder for statistical machine translation[EB/OL].[2014-09-03].http://www.aclweb.org/antology/D/d14/d14-1179.pdf.

- 煤矿井下低压电网相敏保护算法的研究与探讨

- 导游实务课程第二课堂实践教学研究

- 新时期应用型本科院校辅导员队伍建设存在的问题及对策

- 校史档案在高校校园文化建设中的作用探析

- ZigBee组网技术在智能温室系统中的运用

- 地域文化在高职语文课程中的传承探析

- 村干部学历教育班教学质量提升的困境与对策

- 基于“政产学研用”协同创新的卓越农林人才培养探索与实践

- 现代学徒制下高职会计专业人才培养研究

- 地方高校思政教师队伍建设存在的问题与对策

- 大学生创业影响因素及对策研究

- 高职院校在校企合作中的障碍及对策

- “00后”大学新生入学教育方法的创新

- “翻转课堂”教学模式实施策略剖析

- 高职院校学生内含性核心职业能力内涵研究

- 基于概率统计的数据挖掘预测算

- 普通高校研究生兼职本科生辅导员的优势、问题及对策

- 新型职业农民培育的硕士学位论文研究综述

- 高职院校财会专业学生学习方式变革探究

- 加强闽台农业科技合作的策略研究

- 图书馆知识管理对图书馆管理的创新

- “95后”藏、汉族农学生心理健康状况的比较分析

- 夯实农村党组织建设 发挥战斗堡垒作用

- 读者信息服务视角下高校图书馆管理策略

- 校园文化视角下高职院校图书馆建设思路

- rebuilded

- rebuilder

- rebuilders

- rebuilding

- rebuilds

- rebuilt

- rebukable

- rebuke

- rebukeable

- rebuked

- rebukeful

- rebuker

- rebukers

- rebukes

- rebuking

- rebunker

- rebuoy

- reburial

- reburials

- reburial's

- reburied

- reburies

- reburying

- re-bush

- rebut

- 雾丝

- 雾中照相

- 雾中的行船

- 雾中追车

- 雾乱

- 雾乱没颠没倒

- 雾会

- 雾光

- 雾关云洞

- 雾兴云涌风起泉涌

- 雾凇

- 雾凇重雾凇,穷汉置饭瓮

- 雾凝聚在树枝上的白色松散的冰晶

- 雾勃

- 雾区

- 雾卷霞开

- 雾叠

- 雾合

- 雾合云集

- 雾吐

- 雾和雨

- 雾和雪

- 雾唾

- 雾喷

- 雾图