刘咏平 吴玉婷 刘杰 郝刚

摘要:为了解决高性能云计算环境中计算资源利用率不高、短期用户需求大的问题,本文提出一种基于多负载均衡的自适应云计算资源管理模型,通过采用多种负载均衡实现算法,并动态地根据现有任务分配来评估,最终由评估结果使用最优负载均衡,使得等待作业可以高效地均衡分布在不同的资源上运行,从而增加系统的吞吐量及性能。

关键词:云计算;资源管理;按需切换

中图分类号:TP391? ? ?文献标识码:A

文章编号:1009-3044(2021)10-0060-03

1引言

目前大部分铝型材企业对生产模具的管理主要通过建立模具管理仓库对模具进行统一管理,并在模具上粘贴二维码用于识别模具型号。由于铝材的生产过程需要经过多个流通环节(出库、抛光、加热、上机、下机、碱洗、包膜、入库等),且其中存在的多个环节需要经过高温及碱洗,使得模具上粘贴的二维码极易失效。为保证对模具的每一个环节做好记录,需要人为对二维码失效的模具重新粘贴上二维码。二维码标签的重复粘贴大大降低了工业生产的效率,且多次人为识别模具编码制作二维码的过程增加了模具记录的错误率。因此需要一种新的技术方案实现模具编码识别,提高生产模具管理的便利性。

2相关工作

Mask RCNN模型去完成特定的目标检测任务时,一般通过保持原始模型的主体结构,简单修改模型最后的输出层,并使用特定任务的训练样本对模进行训练,以此实现将模型用于特定任务。虽然模型在众多公开数据集[1, 2]均取得了优异的结果,但是由于众多公开数据集主要由自然场景训练样本组成,无法保证针对特定的工业生产环境图片下模型还具有良好的表现。而针对一个特定任务重新设计出一个性能良好的网络模型需要大量专业先验知识,且消耗大量的人力物力。针对这一问题,神经网络架构搜索技术的出现实现了神经网络结构的自动搜索。目前的神经网络架构搜索策略主要有进化算法[3]、强化学习[4]、可微分[5]三种。[3]遗传算法策略虽然能够搜索到表现优秀的网络的结构,但是其效率极其低下,需要消耗大量的计算资源。NASNet[4]使用强化学习策略,在cifar-10集imagenet数据集[1]上得到了优秀的结果,但是其同样需要消耗巨大的计算力;NASNet[4]要求2000gpu天才能得到最好的结果。NAS-FPN[6]在maskrcnn[6]模型基础上成功的搜索出了一个目前最优的特征金字塔结构,NAS-FPN[6]无论是在参数量,计算时间,准确率都要优于目前最好的模型,但该模型需要在100块TPU上完成训练。各类优化策略如ENAS[7]通过共享权重的方式使网络能够在0.5GPU天下收敛,但是效果上没有超过人为设计的网络。NAO[8]则通过将架构嵌入到连续潜在空间中利用梯度下降将进行优化,将搜索代价缩减到200GPU天。基于可微分的神经架构搜索策略DARTs[18]通过共享网络结构并从中采样网络子结构的形式取代单独的网络结构进行训练的方式进行网络搜索,这一措施使模型在Cifar数据集下能只用1个GPU天便使模型收敛,大大降低了网络搜索的成本,且能迁移到Imagenet[1]数据集上得到很好的表现。HNAS[10]则是在[5, 9]的基础上将细胞级的搜索策略上升到了网络级的搜索策略,并成功应用于语义分割上面,得到目前最优的结果。基于可微分的神经架构搜索策略[5, 9]在训练时间上均只需要几个GPU天,便能得到优秀的网络结构。

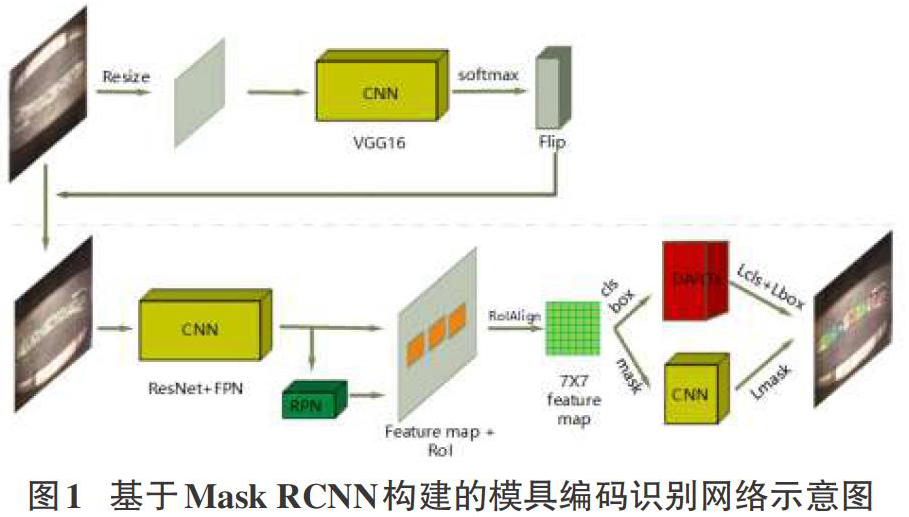

本文提出了一种基于Mask RCNN的模具编码识别方案。同时考虑到各种方法对Mask RCNN进行改进的模型无法保证针对模具编码检测任务效果的问题,重新设计网络结构的不便性以及基于强化学习进行架构搜索计算资源消耗大的问题。本文在保持Mask RCNN网络的主体结构(特征提取网络,FPN,RPN网络)的基础上,基于DARTs[5]构建RCNN网络,解决了面向公开数据集训练得到的模型无法适应模具编码识别任务的问题。

3 基于Mask RCNN的模具编码识别方法研究

基于Mask RCNN构建的模具编码识别网络结构如图1所示。由于模具编码中存在数字6,9,且无法保证输入图片的方向,直接使用目标检测算法进行模具编码识别会造成数字6、9分类的巨大的错误率。因此,本文通过在输入图片时通过级联一个翻转识别网络以解决数字6、9分类错误率高的问题。在翻转网络对输入进行图片处理后再送到下级网络。下级则是基于darts对Mask RCNN中的rcnn网络进行优化搭建的目标检测网络。

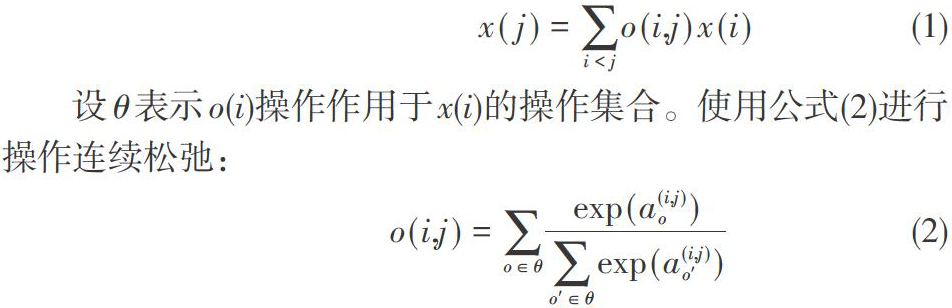

本文以[14]的研究为基础,使用cell作为模型结构搜索的单位。本文设定网络边界操作集合θ=(3X3,5X5可分离卷积,3X3,5X5空洞卷积,3X3最大池化,3X3均值池化,跳跃连接,0连接)。设定每个cell包包含七个节点,其中两个输入,一个输出,四个内部节点,节点间通过有向无环进行连接。设o(i, j)表示结点x(i)和x(j)的操作连接,那么可得:

设θ表示o(i)操作作用于x(i)的操作集合。使用公式(2)进行操作连续松弛:

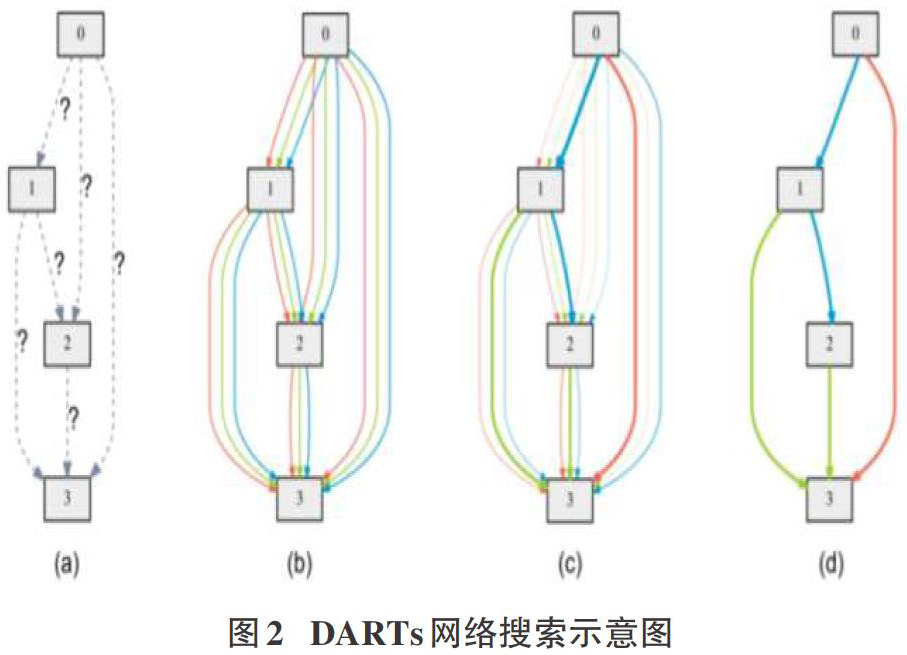

其中a(i,j)表示两个结点直接的连接权重,经过公式(2)的松弛之后,模型结构搜索的任务转变成了对连续变量a的学习。a參数学习过程示意图如下:

图2(a)表示初始网络结点未知;图2(b)给定集合中操作将结点连接并将参数进行连续松弛;图2(c)通过混合概率优化解决网络结点α及w权重的双重优化问题;最后通过最大化可能操作得到一个离散的网络结构参数如图4(d)所示。最终将多个cell进行堆叠得到完整网络结构。

基于DARTs构建的RCNN网络以RoIAlign输出为输入。网络损失函数Loss = Ldarts+Lmask,其中Ldarts = Lcls+Lbox。

3 实验结果及分析

为了验证本文算法有效性,建立实验仿真环境:CPU处理器为i7 8700,内存为16GB,显卡为GTX 1080Ti X2,硬盘为2T,实验平台为Ubuntu 18.04。

数据集中图片的尺寸不统一,因此在将图片送入到翻转检测网络之前,将图片进行双线性插值法统一图片尺寸为244X244。同时使用imagenet数据集构建预训练模型,训练过程中固化卷积层参数,只对全连接层进行训练。设定学习率为0.001,迭代次数为1000。

MASK R-CNN网络特征提取使用resnet101预训练模型,选择resnet101的conv4作为特征输出图。设定scales为[68, 128, 256],设定纵横比为[1, 2];设置IOU阈值为0.5用于进行非极大值框融合,设置预测结果阈值为0.85,抛弃分数小于0.85的预测框。设置学习率为0.003,迭代次数为300。

如表1所示,在IoU为0.5和0.75下,均有三个指标性能(ac,miss,overall)优于Mask RCNN和FAST RCNN模型:在IoU为0.5下,本文方法ac评价达到97.23%,优于原始Mask RCNN 1.96%。在IoU为0.75下,本文方法ac评价达到81.27%,优于原始Mask RCNN 4.83%.

4 结论及未来工作

本文提出的一种基于DARTs的Mask RCNN模具编码识别方法。该方法首先定义网络细胞结构,然后用DARTs技术训练网络细胞结构,最后用训练后的网络细胞堆叠重构Mask RCNN网络中的分类回归分支,实现对模具编码的Mask RCNN目标检测网络。实验结果表明,在IoU为0.5下,本文方法比传统MASK RCNN方法的检测性能提升约1.96%;在IoU为0.75下,本文方法比传统MASK RCNN方法的检测性能提升约4.83%。

参考文献:

[1] Deng, J., et al. Imagenet: A large-scale hierarchical image database. in 2009 IEEE conference on computer vision and pattern recognition. 2009. Ieee.

[2] Lin, T.-Y., et al. Microsoft coco: Common objects in context. in European conference on computer vision. 2014. Springer.

[3] Real, E., et al., Regularized evolution for image classifier architecture search. arXiv preprint arXiv:1802.01548, 2018.

[4] Zoph, B., et al. Learning transferable architectures for scalable image recognition. in Proceedings of the IEEE conference on computer vision and pattern recognition. 2018.

[5] Liu, H., K. Simonyan, and Y. Yang, Darts: Differentiable architecture search. arXiv preprint arXiv:1806.09055, 2018.

[6] Ghiasi, G., T.-Y. Lin, and Q.V. Le. Nas-fpn: Learning scalable feature pyramid architecture for object detection. in Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2019.

[7] Pham, H., et al., Efficient neural architecture search via parameter sharing. arXiv preprint arXiv:1802.03268, 2018.

[8] Luo, R., et al. Neural architecture optimization. in Advances in neural information processing systems. 2018.

[9] Liu, C., et al., Auto-DeepLab: Hierarchical Neural Architecture Search for Semantic Image Segmentation. arXiv preprint arXiv:1901.02985, 2019.

[10] Shin, R., C. Packer, and D. Song, Differentiable neural network architecture search. 2018.

【通聯编辑:梁书】

- 战略性人力资源管理视角下的新入职员工成长双向调研

- 银行个人住房贷款风险及控制对策

- 浅析特惠金融扶贫信贷的风险控制

- 嘉兴市上市公司融资方式的选择及影响因素研究

- 基于优化BP神经网络的P2P投资组合定量分析

- 基于主成分分析的我国保险公司偿付能力研究

- 浅谈如何加强房地产企业股权转让涉税管理

- 当前税收筹划中应正确认识的几个问题

- 存款保险制度、规模偏好与存款人市场约束

- 建筑企业“营改增”的影响及对策分析

- 浅析房地产业融资的困境及出路

- 职业声望能真实反映还款能力和信用风险吗?

- 对企业所得税纳税筹划策略分析

- 高校政府采购的财务管理探究

- 关于新时期水利财务管理工作的几点认识

- 医院财务管理策略研究

- 中小企业财务管理存在的问题及对策研究

- 从一份移交清册谈企业内控建设

- 事业单位固定资产管理中存在的问题及对策

- 建筑企业财务处理中的既有问题及完善策略

- 地方政府债务风险控制策略研究

- 探讨“村账乡管”模式下难题的破解

- 制造业成本会计的发展与挑战

- 建筑工程的造价审计措施解析

- 集团企业财务共享服务中心模式分析与研究

- fobbing

- fobs'

- fobs

- fob sb off with

- fob sb off (with sth)

- focal

- focal-distance

- focal distances

- focalization, focalisation

- focal length

- focal lengths

- focally

- focalpoint

- focal point

- focal points

- foci

- foci's

- focus

- focusable

- focus attention on

- focused

- focuser

- focusers

- focuses'

- focuses

- 老大男

- 老大老实

- 老大虫

- 老大难

- 老天

- 老天不下雨,当家的不说理——没法治

- 老天不下雨,老人不说理——没法治

- 老天不扶苦命人

- 老天不负有心人

- 老天不负苦心人

- 老天偏害没儿人

- 老天偏折墙头草

- 老天八地

- 老天巴地

- 老天拔地

- 老天爷

- 老天爷不下雨,当家的不说理——无法可治

- 老天爷没绝人之路

- 老天爷的宠儿

- 老天爷睁眼

- 老天爷瞎了眼

- 老天爷要下,寡妇要嫁——谁也拦不住

- 老天爷饿不死瞎家雀

- 老天爷饿不死瞎家雀儿

- 老天牌