〔摘要〕大数据的规模性、高速性和数据来源的多样性,使数据更可能产生不一致和冲突,这会导致大数据质量问题。本文在界定大数据质量内涵及其维度的基础上,分析大数据处理流程中数据收集、数据预处理、数据存储、数据处理与分析、数据可视化及应用等环节对大数据质量的影响及关键因素,构建大数据流程的质量影响模型,并提出大数据质量保障的建议与措施。

〔关键词〕数据质量;大数据流程;质量影响模型;影响因素

DOI:10.3969/j.issn.1008-0821.2017.03.013

〔中图分类号〕G203〔文献标识码〕A〔文章编号〕1008-0821(2017)03-0069-04

〔Abstract〕The large scale,high-speed and diversity of data sources in big data,make it more likely to have inconsistency and conflict,which lead to quality issues of big data.In this article,the paper defined connotation of big data quality and its dimensions,and then analyzed the influence that data collection,data preprocessing,data storage,data processing and analysis,data visualization and its application in the procedure of big data processing exerted on big data quality and key factors;finally,the paper constructed a quality influencing model in big data process,and put forwards suggestions on quality assurance of big data.

〔Key words〕data quality;big data process;quality influencing model;influence factors

大数据时代,强调对总体数据的处理与分析,关注事物之间的相关关系,以及对发展趋势的分析预测。大数据的规模性、高速性和数据来源及形式上的多样性,使数据更可能产生不一致和冲突,这些都会导致大数据质量问题,因此需要对大数据进行质量管理。大数据主要由社交网络、移动计算、监控设备和传感器等信息源产生,包括用户多媒体服务数据、服务系统监控与管理数据、用户行为数据、服务市场环境和客户关系数据等。大数据的来源复杂性和类型多样性造成价值密度低、提取难度大等特点,同时也给大数据质量管理带来了困扰。

在大数据质量的相关研究中,宗威等[1]在分析大数据特点的基础上,提出了大数据环境下数据质量的重要性及其挑战,并分别从大数据流程、大数据技术和大数据管理3个视角提出如何保证大数据质量,尤其在大数据流程方面,主要从数据收集、存储和使用3个阶段提出了质量保证的建议。胡雄伟等[2]提出大数据中的数据质量问题涉及数据收集、使用、发布的整个过程,贯穿数据管理工作的始终,并分析了美国颁布的《数据质量法》中的3个数据质量原则——数据质量标准、质量管理流程和数据质量救助机制。Vijay Khatri等[3]设计了大数据治理的5个决策领域,包括数据准则、数据质量、元数据、数据访问和数据生命周期。Sharma等[4]提出有效的数据资产管理,必须涉及元数据管理(Meta Data)、数据质量(Data Quality)、数据标准、数据架构、数据权限(Right)、数据安全性(Safety)、数据生命周期(Data Lifecycle)、主数据管理(Master Data Management)等各个方面。王宇德[5]提出利用信息架构原则和实践,实现大数据与企业数据的灵活集成,达到大数据治理的目标。其中大数据信息架构的主要原则是通过价值、成本和风险透镜将数据视为资产,并确保数据的时效性、质量和准确性;由于大数据的质量和准确性要求存在巨大差异,需要对其进行合适的取舍以满足实际需求。马晓亭[6]以图书馆大数据为研究对象,提出为保证图书馆大数据的价值分析与服务质量,需进行大数据质量管理,如管理员从全局层面挖掘数据间的相关关系,加强对读者阅读行为、阅读关系和阅读社交舆情等大数据资源的质量管理,注重大数据质量管理中的用户隐私保护等,实现以读者个性化需求为中心的图书馆大数据价值发现。本文将在界定大数据质量内涵及其维度的基础上,分析大数据处理流程中数据收集、数据预处理、数据存储、数据处理与分析、数据可视化及应用等环节对大数据质量的影响及其因素,构建大数据流程的质量影响模型,并提出大数据质量保障的建议与措施。

1大数据质量的界定

11大数据质量

美国著名咨询公司麦肯锡给出的大数据定义(2011)是“数据规模超出典型数据库软件工具收集、存储、管理和分析能力的数据集”,维基百科给出的定义是“大数据指所涉及的数据量规模巨大到无法通过人工在合理的时间内达到截取、管理、处理并整理成为人类所能解读的信息”。由此可见,大数据区别于传统数据的本质特征在于大数据已超出了传统常规软件的数据处理能力,只有采用新平台、新技术才能有效处理的数据集,因而催生了大数据技术、大数据平台和大数据应用等的发展。

业界普遍认可的国际数据公司IDC定义的大数据具有4V特征,即數据量大、数据类型繁多、处理速度快和价值密度低。其中数据量大和数据类型繁多是大数据的表现形式,而处理速度快和价值密度低是大数据处理过程和结果的体现。大数据通常是由网站、传感器、系统等设备自动生成,故具有真实性特征。大数据类型多样,既包括结构化数据、非结构化数据和半结构化数据,又包括系统生成的数据、传感器产生的数据和社交媒体数据等;从数据格式上看,包括文本数据、图片数据、数值数据、音频视频数据等类型。

基于以上大数据的定义和特征,对大数据质量进行分析。借鉴Juran提出的质量就是“适合于使用”这一定义,那么大数据质量即是大数据中适合于进行数据分析、处理、预测等使用过程并满足用户需求的特征。大数据处理流程主要包括数据收集、数据预处理、数据存储、数据分析与挖掘、数据展示(可视化过程)、大数据应用等环节,数据质量贯穿于整个大数据流程,故可将大数据质量分为原始质量、过程质量和结果质量。大数据原始质量是指数据采集过程中采集到的原始大数据的质量,包括数据完整性、一致性、准确性、时效性等方面;大数据过程质量指经过数据预处理、数据存储等环节后的大数据质量,它为大数据分析与挖掘提供准备,其质量高低直接关系到大数据分析结果的价值;大数据结果质量指经过数据分析与挖掘、数据展示后产生的最终结果的质量,包括分析结果的价值性、直观性等,与用户的需求与感知有关。大数据应用是直接检验大数据结果质量的重要环节。

12大数据质量维度

根据大数据质量的内涵及大数据特征可知,大数据质量维度包括以下几个方面:

121数据真实性

大数据是由系统、传感器、网站等设备自动生成的,它真实记录了数据对象的变化状态及其运行方式,体现了原始大数据的真实性质量。根据Yuri Demchenko等人提出的大数据5V特征,真实性特征主要包括数据的可信性、真伪性、来源和信誉、有效性和可审计性等特征。值得注意的是,大数据主要存在于虚拟网络环境下,一些恶意攻击性的“数据污染”会影响组织决策,需要采取必要的措施保证其真实性和客观性,它是实现大数据价值挖掘与趋势预测的前提。

122數据完整性

主要指大数据采集的完整性,包括数据采集时间段的完整性、数据属性值的完备性、数据值的无缺失等方面。大数据的一个主要特征就是通过大量数据甚至是海量数据来全面、完整地刻画事物,并通过海量数据分析获取事物的本质与规律,故数据完整性也是实现大数据价值的重要质量属性。

123数据一致性

主要包括同构/异构来源数据的一致性、数据格式的一致性、数据编码的一致性等方面[7],可在预处理阶段通过数据不一致检测技术进行过滤,以确保数据的一致性。数据一致性是实现数据准确性的前提,也是保障大数据分析结果质量的重要属性。

124数据准确性

既包括采集到的原始大数据的准确性,也包括经过预处理的过程大数据的准确性,还包括大数据分析结果的准确性,即在整个大数据采集、处理、分析、显示等过程中均涉及数据的准确性特征。数据准确性是决定大数据分析结果价值大小的关键属性。不同的大数据应用对数据准确度的要求也不尽相同,这取决于应用目标与决策需求。

125数据时效性

大数据是信息的一种,同样具有生命周期性。时效性指大数据在时间方面的质量,即数据时效性越高,则数据分析结果的准确性越高。大数据的时效性主要体现在原始大数据和结果大数据两个方面。原始大数据的时效性,指超出一定时间范围的原始大数据在分析与预测结果上会出现数据“过期”问题,即预测结果与事实不符。而且,由于大数据多是由机器、系统、网站等自动采集或存储的,其产生速度快、流通快,时间上呈现连续性特征,使原始大数据具有更强的时效性。因此时间越近的原始大数据,其分析与预测的结果越接近事实。结果大数据的时效性指大数据的分析预测结果只在一定时间范围内有效,故需要持续地数据更新与预测,以保证预测结果数据的价值性。

126数据安全性

包括数据来源的安全性、数据存取的安全性、权限管理、访问控制等方面,数据安全性是实现大数据分析处理与预测的基本要求,对大数据的可用性、真实性和机密性具有保障作用。

127数据可用性

包括两个方面:一是经过采集、预处理并进行存储的过程数据可用于大数据分析、预测而获取有价值信息的属性;二是经过一系列大数据处理而得到的结果数据可实现大数据应用的属性。即过程数据和结果数据的可用性。过程数据的可用性指可用于进一步的数据分析与处理,实现大数据价值;结果数据的可用性是可将分析结果用于管理决策、趋势预测等,是大数据分析结果的价值转化过程。

128数据价值性

即经过大数据分析处理后的最终结果数据的价值性,这一价值性主要体现在大数据应用上,接受应用实践的检验。通过对海量数据的分析处理,大数据预测结果相比于传统的抽样调查结果,其准确性和可信性要高,同样其数据价值也更高。大数据分析与预测结果的价值由企业应用实践和用户感知来衡量。

129易于理解性

指大数据处理结果的展现是否便于用户理解与使用,主要体现在大数据的结果质量方面,与用户感知相关。

2基于处理流程的大数据质量影响分析

大数据处理流程主要包括数据收集、数据预处理、数据存储、数据处理与分析、数据展示/数据可视化、数据应用等环节,其中数据质量贯穿于整个大数据流程,每一个数据处理环节都会对大数据质量产生影响作用。通常,一个好的大数据产品要有海量的数据规模、快速的数据处理、精确的数据分析与预测、优秀的可视化图表以及简练易懂的结果解释,本节将基于以上环节分别分析不同阶段对大数据质量的影响及其关键影响因素。

21数据收集环节

数据收集是获取原始大数据集合的过程。大数据通常由不同数据源产生,且由机器自动生成,然后通过网络传输到指定的位置,这是一种大数据生成即收集的方式;或者由企业或组织根据自身需求,有针对性地从各种来源收集所需数据,如用户的各种数据等。总之,数据收集需从不同数据源实时地或及时地收集各种类型数据,并发送给存储系统或数据中间件系统进行后续处理。数据收集可分为设备数据收集和Web数据爬取两种,由各种数据收集软件和网络爬虫完成。数据收集环节对大数据质量的真实性、完整性、一致性、准确性、时效性、安全性等维度均产生影响作用。

211数据源

在数据收集过程中,数据源会影响大数据质量的真实性、完整性、一致性、准确性和安全性。大数据的数据源主要指各种网站、系统、传感器设备等,这些数据源的安全运行、防止恶意攻击与篡改是保障大数据真实性、准确性和安全性质量的重要条件。同时,数据源运行的稳定性、无间断性是保障大数据完整性的重要条件。不同数据源之间的统一编码、相互协调是保障同构或异构大数据的一致性质量的重要前提,它要求数据源之间的同步与协作。故在数据收集环节,数据源是影响大数据真实性、完整性、一致性、准确性和安全性质量的重要因素之一。

212数据收集方式

数据的实时收集方式可有效保障大数据的时效性质量,确保大数据分析与预测结果的时效性和价值性。设备收集多为实时的数据收集,且以流式数据进行采集、处理与分析,从而确保大数据的时效性质量。对于Web数据,多采用网络爬虫方式进行收集,这需要对爬虫软件进行时间设置以保障收集到的数据时效性质量。故数据收集方式是影响大数据时效性质量的重要因素之一。

213数据收集技术

数据收集技术在这一阶段是非常重要的技术因素,收集技术的好坏直接决定了数据收集的速度和质量。通常数据收集分为两种——设备数据收集和互联网数据爬取,常用的收集软件有Splunk、Sqoop、Flume、Logstash、Kettle以及各种网络爬虫,如Heritrix、Nutch等[8],这些软件是大数据发展与应用的重要一环,也是英特尔、Facebook、谷歌等公司可以获取大量数据的直接原因。故数据收集技术是影响大数据原始质量的重要因素之一。

22數据预处理与存储环节

221数据预处理

大数据采集过程中通常有一个或多个数据源,这些数据源包括同构或异构的数据库、文件系统、服务接口等,易受到噪声数据、数据值缺失、数据冲突等影响,因此需首先对收集到的大数据集合进行预处理,以保证大数据分析与预测结果的准确性与价值性。大数据的预处理环节主要包括数据清理、数据集成、数据归约与数据转换等内容,可以大大提高大数据的总体质量,是大数据过程质量的体现。

数据清理技术包括对数据的不一致检测、噪声数据的识别、数据过滤与修正等方面,有利于提高大数据的一致性、准确性、真实性和可用性等方面的质量;数据集成则是将多个数据源的数据进行集成,从而形成集中、统一的数据库、数据立方体等,这一过程有利于提高大数据的完整性、一致性、安全性和可用性等方面质量;数据归约是在不损害分析结果准确性的前提下降低数据集规模,使之简化,包括维归约、数据归约、数据抽样等技术,这一过程有利于提高大数据的价值密度,即提高大数据存储的价值性。数据转换处理包括基于规则或元数据的转换、基于模型与学习的转换等技术,可通过转换实现数据统一,这一过程有利于提高大数据的一致性和可用性。总之,数据预处理环节有利于提高大数据的一致性、准确性、真实性、可用性、完整性、安全性和价值性等方面质量,而大数据预处理中的相关技术是影响大数据过程质量的关键因素。

222数据存储

在大数据存储中,分布式存储与访问是其关键技术,它具有高效、经济、容错性好等特点。分布式存储技术与数据存储介质的类型和数据的组织管理形式直接相关。数据存储介质的类型主要有内存、磁盘、磁带等,数据组织管理形式主要包括以行、列、键值、关系等进行组织,不同的存储介质和组织管理形式对应于不同的大数据特征和应用。

分布式文件系统,它是大数据领域最基础、最核心的功能组件之一,其关键在于实现分布式存储的高性能、高扩展和高可用性。文档存储,支持对结构化数据的访问,支持嵌套结构、二级索引,以实现数据的高效查询。列式存储可减少数据存取量、提高数据处理效率。键值存储可有效减少读写磁盘的次数,但不提供事务处理机制。图形数据库可实现事物之间相关关系的存储,并使用图模型来映射这些网络关系,实现对真实世界中各种对象的建模存储。内存存储是将数据库的工作版本放在内存中,其设计目标是提高数据库的效率和存储空间的利用率。总之,不同的数据存储技术具有不同的特征与优势,它们对于提高大数据的时效性、安全性、可用性和准确性等质量维度具有重要影响。

23数据处理与分析环节

231数据处理

大数据的分布式处理技术与存储形式、业务数据类型等相关,针对大数据处理的主要计算模型有MapReduce分布式计算框架、分布式内存计算系统、分布式流计算系统等。MapReduce是一个批处理的分布式计算框架,可对海量数据进行并行分析与处理,它适合对各种结构化、非结构化数据的处理。分布式内存计算系统可有效减少数据读写和移动的开销,提高大数据处理性能。分布式流计算系统则是对数据流进行实时处理,以保障大数据的时效性和价值性。总之,无论哪种大数据分布式处理与计算系统,都有利于提高大数据的价值性、可用性、时效性和准确性。大数据的类型和存储形式决定了其所采用的数据处理系统,而数据处理系统的性能与优劣直接影响大数据质量的价值性、可用性、时效性和准确性。因此在进行大数据处理时,要根据大数据类型选择合适的存储形式和数据处理系统,以实现大数据质量的最优化。

232数据分析

大数据分析技术主要包括已有数据的分布式统计分析技术和未知数据的分布式挖掘、深度学习技术。分布式统计分析可由数据处理技术完成,分布式挖掘和深度学习技术则在大数据分析阶段完成,包括聚类与分类、关联分析、深度学习等,可挖掘大数据集合中的数据关联性,形成对事物的描述模式或属性规则,可通过构建机器学习模型和海量训练数据提升数据分析与预测的准确性。数据分析是大数据处理与应用的关键环节,它决定了大数据集合的价值性和可用性,以及分析预测结果的准确性。在数据分析环节,应根据大数据应用情境与决策需求,选择合适的数据分析技术,提高大数据分析结果的可用性、价值性和准确性质量。

24数据可视化与应用环节

数据可视化是指将大数据分析与预测结果以计算机图形或图像的直观方式显示给用户的过程,并可与用户进行交互式处理。数据可视化技术有利于发现大量金融、通信、商业等业务数据中隐含的规律性信息,以支持管理决策。数据可视化环节可大大提高大数据分析结果的直观性,便于用户理解与使用,故数据可视化是影响大数据可用性和易于理解性质量的关键因素。

大数据应用是指将经过分析处理后挖掘得到的大数据结果应用于管理决策、战略规划、市场营销等的过程,它是對大数据分析结果的检验与验证,大数据应用过程直接体现了大数据分析处理结果的价值性和可用性。大数据应用对大数据的分析处理具有引导作用。在大数据收集、处理等一系列操作之前,通过对应用情境的充分调研、对管理决策需求信息的深入分析,可明确大数据处理与分析的目标,从而为大数据收集、存储、处理、分析等过程提供明确的方向,并保障大数据分析结果的可用性、价值性和用户需求的满足。

3大数据流程的质量影响模型

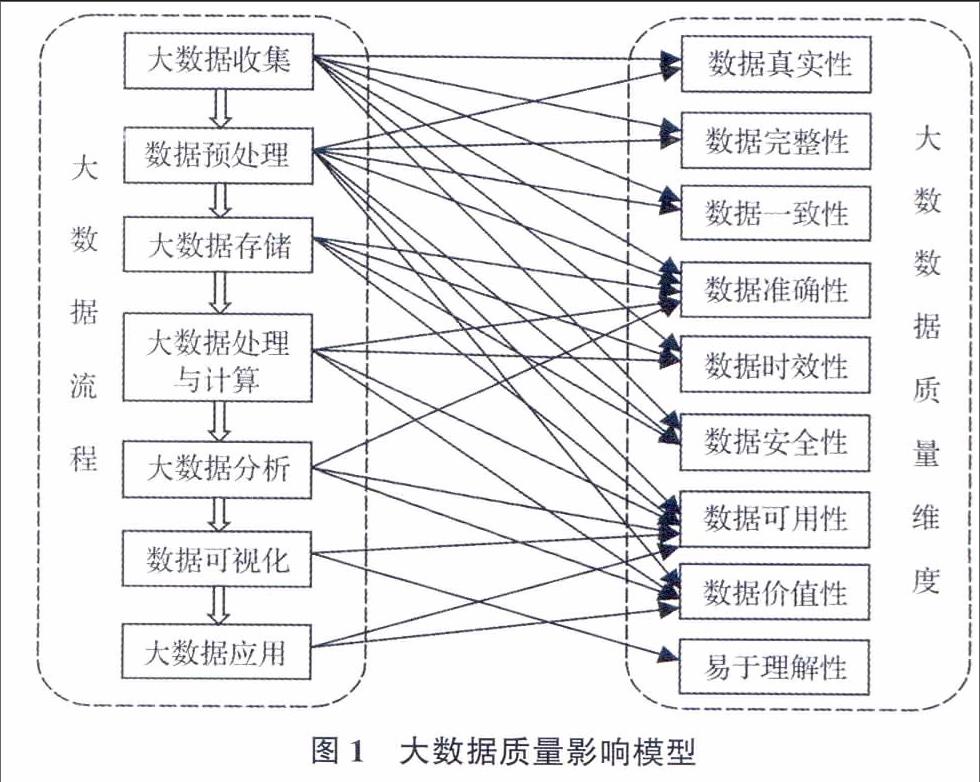

由以上分析可知,大数据质量与其整个数据流程有关,影响大数据质量的重要因素包括数据源、数据收集方式与技术、预处理技术、存储系统与技术、数据处理系统、数据分析技术、数据可视化技术等,技术性是大数据质量影响因素的主要特征。它们的影响关系如图1所示。

由图1可知,大数据流程中的前期处理环节对大数据质量的影响较大,尤其是大数据收集和预处理阶段,影响最大。而在大数据质量的各维度中,数据可用性、数据准确性和数据价值性受大数据处理流程的影响较大,这说明通过对大数据流程的管理与控制,可有效保障大数据的可用性、准确性和价值性。

最后,根据以上分析,提出保障大数据质量的建议与措施,主要包括:

1)大数据采集中的数据保护和数据源甄别。在数据采集过程中,尤其是对他人数据的采集中,企业应注意不收集、统计敏感信息以保护用户隐私;同时,需注意对数据来源进行甄别和验证,保证数据的真实性和有效性。

2)大数据存储中的技术保障手段。可参考传统的信息技术手段,以保证数据的可用性、完整性和私密性。如通过冗余设置以保障数据的可用性,采用校验技术保障数据的完整性,使用访问控制技术、安全审计功能保障数据安全性等。

3)大数据处理分析中的质量保障措施。可通过对大数据读写操作的权限设置实现安全性管理,通过对不同分析策略产生的结果进行相互验证来保障分析结果的准确性和可用性,通过不断优化分析策略以提高大数据处理的性能和效率。

4)大数据可视化中的结果安全性保护。可通过设置访问控制、认证授权等策略对分析结果进行保护。

5)大数据处理流程的全局管理。大数据处理流程经过了数据采集、预处理、存储、处理与分析、可视化等一系列环节,在这些环节中要注重全局管理和不同环节之间的协调与连贯。如数据存储形式的选择要考虑采集到的大数据类型、后期分析处理可用的数据处理系统,以及分析结果的准确性和可用性,以实现大数据质量的最优化。

总之,在大数据浪潮下企业是否能把握机遇,数据质量和数据治理正成为重要的工具和手段。大数据商业价值在于不断开发与分析,这一过程中离不开数据质量管理与治理的持续与循环,以保障大数据价值的挖掘。

参考文献

[1]宗威,吴锋.大数据时代下数据质量的挑战[J].西安交通大学学报:社会科学版,2013,(5):38-43.

[2]胡雄伟,张宝林,李抵飞,等.大数据研究与应用综述(上)[J].标准科学,2013,(9):29-34.

[3]Vijay Khatri,Carol V.Brown communications of the ACM[J].January,2010,53(1):148-153.

[4]Sharma S,Tim U S,Wong J,et al.A brief review on leading big data models[J].Data Science Journal,2014,13(0):138-157.

[5]王宇德.企业大数据治理研究[J].互联网天地,2014,(1):20-24.

[6]马晓亭.基于用户服务价值的图书馆大数据价值分析与服务质量保证研究[J].图书馆,2014,(5):95-98.

[7]桑尼尔·索雷斯.大数据治理[M].北京:清华大学出版社,2014.

[8]中国电子技术标准化研究院.大数据标准化白皮书V20[EB/OL].http:∥www.cesi.ac.cn/cesi/guanwanglanmu/biaozhunhuayanjiu/2015/1224/12264.html,2015-12-29.

(本文责任编辑:郭沫含)

- 抓好“两学一做”学习教育扎实推进铁路企业党建工作

- 核电企业基层党员如何践行“不信谣不传谣”

- 对加强国有企业离退休党员教育和管理的思考

- 加强企业财务内部控制的途径探析

- 浅议机关办公室事务工作的精细化管理

- 论人力资源成本的有效管理

- 我国旅游业转型升级路径探析

- 浅析房贷利息抵扣个人所得税

- 于连的形象及其启示

- 《袁氏世范》的家庭教化与治家之道

- 近代早期先进人士的复兴中国梦之路

- 被风沙掩埋的辉煌

- 读《论语》悟孝道重践行

- 政治学视域内儒学发展的转向与历史脉络

- 孔子和谐思想对构建和谐社会的启示

- 试论孔子教育思想的特点

- 浅谈高职语文文学教育视野中的审美观

- 工程教育背景下专业认识实习形式探索

- 高等学校辅导员心理健康教育能力提升路径探索

- 移动互联技术对高校人才培养的影响初探

- 高校官方微博思想政治教育功能发挥的路径探索

- 网络强国战略与高校思想政治教育的创新

- 马克思主义教育公平观与我国教育公平

- 浅谈如何将绘本有效融入小学英语课堂教学中

- 时尚健身操引入高校教学的必要性及对策

- semi-mute

- semimystic

- semimystically

- semimysticalness

- semimysticalnesses

- semimythic

- semimythically

- seminaked

- seminar

- seminarcotic

- seminarial

- seminaries

- seminarrative

- seminars

- seminary

- seminasalities

- seminasality

- seminationalism

- seminationalisms

- seminationalistic

- seminationalized

- seminervous

- seminervously

- seminervousness

- seminervousnesses

- 以茨藿为食

- 以荣增愧

- 以药饵治病

- 以荷析薪

- 以莛叩钟

- 以莛扣钟

- 以莛撞钟

- 以菜肴下饭

- 以菲薄祭品悼念亡友

- 以蒙昧自隐,修养正道

- 以蒲为脯

- 以蓍草卜问祸福

- 以蔬菜为食物

- 以虎纹为饰的幄幕

- 以虚伪诡诈手段避税

- 以虚假的礼仪笼络人

- 以虚假的荣誉骗人

- 以虚名炫耀于世

- 以虚声而登高位

- 以虚带实

- 以蚓投鱼

- 以蛋碰石

- 以蜜糖浸渍的果品

- 以蜡涂物

- 以蠡挹海