端木春江 代晓东

摘? 要: 为了提高单幅图像超分辨方法的性能,提出了新的基于投影矩阵的超分辨率方法。通过引入字典的互不一致性增强求解出的字典的表达能力;对分类后的低分辨率图像特征和相应的高分辨率图像特征的关系学习多个投影矩阵;并通过设置权重矩阵,增强邻近字典原子对当前图像块的表达能力,弱化较远原子的表达能力。在对投影矩阵进行正则化约束的前提下,利用字典原子和特征块之间的相关性以及特征块与其聚类中心的欧式距离关系,重构出拥有更加详细信息的高分辨率图像特征。实验结果显示,该方法的重构结果优于传统方法的重构结果。

关键词: 图像处理; 图像超分辨率; 字典学习; 投影矩阵; 互不一致性

中图分类号:TP37? ? ? ? ? 文獻标识码:A? ? 文章编号:1006-8228(2020)02-01-05

Single image super-resolution method based on projection matrices

Duanmu Chunjiang, Dai Xiaodong

(School of Mathematics and Computer Science, Zhejiang Normal University, Jinhua, Zhejiang 321004, China)

Abstract: In order to boost the performance of the single image super-resolution methods, a new super-resolution method based on projection matrices is proposed. It introduces the item of the mutual incoherence to obtain the atoms which have more representation abilities, and then it learns multiple projection matrices according to the relationship of classified image features between low-resolution images and the corresponding high-resolution images after classification, and a weight matrix is set to increase the representation abilities of the close neighboring atoms and decrease the representation abilities of the atoms which are relatively far away. Under the constraints of the projection matrices with regularization term, the coherence properties between the atoms and feature blocks, and the Euclidean distance relationship of the feature blocks and the classification centers are utilized to reconstruct high-resolution image features with better detailed information. The experimental results show that the reconstruction result of the proposed method is better than that of the traditional method.

Key words: image processing; image super-resolution; dictionary learning; projection matrices; mutual incoherence

0 引言

图像超分辨率研究是计算机视觉中的一个重要领域,其目的是将现实生活中因各种条件限制产生的低分辨率图像(LR)提高其对应的分辨率,得到高分辨率图像(HR),尽可能地减少视觉上的失真,并提高其清晰度。

图像超分辨率算法主要分为基于插值、基于重构和基于学习三大类。前两类方法会产生带有模糊的边缘或锯齿效果的图像。目前基于学习的方法是研究的热点。Yang[1]假设LR块和HR块具有相同的稀疏系数,HR块可以通过被学习的字典原子的稀疏线性组合来重构。在Yang的基础上,Zeyde[2]利用主成分分析来减少特征块的维度,使用K-SVD和OMP算法进一步求稀疏系数。Timofte[3]提出的锚定邻域回归(ANR)方法中利用LR和HR字典原子的相邻字典原子得到LR和HR特征块的投影矩阵。之后Timofte提出A+方法[4],将训练投影矩阵改为利用LR训练块而不是LR和HR字典对,重构的图像质量又得到提升。Jiang[5-6]提出了局部正则化锚定邻域回归(LANR)的方法,它根据每个相邻字典原子与输入LR块的相关性为每个相邻字典原子分配不同的权重。Zhang[7]提出学习无参投影矩阵(ALNR)和基于学习的统计先验信息来表示字典原子的方法,达到了好的效果。

在基于内部样本方法[11]的概念下,Dong[12]提出了一个基于深度卷积神经网络的超分辨率模型(SRCNN),以端到端的方式直接学习LR图像与其对应的HR图像之间的映射关系。

本文的创新点:①在训练阶段使用MI-KSVD[8]算法来训练LR和HR字典,对LR和HR特征之间的投影矩阵做了[l2]范数正则化约束,使该投影矩阵能较好的预测出LR图像缺失的高频信息。②增加了字典原子之间的互不相关性,提高了利用字典原子表示图像块的精度,并且字典原子与其对应的特征块集合的距离度量我们采用每个特征块与其聚类中心的欧氏距离。③结合所提出的新的目标函数,最终得到优化的从低分辨率到高分辨率的投影矩阵。

1 基于A+方法的回顾

1.1 字典训练阶段

设:[X=[xl1,xl2,...,xlN]∈Rdl×N]

[Y=[yh1, yh2, ..., yhN]∈Rdh×N]

X,Y分别表示从训练集中提取出的低、高分辨率訓练矩阵。其中,每一列对应一个低、高分辨率图像块的特征。

根据Zeyde[2]提出的利用K-SVD方法和OMP方法训练得到低分辨率字典和高分辨率字典矩阵:[Dl=[dl1,dl2,...,dlk,...,dlM]∈Rdl×M]和[Dh=[dh1,dh2,...,dhM]∈Rdh×M],其中每列表示一个低、高分辨率字典原子。

1.2 学习投影矩阵

对每一个低分辨率字典原子[dlk],利用欧式距离找到K个距离最近的低分辨率特征块并构成相邻矩阵[Nlk=[xl1(k),...,xlK(k)]],对应的高分辨率特征块相邻矩阵表示为[Nhk=[yh1(k),...,yhK(k)]]。然后,字典原子[dlk]的投影矩阵可以由⑴式得到:

[Fk=Nhk((Nlk)TNlk+λI)-1(Nlk)T] ⑴

其中,[I]表示单位矩阵。

1.3 重构高分辨率图像

低分辨率字典原子[dlk]与低分辨率特征矩阵[X=[xl1,xl2,...,xlN]∈Rdl×N]中的任意一个特征块[xlj]的距离度量我们采用相关性来表示,用式⑵表示。

[corr(dlk,xlj)=(xlj)Tdlk? (1≤j≤N)] ⑵

则[dlk]的N个LR特征块相关性矩阵表示如下:

[Ci=[corr(dl1,xli),...,corr(dlM,xli)]] ⑶

对于低分辨率图像块[xli],在低分辨率字典[Dl]上找到和其相关性最大的字典原子,然后根据在训练阶段存储的这个原子所对应的投影矩阵,就可以得到高分辨率图像块,即[yhi=Fkxli]。

2 所提出的方法

2.1 训练阶段字典原子间互不相关性的引入

训练阶段中学习到的字典可能会过度拟合某些LR和HR图像块,为了平衡不同信息的图像块对训练字典的影响,引入字典原子间的互不相关性到训练字典的目标函数中。求解稀疏字典的最小化目标函数可用式⑷表示。

[X-Dlβ22? s.t. ?k,dlk2=1 and ?i,βi0≤K]? ?⑷

其中,[Dl]为待求的低分辨率字典,[β=[β1,β2,...,βN]∈RK×N]为待求的稀疏系数矩阵。

Candes[9]实验结果表明:当字典原子之间的互不相关性足够大时,更容易恢复稀疏性。因此,我们把字典间的互不相关性引入到目标函数中,并在目标函数中平衡重构误差和字典原子间的互不相关性,所提出的目标函数如下式⑸所示。

[⑸]

我们使用Bo[8]提出的MI-KSVD算法来求解目标函数式⑸,得到的低分辨率字典能在很大程度上提高字典原子之间的互不相关性。

2.2 求解所提出的投影矩阵阶段

从训练图像集中提取的低、高分辨率特征块,表示为[{xli,yhi}Mi=1(M>>N)],其中[xli]表示第[i]个低分辨率特征块,[yhi]表示对应的第[i]个高分辨率特征块,[M]表示提取的图像特征块的数目,[N]表示特征块的维数。对于低分辨率字典中的每一个原子[dlk],我们采用相关性在低分辨率块特征集合[xliMi=1]中找到和[dlk]最近的[L]个低分辨率特征块,这些特征块构成了矩阵[Nlk=xl1(k),xl2(k),…,xlL(k)]。对应的高分辨率特征集合中的[L]个特征块构成了矩阵[Nhk=xh1(k),xh2(k),…,xhL(k)]。由于[dlk]与[Nlk]的聚类中心[xlc(k)]具有较高的相似性,因此[Nlk]中的每个特征块与[Nlk]的聚类中心[xlc(k)]的距离度量我们利用欧式距离由如下公式⑹得出:

[si=(xli(k)-xlc(k))(xli(k)-xlc(k))T] ? ⑹

这里[xli(k)]是LR训练集[Nlk]的任意一个特征块,[si]表示第[i]个特征块[xli]与其聚类中心[xlc(k)]的欧氏距离。因此利用[si]计算权值矩阵[Wk]由公式⑺给出。

[Wk=[es1,es2,...,esL]] ⑺

其中,[Wk]表示从[Nlk]到[Nhk]更详细的投影关系。最后,投影矩阵[Pk]由如式⑻所定义的目标函数求解得出。

[minPkNhk-PkNlkWk22+λPk22] ⑻

[·2]表示添加在投影矩阵[Pk]上的[l2]范数约束。上面线性最小二乘问题有如下近似形式的解:

[Pk=NhkMkT(ΜkMkT+λI)-1] ⑼

其中,[Mk=NlkWk]。这些投影矩阵[Pk]可以离线进行计算,然后存储起来,供在线放大时使用。

2.3 在线重构阶段

对于一幅低分辨率的图像[Il],首先利用双三次插值方法将它放大到与高分辨率图像相同的尺寸。然后进一步将被插值放大后的图像[Ilb]进行分块和特征提取。其分的任意块和从分块中提取的特征块可以分别被表示为:[pli]和[fli]([1≤i≤N])。对于每一个低分辨率特征块[fli],利用相关性度量在字典[Dl]中找到与其关联最紧密的L个字典原子[dlk(j)],[1≤j≤L],在L个字典原子中找到[fliTdm]值最大的字典原子[dm],其中[dm]表示字典矩阵[Dl]中的第[m]列。为了恢复更多高频信息,并遵守在训练阶段得到的自适应回归的结果,结合[dm]对应的投影矩阵就可以利用如下的公式⑽得到高分辨率的特征块[fhi]。

[fhi=Pkflicl] ⑽

其中,[cl=exp(dmTfli)]([expx=ex])。最后将被插值放大后得到的块[pli]加上⑽式求出的高分辨率特征块,就可以得到重构的图像块,即

[phi=pli+fhi] ⑾

通过组合所有得到的高分辨率图像块,并对相邻图像块之间的重叠区域进行平均来重建高分辨率图像。

3 实验结果和分析

3.1 实验设置

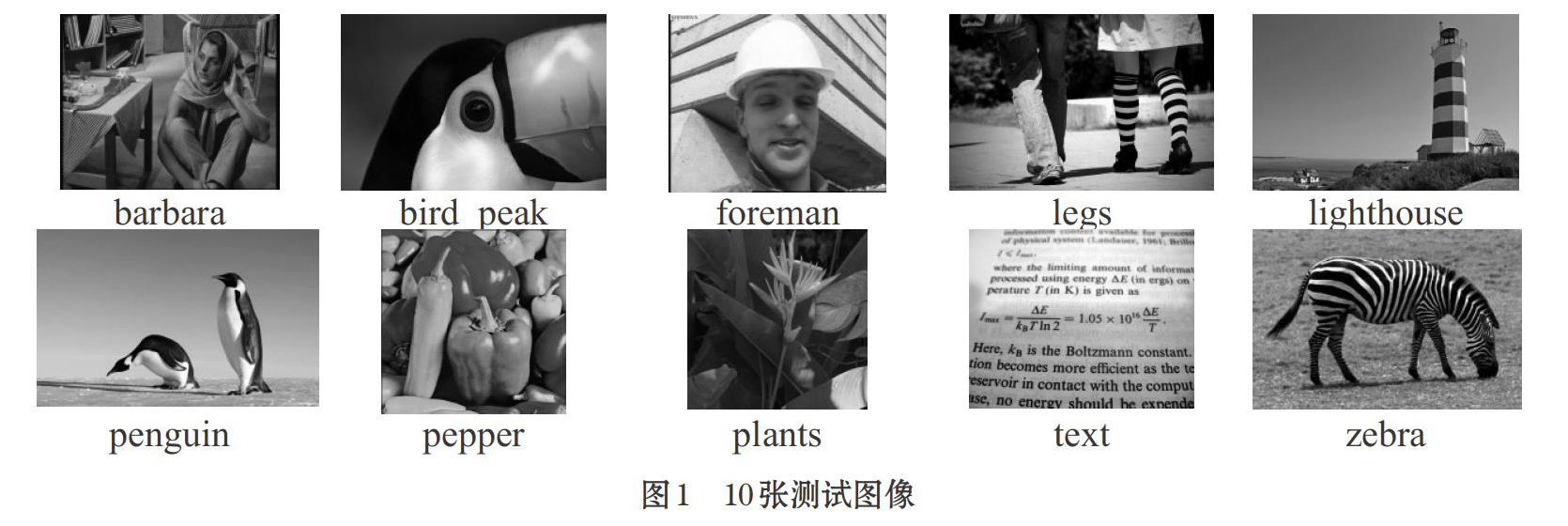

为了实验结果的公平性,采用与Yang[1]、Timofte[3-4]、Zhang[10]方法相同的91张图片作为训练图像。利用图1所显示的10张图像作为测试图像集来证明我们提出的方法有较好的鲁棒性。

实验中,一些参数的初始值保持与A+方法一致。字典大小K=1024,字典训练循环迭代次数N=50。相邻块的个数L=2048,低分辨率和高分辨率的训练样本数M=5000000。

同时,采用4倍放大倍数來放大低分辨率图像,使用峰值信噪比(PSNR)来评判我们重构出的高分辨率图像的质量。所有的实验都是运行在Matlab 2016b软件环境上,计算机的CPU是Intel Core i7,内存8GB。

3.2 实验结果

我们的实验结果主要和Yang[1]、Zeyde[2]、ANR[3]、SRCNN[12]、A+[4]、ALNR[7]等方法进行比较。表1中列出的是所提出的方法和其他方法在放大倍数(×4)的10张测试集上PSNR的比较结果。可以看出,对于大多数的测试图片,我们所提出的方法实现了最好的结果。其峰值信噪比(PSNR)的平均值要比ALNR[7]方法多0.02dB,比A+[4]方法多0.09dB,比SRCNN[12]方法多了0.43dB。由此,在一定程度上说明了利用提出的投影矩阵映射LR特征到HR特征的方法在增强HR图像细节上起到了一定的作用。

在图2,图3,图4中我们展示了来自10张测试图像中的pepper、foreman、text在不同方法下的得到的高分辨率图像。从这些图中可以看出Yang[1]的方法模糊了图像的纹理部分,图像质量较差。Zeyde[2]和ANR[3]方法的实验结果在一定程度上也模糊了图像的细节,SRCNN[12]方法得到的foreman图像结果中出现了锯齿失真,A+[4]、ALNR[7]方法重构图像的质量较好。同时,相对ALNR[7]方法来看,我们所提出的方法展现了更好的图像纹理信息和细节边缘信息。

4 总结和展望

本文提出了一种新的图像超分辨率处理方法,在目标函数中引入互不一致性来提高字典原子表示图像块的能力。通过学习新的低分辨率块和高分辨率块之间的投影关系,进而得到质量更好的超分辨率重构图像。对比于其他超分辨率方法,所提出的方法在恢复高分辨率细节上有所提高,并且由于在获取训练字典和投影矩阵的步骤可以离线进行,因此节省了更多的运算时间。在未来的工作中,考虑把关注点放在优化聚类中心上,进而能更好地提高图像超分辨率的质量。

参考文献(References):

[1] Yang J C,John W,Huang T S. Image super-resolution via sparse representation[J].IEEE Transactions on Image Processing,2010.19(11):2861-2873

[2] Zeyde R,EladM,Protter M.On single image scale-up using sparse-representations[C].Proceedings of International Conference on Curves and Surfaces. Springer Berlin Heidelberg,2010:711-730

[3] TimofteR,Smet V D,GoolLV. Anchored neighborhood regression for fast example-based super resolution.Proceedings of International Conference on Computer Vision,2013:1920-1927

[4] TimofteR,Smet V D,GoolLV.A+:Adjusted anchored neighborhood regression for fast super-resolution.Asian Conference on Computer Vision,2014,9006:111-126

[5] Jiang J J,Fu J C,Lu T,et al. Locally regularized anchored neighborhood regression for fast super-resolution [C].IEEE International Conference on Multimedia & Expo,2015:1-6

[6] Jiang J J,Ma X,Chen C,et al. Single image super-resolution via locally regularized anchored neighborhood regression and nonlocal means[J].IEEE Transactions on Multimedia,2016.19(1):15–26

[7] Zhang Y L,Zhang Y B,Zhang J,et al. Adaptive local nonparametric regression for fast single image super-resolution [C].Proceedings of IEEE International Conference on Visual Communications and Image Processing,2015:13-16

[8] Bo L F,Ren X F,Fox D. Multipath sparse coding using hierarchical matching pursuit [C].IEEE Conference on Computer Vision and Pattern Recognition,2013.9(4):660-667

[9] Candes E,Romberg J. Sparsity and Incoherence in Compressive Sampling[J].Inverse problems,2007.23(3):969-985(17).

[10] Zhang Y L,Gu K Y,Zhang Y B,et al. Image super-resolution based on dictionary learning and anchored neighborhood regression with mutual incoherence[C]. IEEE International Conference on Image Processing,2015.59:1-595

[11] Glasner D,Bagon S,Irani M.,Super-resolution from a single image[C],2009 IEEE 12th International Conference on Computer Vision,2009:349–356

[12] Dong C,Loy C C,He K,Image Super-Resolution Using Deep Convolutional Networks,2104 European Conference on Computer Vision,2014:184–199

- 现代大棚蔬菜种植技术与病虫害防治分析

- 大豆高产栽培技术

- 乌拉特中旗向日葵扩行降密提质增效栽培技术应用与推广

- 农网工程管理问题及意义与策略探讨

- 玉米膜侧种植技术研究

- 浅谈在设施葡萄中之中控释肥的应用

- 辣椒种植与病虫害防治技术

- 浅谈圆锥滚子轴承滚道过、欠磨对寿命的影响及纠正措施

- 马铃薯全膜种植高产栽培技术

- 颗粒饲料的加工工艺及自动化控制技术

- 朝阳市玉米高产栽培技术

- 浅谈灵武市畜禽粪污资源化利用现状

- 玉米抗倒伏技术

- 玉米大喇叭口期主要管理措施

- 大蒜减肥增效高产栽培技术

- 制造执行系统及其相关技术分析

- 日光温室蔬菜水肥药一体化技术

- 规范综合技术应用,提升棉花品质效益

- 探讨高原夏菜优化栽培模式

- 有机物料腐熟剂及其使用技术

- 玉米田间管理技术

- 探析森林病虫害无公害防治策略

- 探析竹山县发展竹产业建议与对策

- 青杨栽培技术及病虫害防治

- 加快农业产业化促进农业经济发展实践探索

- under the counter

- under the influence

- under the name of sth

- under the weather

- under the weight of

- underthief

- underthiefs

- underthieves

- undertide

- undertie

- undertied

- underties

- undertitle

- undertitles

- undertone

- undertones

- undertook

- undertow

- undertows

- undertrade

- undertraded

- undertrader

- undertraders

- undertrades

- undertrading

- 坚韧的样子

- 坚韧的肌腱

- 坚韧的草

- 坚韧而质朴

- 坚额健舌

- 坚黑如铁的石壁

- 坚龙

- 坛

- 坛中捉鳖——稳捉稳拿

- 坛主

- 坛位

- 坛卷

- 坛友

- 坛口好封,人嘴难捂

- 坛口好扎,人口难封

- 坛口封得住,人口封不住

- 坛周围的矮墙

- 坛场

- 坛场坛兆

- 坛坎

- 坛坛罐罐

- 坛坫

- 坛基

- 坛基的美称

- 坛堂