于德鑫 王文强 曹晓杰

摘 要:为了改善时空上下文(STC)跟踪算法不能自动检测跟踪目标的缺点,提出一种帧间差分与STC相结合的自动检测跟踪算法。该算法将帧间差分法检测到的含有前景目标轮廓及位置的矩形框传送给STC跟踪器,可达到自动检测与跟踪目标的目的,并且提高了跟踪精确度,降低了手动选定目标框的繁琐程度。通过实验对改进前后的STC算法进行分析比较,结果表明,改进后的算法具有更高的跟踪精度,可实现对目标的稳定跟踪。

关键词:时空上下文;目标跟踪;帧间差分;自动检测

DOI:10. 11907/rjdk. 181770

中图分类号:TP312文献标识码:A文章编号:1672-7800(2019)001-0091-04

Abstract:An automatic detection and tracking algorithm based on frame difference and STC was put forward to improve the spatio-temporal context(STC) tracking algorithms failure to detect and track the target automatically. This algorithm transmits the rectangular box detected by the frame difference algorithm and contains the outline and position of the foreground object to the STC tracker. After the analysis and the comparison of the STC algorithm before and after improvement in the experiment,we conclude that the improved algorithm enjoys higher accuracy and achieves stable tracking of the target.

0 引言

目标跟踪是计算机视觉领域非常热门的研究课题[1-3],在智能机器人、智能视频监控、工厂自动化、人机界面、车辆跟踪、视频压缩等领域应用广泛[4-5]。近年来,研究者们提出了大量目标跟踪算法,如TLD[6]、ASMS[7]、KCF[8]、MEEM[9]、HCF[10]、STRUCK[11]、MDNET[12]、MCPF[13]及LMCF[14]算法等,但是目标跟踪技术还有很大提升空间。如何克服目标形变、光照变化、复杂背景、目标尺度变化以及目标遮挡等因素影响,从而稳定、实时地进行目标跟踪是一个亟待解决的问题[15]。

为了达到稳定跟踪的目的,一些研究者利用目標周围的上下文环境辅助跟踪目标定位,取得了良好的跟踪效果。Zhang等[16]提出一种简单但速度快、鲁棒性好的时空上下文(Spatio-Temporal Context,STC)跟踪算法。该算法利用稠密时空上下文进行目标跟踪,基于贝叶斯框架将目标和周边稠密环境的关系用公式表达出来,对目标底层特征(图像密度、位置)与周边环境的统计特性进行建模,然后综合这种时空建模关系与视觉特性获得下一帧目标对象周围区域的置信图,置信图中最大的位置即对应目标在下一帧中可能出现的位置。

STC算法存在一个缺点,即不能自动检测目标位置及大小,必须在人为给出目标位置及大小的前提下才能进行跟踪,因而在实际应用过程中会带来不便,且人为给出的目标位置可能与实际存在偏差。为了解决该问题,本文在原始STC跟踪算法基础上加入帧间差分检测方法[17-19],以达到自动检测与跟踪的目的。

1 帧间差分法目标检测

帧间差分法是一种简单且有效的目标检测方法。其基本原理是:在采集的图像序列中,相距较近的几帧图像在运动目标附近区域会发生较大变化,选取相邻的两帧或多帧图像作差分运算,即能得到运动目标变化区域亮度的绝对值,通过判断其与阈值的大小关系确定目标位置及轮廓[20]。差分运算公式为:

3 本文算法流程

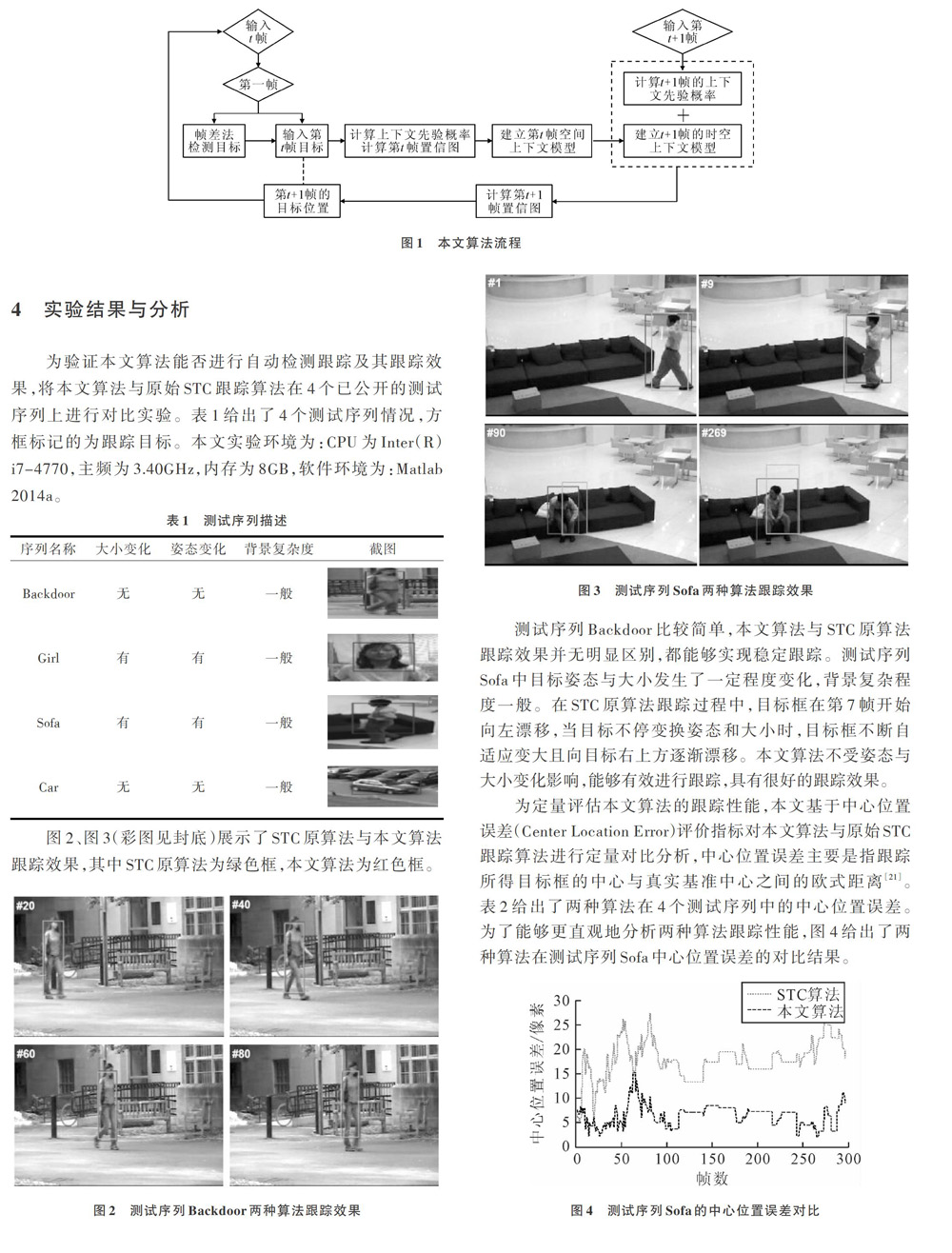

本文算法在STC目标跟踪算法基础上引入帧间差分法,可达到自动检测目标位置及其大小的目的。首先,利用相邻两帧图像作差分运算,如果绝对值差[Dk>Tn],说明该图像块含有前景目标,反之,当前图像块为背景图像;然后将得到前景目标位置及大小的矩形框传递给STC跟踪器;最后,STC跟踪器根据检测器的输出结果进行跟踪。

本文算法流程如图1所示。

4 实验结果与分析

为验证本文算法能否进行自动检测跟踪及其跟踪效果,将本文算法与原始STC跟踪算法在4个已公开的测试序列上进行对比实验。表1给出了4个测试序列情况,方框标记的为跟踪目标。本文实验环境为:CPU为Inter(R)i7-4770,主频为3.40GHz,内存为8GB,软件环境为:Matlab 2014a。

测试序列Backdoor比较简单,本文算法与STC原算法跟踪效果并无明显区别,都能够实现稳定跟踪。测试序列Sofa中目标姿态与大小发生了一定程度变化,背景复杂程度一般。在STC原算法跟踪过程中,目标框在第7帧开始向左漂移,当目标不停变换姿态和大小时,目标框不断自适应变大且向目标右上方逐渐漂移。本文算法不受姿态与大小变化影响,能够有效进行跟踪,具有很好的跟踪效果。

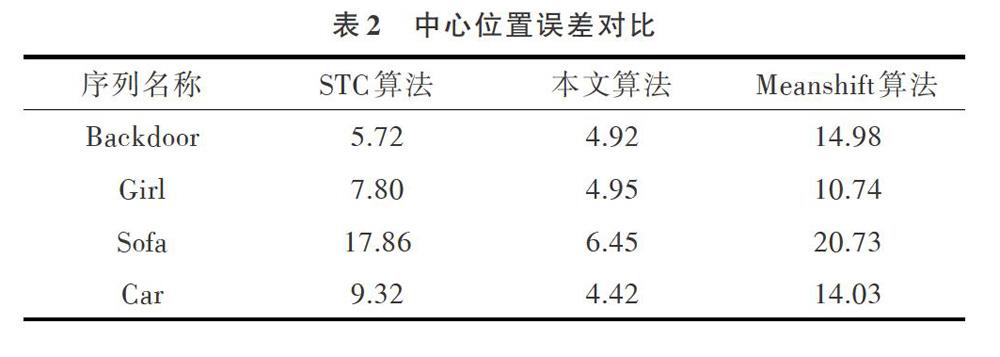

为定量评估本文算法的跟踪性能,本文基于中心位置误差(Center Location Error)评价指标对本文算法与原始STC跟踪算法进行定量对比分析,中心位置误差主要是指跟踪所得目标框的中心与真实基准中心之间的欧式距离[21]。表2给出了两种算法在4个测试序列中的中心位置误差。为了能够更直观地分析两种算法跟踪性能,图4给出了两种算法在测试序列Sofa中心位置误差的对比结果。

5 结语

本文针对STC跟踪算法不能自动检测目标位置及大小的问题,提出将帧间差分法与STC跟踪算法相结合,共同实现对目标的自动检测跟踪。帧间差分法运算简单、检测速度快,对不同场景变化不太敏感,因此能够稳定检测出目标轮廓大小,并准确得到目标中心位置。实验结果表明,本文算法能够准确、稳定跟踪测试序列中的目标,并能实现对目标的自动检测跟踪,相较于STC原算法中心位置误差有所减少,且提高了跟踪精确度。此外,由于加入帧差检测部分,跟踪速度有所下降,但仍能满足实时性要求,故接下来会将提高跟踪速度作为下一步研究重点。

参考文献:

[1] WU Y,LIM J,YANG M H. Online object tracking:a benchmark[C]. IEEE Conference on Computer Vision and Pattern Recognition,2013:2411-2418.

[2] 尹宏鹏,陈波,柴毅,等. 基于视觉的目标检测与跟踪综述[J]. 自动化学报,2016,42(10):1466-1489.

[3] 高文,朱明,贺柏根,等. 目标跟踪技术综述[J]. 中国光学,2014,7(3):365-375.

[4] LEE D Y,SIM J Y,KIM C S. Visual tracking using pertinent patch selection and masking[C]. IEEE Conference on Computer Vision & Pattern Recognition,2014:3486-3493.

[5] 代顺锋,秦晓飞. STC目标跟踪算法及改进[J]. 软件导刊,2017,16(10):51-53.

[6] KALAL Z,MIKOLAJCZYK K,MATAS J. Tracking-learning-detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2012,34(7):1409-1422.

[7] VOJIR T,NOSKOVA J,MATAS J. Robust scale-adaptive mean-shift for tracking[J].Pattern Recognition Letters,2014,49:250-258.

[8] HENRIQUES J F,CASEIRO R,MARTINS P,et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(3):583-596.

[9] ZHANG J M,MA S G,SCLAROFF S. MEEM:robust tracking via multiple experts using entropy minimization[C]. European Conference on Computer Vision,2014:188-203.

[10] MA C,HUANG J B,YANG X K,et al. Hierarchical convolutional features for visual tracking[C]. IEEE International Conference on Computer Vision,2015:3074-3082.

[11] HARE S,GOLODETZ S,SAFFARI A,et al. Struck:structured output tracking with kernels[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2016,38(10):2096-2109.

[12] NAM H,HAN B. Learning multi-domain convolutional neural networks for visual tracking[C]. IEEE Conference on Computer Vision and Pattern Recognition,2016:4293-4302.

[13] ZHANG T Z,XU C S,YANG M H. Multi-task correlation particle filter for robust object tracking[C]. IEEE Conference on Computer Vision & Pattern Recognition,2017:4819-4827.

[14] WANG M M,LIU Y,HUANG Z Y. Large margin object tracking with circulant feature maps[C]. IEEE Conference on Computer Vision and Pattern Recognition,2017:4800-4808.

[15] 劉万军,董帅含,曲海成. 时空上下文抗遮挡视觉跟踪[J]. 中国图象图形学报,2016,21(8):1057-1067.

[16] ZHANG K H,ZHANG L,LIU Q S,et al. Fast visual tracking via dense spatio-temporal context learning[C]. European Conference on Computer Vision,2014:127-141.

[17] 金汉均,梅洪洋. Sobel算子在提取视频运动目标轮廓中的应用研究[J]. 电子测量技术,2014,37(11):29-32.

[18] 郝慧琴,王耀力. 基于帧间差分和金字塔光流法的运动目标检测[J]. 电视技术,2016,40(7):134-138.

[19] 巨志勇,彭彦妮. 基于AdaBoost算法与改进帧差法的动态行人检测[J]. 软件导刊,2017,16(9):50-54.

[20] 李萌,郑娟毅,门瑜. 基于帧差法的运动车辆阴影去除算法[J]. 电视技术,2016,40(10):11-14.

[21] 徐建强,陆耀. 一种基于加权时空上下文的鲁棒视觉跟踪算法[J]. 自动化学报,2015,41(11):1901-1912.

(责任编辑:黄 健)

- 现代学徒制背景下 中职汽车专业师资队伍建设的思考

- 中职学校班主任岗位吸引力的提升策略

- 骆越文化进校园的意义及其策略

- 基于物理学科核心素养培养学生创新能力

- 核心素养视角下历史学科校本课程的研究与开发

- 词汇教学中的英语核心素养培养

- 基于核心素养的高中英语阅读教学有效策略

- 基于核心素养下的高中英语阅读教学探析

- 基于核心素养发展的高中英语语篇研读例析

- 巧用案例教学培养学生的政治核心素养

- 中职语文课堂教学的导入艺术

- 杜甫《阁夜》《登岳阳楼》的精神内涵

- PBL教学法在职业学校啦啦操教学中的应用

- 交际教学法在中职护理专业医护英语课程中的应用

- 互联网环境下汽车专业“六步一翻转”教学模式探究

- “混合式学习”在中职会计实训教学中的应用

- “六步教学法”在生物学教学中的应用

- 以读促写在高中英语教学中的应用

- 在诗歌创作中培养高中生情感激发能力

- 信息化环境下“电工技术基础与技能”课程任务驱动型教学设计探究

- 基于“i 博导”平台实施项目教学探讨

- 抽象素养视角下的数学教学设计

- 心理辅导对初三毕业生学习适应性的影响研究

- 高中体育特长女生心理压力成因与调适

- 以影视创作提升校园活力

- unauctioned

- unaudacious

- unaudaciously

- unaudaciousness

- unaudaciousnesses

- unaudible

- unaudited

- unauditioned

- unaugmentable

- unaugmented

- unauspiciously

- unaustere

- unausterely

- unauthenticities

- unauthorised

- unauthoritatively

- unauthoritativeness

- unauthoritativenesses

- unauthorized

- unauthorizedly

- unauthorizedness

- unautistic

- unautographed

- unautomated

- unautomatic

- 同根词

- 同案

- 同案犯

- 同案犯中可以作证的徒党

- 同桌

- 同梦

- 同榜考中

- 同榻

- 同榻共寝

- 同模

- 同次

- 同次关系

- 同欲相助

- 同欲者相憎,同忧者相亲。

- 同步

- 同母之兄

- 同母之弟兄

- 同母异父之妹

- 同母异父的兄弟

- 同比

- 同气

- 同气共类

- 同气相求

- 同气相求,志同道合

- 同气相煎