计算机交互式评价的开发研究

李菲茗 张浩 林丽娟 黄怡

【摘要】 计算机交互式评价以计算机模拟的形式呈现学科知识及其系统结构,并支持新颖的交互形式。评价学生的科学探究能力不仅需要创设丰富的任务情境,同时也要收集和分析学生的行为和作答数据。鉴于交互式评价与科学探究评价的契合性,文章基于以证据为中心(Evidence-Centered Design,ECD)的评价设计理念,解析了交互式科学探究评价的设计流程。首先,介绍了评价设计的理论基础——ECD框架。其次,结合科学探究评价的典型研究项目,以评价设计流程的任务分析、任务创设和数据分析为主线,总结了任务分析的领域信息来源、任务情境标准、任务创设的界面形式、学生作品和系统响应,以及数据分析中使用的多种数学模型。最后,讨论了交互式评价在评价的标准、实用性、非认知因素以及协同开发等方面应关注的问题和未来的发展方向,旨在丰富我国有关交互式评价开发的理论和实践研究。

【关键词】? ECD;计算机交互式评价;过程性数据;科学探究;任务分析;任务创设;数据分析

一、引言

在教育领域,信息通信技术(ICT)广泛应用于学校管理和教学过程,大量研究证明ICT有助于提升学校管理效率和教学质量(Kirkwood & Price, 2014)。近年来,计算机模拟和交互的技术不仅广泛应用于教学,也给教育评价的创新带来生机。基于计算机的评价,如基于模拟、情境和游戏的评价,从本质上改变了设计、开发、实现评价和收集数据的方式(Liu & Li, 2018)。基于计算机的评价能以新的方式呈现学科领域知识及其系统结构,并提供交互环境,使得被测者能够与计算机界面提供的任务指示、提示、反馈等交互,从而完成测试任务。相比纸笔测验和传统的上机考试,交互式评价主要有以下优点:首先,计算机能模拟真实世界的关键特征,创设丰富的任务情境,特别是一些无法直接或高效地通过实验室操作的现象(如地震、核裂变、捕食过程、植物生长等)(Quellmalz, Timms, Silberglitt, & Buckley, 2012)。其次,在交互式评价情境中,学生根据任务要求主动操作任务界面,并采取合适的步骤解决任务中提出的问题。再次,计算机可以以计算机日志文件的形式对学生的行为和作答数据进行实时记录。其中,学生的行为数据也称为“过程性数据”,这些数据有助于理解学生的问题解决策略,进而评价学生的高阶思维能力。最后,评价过程即学生的自主探究过程,实现了在学习情境中进行评价的理念,不仅记录了最真实的数据,也缓解了学生的考试焦虑,保证学生能够正常发挥。

交互式评价的以上特征使其更适用于需要专门知识作为推理证据的学科领域,如刑侦、心理学、医学、工程学、数学和科学等(Mislevy & Riconscente, 2005)。同时,科学学科因其丰富的画面需求与严谨的科学探究过程使得基于计算机的评价可以充分发挥技术优势。目前,交互式科学探究评价已在国际上开始应用。以美国为例,在课堂层面,基于模拟的Simscientists课程嵌入式评价持续地收集学生的行为数据,为学生提供即时反馈和修改答案的机会,从而实现对学生的个性化指导(Quellmalz, et al., 2012);在州層面,明尼苏达州通过模拟实验室实验和调查科学现象进行在线科学测试,犹他州也试验了科学模拟评价(King, 2011);在国家层面, 2009年(美国)全国教育进展评估(National Assessment of Educational Progress, NAEP)开始设计基于计算机的科学探究试题,之后针对技术和工程素养,NAEP于2014年开发了基于计算机交互的情境试题。在国际层面,每三年举行一次的国际学生测评项目(Program for International Student Assessment, PISA)自2006年开始纳入基于计算机的试题形式,2015年的部分科学试题采用了新型的人机交互形式。随着交互式科学探究评价的发展,Visual Performance Assessment(VPA)、River City 多用户虚拟环境(multi-user virtual environment, MUVE)等评价项目也接踵而来,旨在开发技术更加丰富、情境更加真实的评价(Baker, Clarke-Midura, & Ocumpaugh, 2016; Ketelhut, Nelson, Clarke, & Dede , 2010)。这些评价与下一代科学课程标准(Next Generation Science Standards, NGSS)密切关联,给美国各州提供了具有良好信效度的交互式科学探究评价。

当前,我国也开始重视STEM(Science, Technology, Engineering, Mathematics)教育及其与信息技术融合的研究(董泽华, 2016)。STEM教育以科学、技术、工程和数学学科为核心,以任务为基础并强调其课程跨学科整合(余胜泉, 等, 2015; 赵慧臣,等, 2017; 赵中建, 2016)。与STEM基于任务学习的理念一致,作为STEM课程核心内容的科学探究的评价也应该是基于任务的评价,而计算机提供的交互环境为实施基于任务的评价提供了可能。目前,我国有关交互式科学探究评价的研究还集中在对PISA、NAEP等评价的试题进行分析的阶段,如有关PISA试题设计和测评框架的分析、基于PISA测试数据的研究等(刘帆, 等, 2015; 刘克文, 等, 2015; 张莉娜, 2016)。然而,对如何开发此类试题还没有开展研究。

因此,本文将对构建计算机交互式试题的理论框架和开发流程进行分析,并以目前此类试题中比较成熟的科学探究试题为例展开说明,旨在为交互式科学探究评价的本土化研究和实践提供思路。首先,文章介绍国际最为通用的以证据为中心的设计(Evidence Centered Design, ECD, Mislevy, 1995)的评价框架。与此对应,通过具体案例解析交互式科学探究评价的设计流程。最后,文章进一步从评价的标准、实用性、非认知因素以及协同开发等方面指出了当前评价开发过程中应关注的问题和未来的发展方向。

(一)任务分析

任务分析过程涉及:①对任务情境在日常生活中的常见性或典型性进行分析;②对学生完成任务需具备的领域知识、技能和能力(KSAs)进行分析。

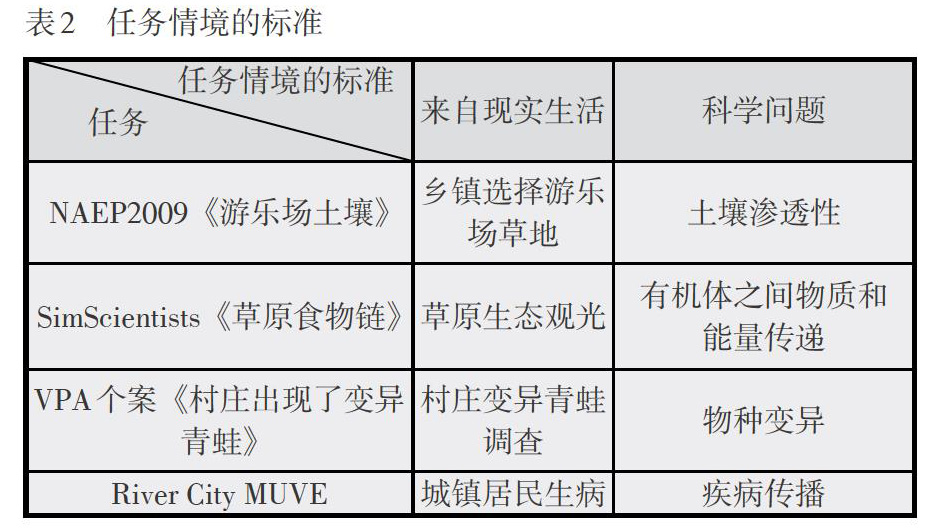

通过模拟现实生活中常见问题情境的方式来提高学生对科学探究的理解和兴趣是交互式任务设计的初衷。任务设计者应明确评价情境是否来源于生活,蕴含的问题是否为科学问题。表2列举了四个典型计算机交互科学探究任务在这些方面的考虑。

另外,领域相关的知识、技能和能力(KSAs)信息的来源包括课程标准、教科书及其他课程材料,其中最重要的信息来自课程标准。美国国家科学课程标准(NSES)是一种旨在提高公民科学素养的综合化课程标准,涵盖所要遵循的科学原则、教学、评价、内容标准等内容,其中内容标准部分将科学探究过程按阶段进行了划分。下一代美国科学课程标准(NGSS)在NSES基础上进一步明确了科学探究实践、领域核心知识、跨学科概念及其之间的相互作用(National Research Council, 2013)。如由美国自然科学基金(NSF)支持的SimScientists、ScienceASSISTments和Biokids等研究项目整合了领域核心知识和科学探究实践,用以考察学生的科学素养(Pellegrino, 2013)。我国的科学课程标准,如《义务教育初中科学课程标准(2011年版)》,将科学探究能力以提出问题、做出假设、制定方案、收集证据、解释评价、表达交流的线性方式展开,基本沿用了NSES的分类(中华人民共和国教育部, 2012)。

(二)任务创设

基于ECD框架中的任务模型,评价设计者在创作任务前需要编写包含界面形式、学生作品、系统响应等成分的脚本,为创作任务提供详细的指导。

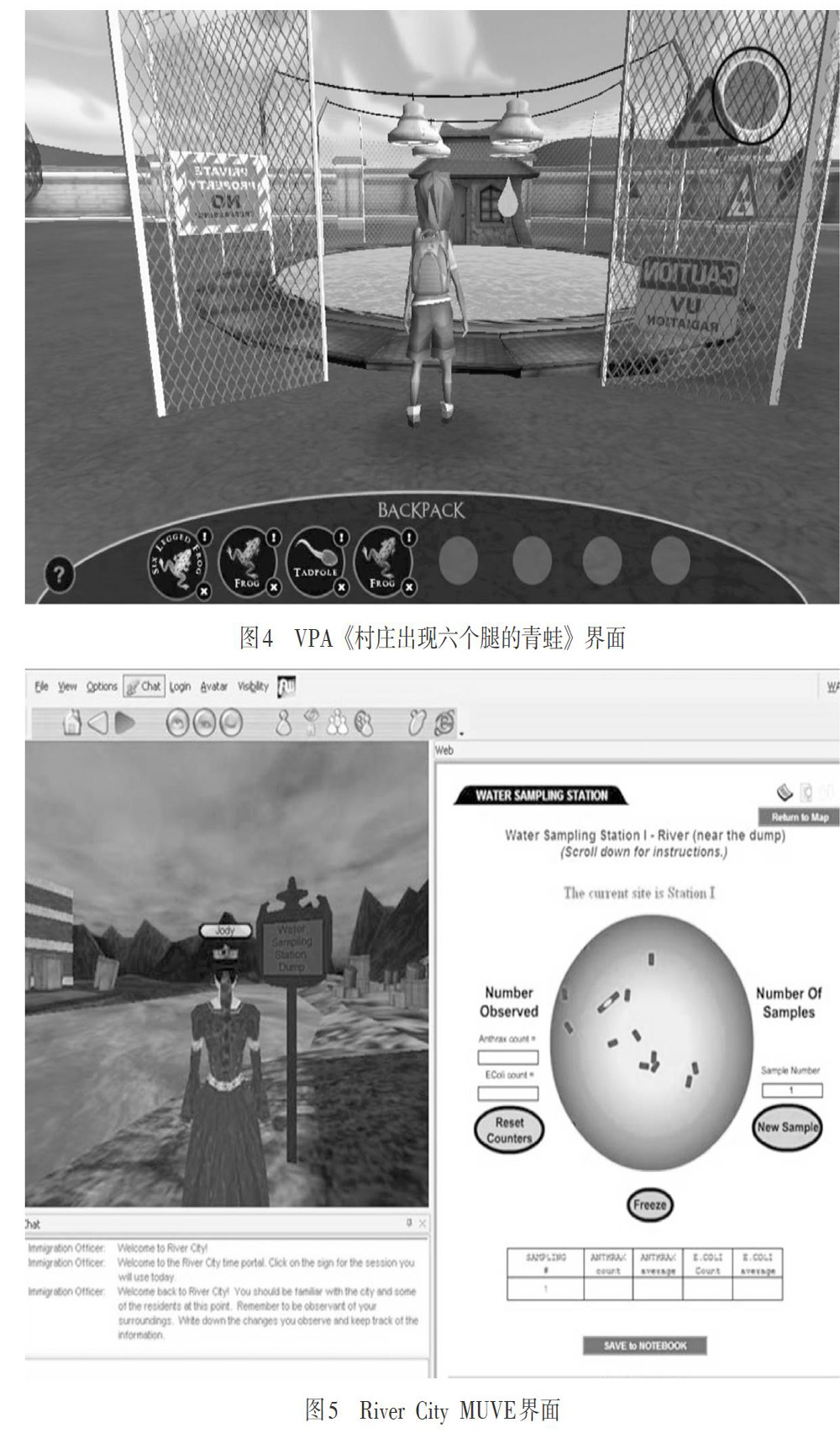

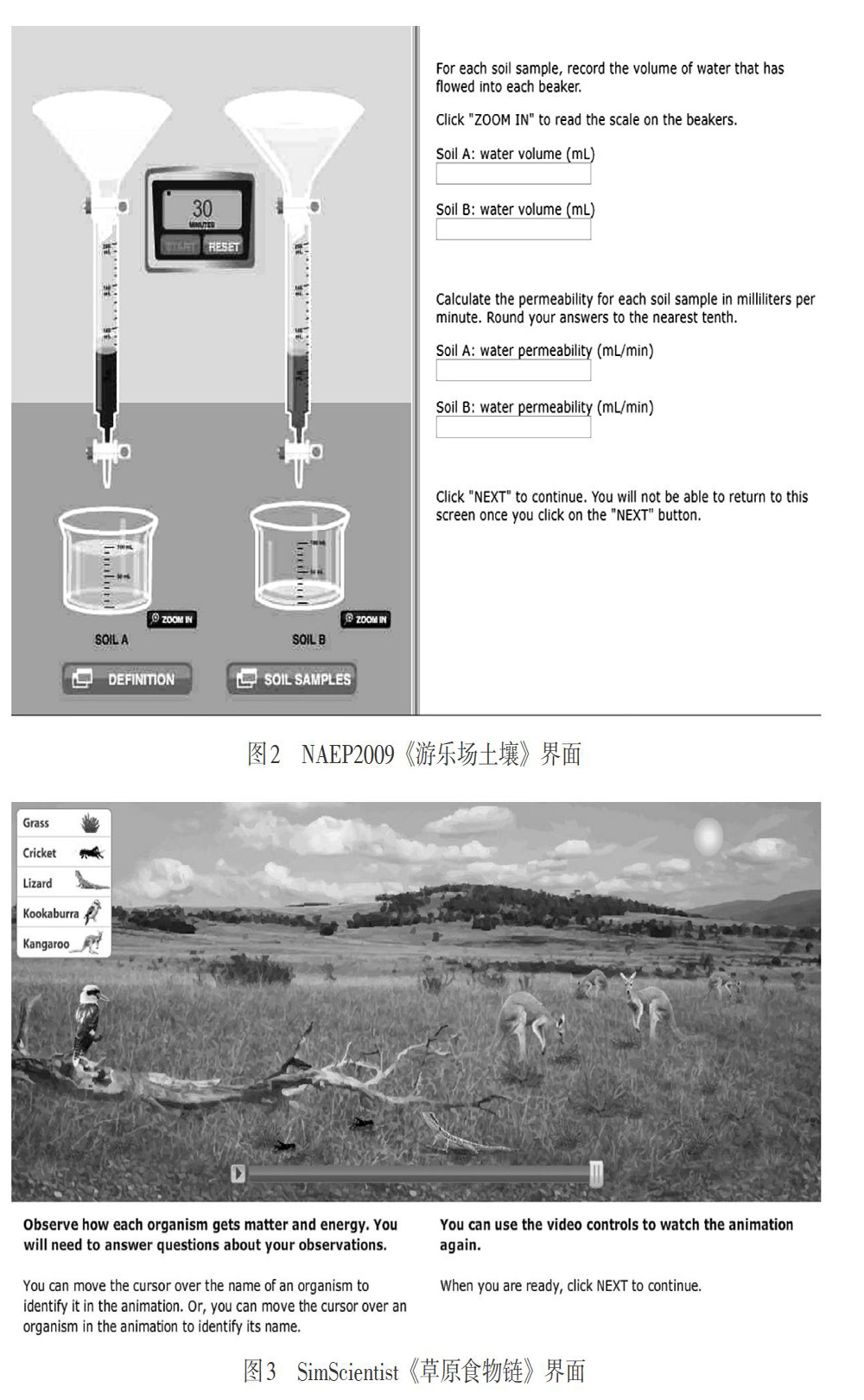

目前,基于计算机的交互式科学探究评价的操作界面主要包括两种形式,即二维操作界面和沉浸式三维虚拟世界。二维操作界面普遍应用于PISA、NAEP等大规模评价及Calipers、SimScientists、Inq-ITS等研究项目(Hatzinikita, Dimopoulos, & Christidou, 2010; Herman, 2011; Li, Gobert, & Dickler, 2017; Quellmalz, et al., 2005; Quellmalz, Timms, & Buckley, 2010;Wixon, Baker, Gobert, Ocumpaugh, & Bachmann , 2012)。NAEP八年级科学试题《游乐场土壤》界面(NAEP Science 2009: Playground Soil, 2009)基于动画对实验材料及操作流程进行了模拟,界面还设置了放大键、对渗透率定义的解释键和样例土壤的切换键(见图2)。实施/执行指示指明任务时限为20分钟,并声明测试目的是通过调查两种土壤样例的属性来决定游乐场的最佳场址。任务指示提出学生需要调查来自两个地点的土壤样例的渗透率,并做出下一步的行动指示(2009)。SimScientists(2015)《草原食物链》问题基于动画模拟了草原生态系统(见图3)。任务指示提出学生首先要观察一段包含草原生物之间相互作用的动画,特别是其中每个生物获取物质和能量的方式,最后基于观察结果回答问题。另外,学生还可以通过移动在生物名称上的光标来辨识生物体的外在形态,移动在生物体上的光标来识记生物体的名称。

沉浸三维虚拟世界及加入游戏元素的虚拟世界,即虚拟游戏,常见于一些研究项目,如VPA、SAVE Science、River City、Crystal Island等(Baker,et al., 2016; Baker & Clarke-Midura, 2013; Nelson, Kim, & Slack, 2016; Taub, Azevedo, Bradbury, Millar, & Lester, 2017; Taub, et al., 2017)。如VPA项目案例,《村庄出现了变异青蛙(there is a new frog in the town)》模拟了一个发生青蛙变异的村庄,村庄包含多个有池塘的农场、蝌蚪、正常青蛙、带有六条腿的多色青蛙、科学实验室、一名科学家和多名农民(见图4)。实施/执行指示指导教师和学生登录评价系统的方式和流程。教师需要登录教师页面,为学生开设账户,选择要执行的评价。学生需要登录学生界面,选择代表自己的“虚拟人物”并进入系统。任务指示通过镜头切换的形式进行,为学生提供通向问题空间的视角。学生首先会看到一个村庄,紧接着看到多个带有池塘的农场。然后镜头集中在一只六条腿的多色青蛙。此时评价开始,那些已经发现变异青蛙的科学家和农民会问候代表学生的“虚拟人物”。农民会提出许多青蛙变异原因的假设,然后科学家询问学生认同哪些假设,并告知学生要进行调查并得出可以基于证据进行检验的结论(Baker,et al., 2016; Clarke-Midura, Code, Zap, & Dede , 2012)。River City多用户虚拟环境是一座19世纪的工业城市,其中包含各种社区、工厂、机构(如医院和大学)以及一条穿城而过的大河,不同的地形影响水的径流。实施/执行指示指导学生选择代表自己的“虚拟人物”,与环境中的其他参与者或代理人通过对话框和虚拟姿势交流。学生可以通过点击环境中的物品触发内容,也可以使用数字工具来观察样本(见图5)。任务指示是River City 市长委托学生回到1878年,帮助她查出居民生病的原因。River City同时发生三种基于多种致病因素的疾病,这使得学生需要进行多种探究活动(Ketelhut, 2007)。

学生作品由操作界面决定,二维动画界面的学生作品依赖于具体的题目类型。IMS Global Learning Consortium尝试建立了以多媒体形式编码题目的标准方法,开发了题目和测试互操作(Question and Test Interoperability, QTI) 规范,当前版本包含32类交互空间,能够用来创建多种题目类型,包括不同类型的选择、填空、拖放、画线、高亮、排序和扩展性文本等(IMS Global Learning Consortium, 2002)。NAEP2009八年级科学题《游乐场土壤》、SimScientists《草原食物链》问题包含了选择、填空、拖放以及生成扩展性答案的文本框等多种题型。和二维操作界面依赖于学生對题目的作答来反映学生的能力水平不同,三维虚拟世界对学生表现的评价建立在学生与近乎真实的世界进行交互的基础上。在VPA系统中,学生的科学探究能力通过一系列选择来表现,这一系列选择产生的丰富观察结果能够很好地反映学生在科学探究各子维度上的熟练水平。在VPA个案《城镇出现变异青蛙》中,学生基于假设选取样本并在虚拟实验室中对这些样本进行实验,最终提出有证据支持的结论(Baker,et al. , 2016; Clarke-Midura, et al., 2012)。在River City MUVE中,学生用代表自己的“虚拟人物”与多个参与者组成小组,共同访问虚拟世界,通过与基于计算机的代理人交流制定各种类型的协作学习活动,以创建一个探究学习者社区。学生小组对三种疾病的病因提出假设,选取样本并进行检验,最后在“致市长的一封信”中写下真实的实验报告(Ketelhut, et al., 2010)。

系统响应指在科学探究过程中交互式评价系统自动呈现的或由学生操作触发的信息提示和反馈,具体表现形式包括正确答案、对答案的解释等,信息呈现的丰富程度由学生的水平决定。按照响应的时间节点,可分为即时反馈和任务完成后的整体反馈。提供即时反馈的评价可以自动评估学生的KSAs,并根据评估结果来确定是否给予提示及给予什么样的提示,同时通过实时抓取对相同或相似问题的尝试次数,为学生提供逐级水平的脚手架。例如:SimScientists课堂嵌入式评价会根据不同作答情况给予不同的提示。当题目作答错误时,系统显示指导方案;当错误答案没有得到修改时,系统显示请继续修改;当作答次数过多时,系统提示指导方案和正确答案(Quellmalz, et al., 2012)。SimScientists中的单元基准评价为教师和学生提供有关整体表现的信息反馈。在单元基准评价中,系统不会为学生提供即时反馈,但会记录学生的作答结果和行为数据,并在学生完成评价后以整体报告的形式描述学生相关KSAs水平(Quellmalz, Silberglitt, Buckley, Loveland, & Brenner , 2016)。

(三)数据分析

相较于以选择题为主的传统上机考试,计算机交互式评价的题目类型更为多样,因此最终收集的数据类型也比较多样。二维操作界面的數据主要来自对多种试题类型的输入,如选择的字母、可扩展性文本中的解释、测量或计算的数字等。而三维虚拟世界赋予学生更多的自主选择,数据类型包括与虚拟对象的交互、操作的时间点和时长、对探究流程的决策、对样本的选择与实验等过程性数据,因此数据分析难度相比二维操作界面更大。

目前,二维操作界面的数据分析模型主要有项目反应理论(Item Response Theory, IRT)(Quellmalz ,et al. , 2012)。在NAEP2009八年级科学题《游乐场土壤》中,首先根据NAEP评分标准确定每个题目的得分即可观察变量,每个题目对应单独的评估过程。虽然每个题目只与一个学生模型变量相联系,但由于整个任务中存在多个题目测量不止一个学生模型变量的情况,因此针对整个任务的数学模型是题目间的多维模型。同时,任务中存在顺序依赖的题目,如计算土壤渗透率的题目依赖于测量水容积的题目。针对存在依赖关系即违反条件独立性的题目,可以通过“捆绑”(Bundle)的方式使得相关题目得出单一的分数,独立于任务中其他题目的分数。而处理“捆绑”产生的“捆绑内”多个维度的方式,依赖于每个捆绑内的学生模型变量(Seibert, Hamel, Haynie, Mislevy, & Bao, 2006)。

在三维虚拟世界中,学生行为数据被后台记录下来,包括行为类型、行为位置、被操作对象、交互细节以及时间戳等计算机日志文件(Baker, et al., 2016; Ketelhut, Nelson, Sil, & Yates, 2013; Leeman-Munk, Wiebe, & Lester, 2013)。分析学生行为数据包括两个步骤:学生的初始行为数据被编码为有意义的特征;运用数据挖掘技术产生评价学生表现的数学模型。VPA个案《城镇出现变异青蛙》的初始行为数据被处理为48个语义特征,用于预测学生最终结论的正确性(青蛙六条腿的原因)和设计因果解释的能力(结论正确的原因)。对学生最终结论的评价基于学生最终答案的正确性,最终答案被视为二分类问题,适合采用决策树的一种衍生算法:基于信息增益的规则归纳算法-JRip Decision Rules、Kappa 和A作为模型好坏的度量。对设计因果解释能力的评价基于学生提供的证据支持结论的程度来分配分值。首先要求学生识别作为证据的数据,然后学生指出选择的数据是否可以作为结论的证据,最后这些证据通过各个指标汇总成单一的评价结果。设计因果解释能力的数据分析模型可以采用线性回归,模型解释率作为模型好坏的度量(Baker & Clarke-Midura, 2013)。

四、启示与未来

(一)制定评价标准

虽然课程标准是领域知识、技能和能力(KSAs)信息的重要参考,但并不能直接为试题编制人员提供指导。NAEP评价框架依据美国《国家科学教育标准》《科学素养基准》以及PISA评价框架,详细说明了学生科学素养的期望表现,用于指导NAEP试题设计。我国用于规范中考和高考的《考试说明》同样依据课程标准,重视考查科学探究能力,同时根据课程标准三维目标分类提出了初中毕业生应该达到的水平。然而,无论是NEAP评价框架还是《考试说明》,都未能基于年级水平提供评价设计的操作性方案,导致试题考查内容与课程标准中的考察目标不一致。因此,科研工作者应立足课程标准,确定评价标准,进而编制可操作的试题设计手册。

(二)保证评价实用性

过分关注情境真实性会影响评价设计的实用性。评价的实用性受学生实施交互行为效果的影响。具体而言,如果与真实情境高度一致的交互空间允许学生采用准确而有效的方式产生反应,为有特殊需求的学生提供足够的辅助功能,那么评价实用性会最大化。相反,如果与真实情境高度一致的交互空间对于一些学生来说效率低或难以访问,则其实用性会降低。因此评价设计必须同时考虑情境真实性、可用性和对特殊学生群体的无障碍性(Russell, 2016)。

(三)关注非认知因素

交互式科学探究评价设计除对学生的科学探究水平进行估计之外,还需要关注学生的非认知因素(如科学态度、参与度、幸福感等),从多个方面了解科学教育质量。PISA2015将科学态度分为对科学的兴趣、评价科学探究方法的价值和环境意识三个维度,其中对科学的兴趣又可以进一步分为对科学议题的兴趣、科学乐趣、科学活动参与、未来职业期望、工具性动机、科学自我效能等,通过学生问卷的形式进行考察(PISA, 2015)。

(四)增进跨领域协作

尽管采用ECD理论框架可以指导评价设计,但评价设计的有效性需要科研工作者、科学教师和技术人员共同参与和合作。科研工作者编写可操作的评价框架,科学教师根据评价框架编写题目脚本,技术人员根据脚本生成最终的交互式科学试题。在实际工作中,教育管理部门也应该参与其中,保证编制的交互式科学试题符合本土要求。

[参考文献]

董泽华. 2016. 试论我国中小学实施STEM课程的困境与对策[J]. 全球教育展望,45(12):36-42.

冯翠典. 2012. “以证据为中心”的教育评价设计模式简介[J]. 上海教育科研(8):12-16.

刘帆,文雯. 2015. PISA2015 科学素养测评框架新动向及其对我国科学教育的启示[J]. 外国教育研究,42(10):117-128.

刘克文,李川. 2015. PISA2015科学素养测试内容及特点[J]. 比较教育研究(7):98-106.

郑兰琴,孙巍,张定文. 2018. 利用技术促进教与学的创新:访国际教育技术协会首席学习官Joseph South教授[J/OL]. 中国远程教育:1-7. [2019-04-14]. https://doi.org/10.13541/j.cnki.chinade

余胜泉,胡翔. 2015. STEM教育理念與跨学科整合模式[J]. 开放教育研究(4):13-22.

袁建林,刘红云. 2017. 核心素养测量:理论依据与实践指向[J]. 教育研究(7):21-28.

张莉娜. 2016. PISA2015科学素养测评对我国中小学科学教学与评价的启示[J]. 全球教育展望(3):15-24.

赵慧臣,周昱希,李彦奇,刘亚同,文洁. 2017. 跨学科视野下“工匠型”创新人才的培养策略:基于美国steam教育活动设计的启示[J]. 远程教育杂志(1):94-101.

赵中建. 2016. 美国中小学工程教育及技术与工程素养评估[J]. 全球教育展望,45(12):3-24.

中华人民共和国教育部. 2012. 初中科学课程标准 (2011年版)[S]. 北京:北京师范大学出版社.

NAEP.(2009). NAEP Science 2009: Playground Soil, retrieved October 19, 2018, from https://www.nationsreportcard.gov/science2009ict/soil/soil1.aspx

SimScientists.(2015). The embedded formative assessments for ecosystems, retrieved July 25, 2018, from http://simscientists.org/MiniSite/media/ecoglem1_08_01_13/app.html

Baker, R. S., Clarke-Midura, J., & Ocumpaugh, J. (2016). Towards general models of effective science inquiry in virtual performance assessments. Journal of Computer Assisted Learning, 2(3), 267-280.

Baker, R. S., & Clarke-Midura, J. (2013, June). Predicting successful inquiry learning in a virtual performance assessment for science. In International Conference on User Modeling, Adaptation, and Personalization (pp. 203-214). Springer, Berlin, Heidelberg.

Haynie, K. C., Haertel, G. D., Lash, A. A., Quellmalz, E. S., & DeBarger, A. H. (2006). Reverse engineering the NAEP floating pencil task using the PADI design system. Menlo Park, CA: SRI International.

Hatzinikita, V., Dimopoulos, K., & Christidou, V. (2010). PISA test items and school textbooks related to science: A textual comparison. Science Education, 92(4), 664-687.

Herman, J., Dai, Y., Htut, A. M., Martinez, M., & Rivera, N. (2011). Evaluation of the enhanced assessment grants (EAGs) SimScientists program: Site visit findings. Los Angeles: CRESST.

IMS Global Learning Consortium. (2002). IMS Question & Test Interoperability: An Overview Final Specification Version 1.2. retrieved July 25,2018, from https://www.imsglobal.org/question/qtiv1p2/imsqti_ovi ewv1p2.html

Ketelhut, D. J. (2007). The impact of student self-efficacy on scientific inquiry skills: An exploratory investigation in River City, a multi-user virtual environment. Journal of Science Education and Technology, 16(1), 99-111.

Ketelhut, D. J., Dede, C., Clarke, J., Nelson, B., & Bowman, C. (2017). Studying situated learning in a multiuser virtual environment. In Assessment of problem solving using simulations(pp. 47-68). Routledge.

Ketelhut, D. J., Nelson, B., Sil, A., & Yates, A. (2013). Discovering what students know through data mining their problem-solving actions within the immersive virtual environment. SAVE Science. American Educational Research Association.

Ketelhut, D., Nelson, B., Clarke, J., & Dede, C. (2010). A multi-user virtual environment for building and assessing higher order inquiry skills in science. British Journal of Educational Technology, 41(1), 56-68.

King, K. (2011). Balanced, multilevel science assessment systems. In National Conference on Student Assessment. Orlando, FL.

Kirkwood, A., & Price, L. (2014). Technology-enhanced learning and teaching in higher education: What is ‘enhanced and how do we know? A critical literature review. Learning, media and technology, 39(1), 6-36.

Leeman-Munk, S., Wiebe, E. N., & Lester, J. (2013). Mining student science argumentation text to inform an intelligent tutoring system. In AERA Annual Meeting, San Francisco.

Li, H., Gobert, J. D., & Dickler, R. (2017). Automated Assessment for Scientific Explanations in On-line Science Inquiry. In EDM.

Liu, H., Liu, Y., & Li, M. (2018). Analysis of Process Data of PISA 2012 Computer-Based Problem Solving: Application of the Modified Multilevel Mixture IRT Model. Frontiers in psychology, 9.

Messick, S. (1994). The interplay of evidence and consequences in the validation of performance assessments. Ets Research Report, 23(2), 13-23.

Mislevy, R. J. (1995). Evidence and inference in educational assessment. Psychometrika, 59(4), 439-483.

Mislevy, R. J., Steinberg, L. S., Almond, R. G., Haertel, G. D., & Penuel, W. R. (2003). Leverage points for improving educational assessment. In B. Means, G. D. Haertel(Eds.), Evaluating the effects of technology in education (pp. 149-180).Mahwah: Lawrence Erlbaum.

Mislevy, R. J., & Riconscente, M. M. (2005). Evidence-Centered Assessment Design: Layers, Structures, and Terminology.

National Research Council. (2013). Next generation science standards (95). Washington, D C: National Academies Press.

Nelson, B. C., Kim, Y., & Slack, K. (2016). Visual signaling in a high-search virtual world-based assessment: A SAVE science design study. Technology Knowledge & Learning, 21(2), 1-14.

Pellegrino, J. W. (2013). Proficiency in science: Assessment challenges and opportunities. Science, 340(6130), 320-323.

OECD.(2013-03-12).Draft PISA 2015 Science Framework. retrieved? September 20, 2019, from http:/www.oecd.org/pisa/pisa products/pisa 20l5 draft frameworks.html

Quellmalz, E. S., DeBarger, A. H., Haertel, G., Schank, P., Buckley, B., Gobert, J., & Ayala, C. (2008). Exploring the role of technology-based simulations in science assessment: The Calipers Project. In J. Coffrey, R. Douglas, & C. Stearns(Eds.), Science assessment: Research and practical approaches (pp.191-202). Washington, DC: National Science Teachers Association.

Quellmalz, E. S., Silberglitt, M. D., Buckley, B. C., Loveland, M. T., & Brenner, D. G. (2016). Simulations for supporting and assessing science literacy. In Handbook of research on technology tools for real-world skill development (pp. 191-229). IGI Global.

Quellmalz, E. S., Timms, M. J., Silberglitt, M. D., & Buckley, B. C. (2012). Science assessments for all: Integrating science simulations into balanced state science assessment systems. Journal of Research in Science Teaching, 49(3), 363-393.

Quellmalz, E. S., Timms, M. J., & Buckley, B. (2010). The promise of simulation-based science assessment: The Calipers project. International Journal of Learning Technology, 5(3), 243-263.

Russell, M. (2016). A framework for examining the utility of technology-enhanced items. Journal of Applied Testing Technology, 17(1), 20-32.

Seibert, G., Hamel, L., Haynie, K., Mislevy, R., & Bao, H. (2006). Mystery powders: An application of the PADI design system using the four-process delivery system. Draft PADI Technical Report 15. Menlo Park, CA: SRI International.

Taub, M., Azevedo, R., Bradbury, A. E., Millar, G. C., & Lester, J. (2018). Using sequence mining to reveal the efficiency in scientific reasoning during STEM learning with a game-based learning environment. Learning & Instruction, 54, 93-103.

Taub, M., Mudrick, N. V., Azevedo, R., Millar, G. C., Rowe, J., & Lester, J. (2017). Using multi-channel data with multi-level modeling to assess in-game performance during gameplay with Crystal Island.Computers in Human Behavior,76, 641-655.

作者簡介:李菲茗,博士,教授,硕士生导师,浙江师范大学教师教育学院(321004)。

张浩,硕士研究生;林丽娟,硕士研究生;黄怡,硕士研究生。浙江工业大学教育科学与技术学院(310023)。

责任编辑 单 玲