智能导师系统对学业成就的影响研究: 量化元分析的视角

汪维富 毛美娟 闫寒冰

【摘 要】智能导师系统是运用人工智能技术模拟人类教师辅导行为,为学习过程提供自适应的交互反馈,是信息技术促进个性化学习的重要标志性产品。然而,在智能导师系统能否改进学业成就的问题上仍然存在着较大争议。为此,研究主要采用量化元分析方法,针对1990年以来国际上关于智能导师系统提升学业成就的58篇实证研究进行了综合分析。研究发现:智能导师系统对学业成就的平均效应量为0.492,具有中等的正向提升作用,能将第50个百分位的学生成就提高至约第68个百分位;在不同的学生特征、发表特征与研究设计特征中都发现了智能导师系统的正向促进作用,其中测试类型、持续时间与样本量对平均效应量具有显著的调节作用,本地测试的平均效应量大于标准化考试,实验处理时间越长的平均效应量越大,而样本量超过200后,平均效应量显著下降。建议国内教育技术领域扩大实证研究规模,建立规范、严谨的干预规范与实践指南,促进学科领域的健康发展。

【关键词】? 智能导师系统;元分析;学业成就;个性化学习;计算机辅助教学;效应量;人工智能;认知辅导系统

【中图分类号】? ?G434? ? ? ? 【文献标识码】? A? ? ? ?【文章编号】? 1009-458x(2019)10-0040-12

一、引言

从孔子私塾式的一对一启发式教学到现代班级制度的一对多授课,从大众媒体的单向知识传播到人工智能的人机对话交互,人类辅导学习的历史可谓源远流长,而基于机器的辅导是学业辅导历史中较晚出现的一种新形式。虽然利用机器辅助或代替人类个体开展教学活动的实践探索远早于数字电子计算机与人工智能的发明(张志祯, 等, 2019),但正是电子计算机的出现才让机器辅导的大规模探索与应用成为现实。20世纪50年代开始出现的教学机器与程序化教学系统,基于行为主义学习理论,以片段分块、顺序分支的方式呈现事先准备好的固定教学内容,提供适度的交互反馈并引出后续学习内容。这种系统被统称为计算机辅助教学系统(Computer-Aided Instruction, CAI),具有机械性、程序化、预设性与封闭性特征。20世纪70年代出现了一种新型的机器辅导系统,它扎根于人工智能理论与认知理论,从专家知识库中创建自动化的提示与反馈,依据学生知识水平与风格提供自适应性的精细化脚手架,被统称为“智能导师系统”(Intelligent Tutoring Systems, ITSs)。智能导师系统与纯粹的CAI有明显区别,智能导师系统增强了学习环境的自适应能力,具备一定的情境感知、自然语言理解、推理进化、智能适应和自我学习的能力。

智能导师系统是按照人类辅导行为的理念来开发的(Woolf, 2009),以帮助具有不同基础、风格与背景的学生实现个性化学习。特别是随着人工智能技术的不断发展,智能导师系统能有效追踪学生的知识水平、学习策略、情感状态、学习风格并给予自适应的智能辅导等,这可能是人类辅导人员都无法做到的精细化水平,但人工智能实现教学自动化依然会存在限度(张志祯, 等, 2019)。现阶段,智能导师系统能否提升学习成效?是否比传统课堂教学更有效?哪些因素会影响智能导师系统提升学业成就?这些是教育技术领域需要回答的重要问题。

二、相关研究综述

范莱恩(VanLehn, 2011)总结了不同辅导形式对于提升学业成就的影响效应,认为计算机辅助教学系统比常规教学提高约0.3个标准差,智能导师系统能提高约1个标准差,而人类辅导被认为是最有效的,能提高2个标准差,即将第50个百分位的学生提升至第98个百分位。这是范莱恩根据前几十年的相关研究所做出的推断,结果是否真实呢?

关于计算机辅助教学系统有效性的观点还是比较可信的。从元分析的整体视角考察,早期计算机辅助教学系统的影响效应量处在0.37~0.42之间(Burns, 1981; Hartley, 1978)。库利克等人(Kulik, et al., 1991; Kulik, 1994, 2002)持续开展了多次跟踪性分析,发现CAI能带来0.30~0.38个标准差的提升。巴伊拉克塔尔(Bayraktar, 2001)也发现CAI能为中学生与大学生的科学教育成绩提高0.273个标准差。最近,索萨等人(Sosa, et al., 2011)发现CAI能为大学生带来0.33个标准差的成绩提升。塔米姆等人(Tamim, et al., 2011)针对25项关于教学技术与系统有效性的元分析进行了二次综述,发现14个CAI的平均效应量是0.26个标准差。然而,CAI在特定领域的影响差异较大,如在早期阅读(Blok, et al., 2002)中存在偏低的效应量(0.19),而在特殊教育领域(Kroesbergen, et al., 2003)又具有偏高的效应量(0.75)。但从整体上考察,提高约1/3个标准差是CAI影响效应较为一致的结论。

关于人类辅导的有效性难以找到一致的直接证据。人类辅导提高2个标准差的观点来自于布鲁姆的一篇颇具影响力的文章(Bloom, 1984),他提出了著名的“雙西格玛(two-sigma)”问题,认为每个学生通过一对一的个性化辅导都能取得2个标准差的成绩提升。他在实验中发现,在无人辅导的情况下,掌握学习小组比常规教学小组提高了1.2个标准差,而有教师辅导的掌握学习小组又额外提高了0.8个标准差,共产生2个标准差的效应。这种改进效应是人类辅导与掌握学习策略混合干预的结果,并没有单独评估人类辅导的直接效应。范莱恩(VanLehn, 2011)发现了人类辅导的改进效应量为0.79个标准差,明显低于布鲁姆的结论。此外,柯恩等人(Cohen, et al., 1982)发现中小学同伴辅导仅能提高0.4个标准差,成人辅导能给小学生成绩带来0.3个标准差的提升(Ritter, 2009),刘珊珊与杨向东(2015)发现课外辅导对学业成绩的效应量仅为0.27,甚至李佳丽(2017)还发现一对一家教补习对于小学生的成绩有显著的消极影响。这些研究结论与布鲁姆得出的2个标准差的效果有巨大差异,有待更严谨的合成分析。

智能导师系统从诞生起就被赋予实现个性化学习辅导的期望,然而对于学业成就提升的成效影响至今争议很大。认知辅导系统(Cognitive Tutor, CT)是美国K-12广泛应用的一款数学智能导师系统,安德森等人(Anderson, et al., 1995)发现早期版本的CT能产生1个标准差的成绩提升,但利特等人(Ritter, et al., 2007)发现较新版本的CT只能提高0.38个标准差。按照美国教育部有效教育策略资料中心(What Works Clearinghouse, WWC, 2017)的标准,认为能提高0.25个标准差就表示有实质性的重要影响,因此,他们认为CT具有实质性的重要影响。近年来,通过元分析,范莱恩(VanLehn, 2011)发现智能导师系统能平均提高0.76个标准差。库里克与弗莱彻(Kulik & Fletcher, 2016)分析了50项ITSs应用于学业改进的独立研究,发现能提高0.66个标准差。玛等人(Ma, et al., 2014)针对73个独立实证研究进行元分析,发现其平均效应量是0.43个标准差,且产品类型、对照组类型、测试类型等因素的调节作用显著。斯滕贝格·胡与库珀(Steenbergen-Hu & Cooper, 2014)發现ITSs能为大学生学业成绩带来0.37个标准差的提升。然而,美国教育部有效教育策略资料中心(WWC, 2016)另一项综合评估报告发现,CT的平均效应量接近零。斯滕贝格·胡与库珀(Steenbergen-Hu & Cooper, 2013)的另一项元分析发现,ITSs在K-12数学科目中只能提高0.05个标准差,也微不足道。

ITSs是从CAI发展而来的,能实现更智能化、个性化的学习辅导。根据CAI能提高1/3个标准差的基本共识,ITSs与传统教学比较,应该还能额外增加效应量。然而,目前针对ITSs的有效性评价却是如此缺乏共识,令人吃惊。如今,人工智能正从1.0走向2.0(潘云鹤, 2018),人工智能在教育领域中的应用不断发展升级,作为典型的教育类人工智能产品,吸引了越来越多的社会关注,若ITSs在有效性这个重要问题上不能达成一个基本共识,不利于人工智能在教育领域的规模化应用。因此,本研究采用量化元分析方法(Quantitative meta-analysis)来试图回应这个重要问题。

三、研究过程

量化元分析(也称“元分析”)是国际上广泛使用的一种合成性实证研究方法,能针对一个主题的多项独立实验研究的结果进行再次合并分析,充分挖掘不同实验特征对总体结果的影响程度,获得更具普适性的研究结论。根据格拉斯等(Glass, et al., 1981)关于元分析的研究,本研究包括文献准备、特征编码、效应量计算与分析和结果讨论四个阶段。

(一)文献准备

1. 文献搜索

广泛搜集关于智能导师系统的实验或准实验研究,一方面,通过国外权威文献数据库(ERIC, Proquest Dissertation and Theses, ScienceDirect, Wiley, SpringerLink)与Google学术引擎搜索候选文献,检索时用技术关键词(如intelligent tutoring system、artificial tutor、pedagogical agents等)与学业关键词(如learning gains、outcome、achievement、performance、improvement、evaluate等)进行交叉检索,限定时间为1990年1月1日至2018年11月30日),同时在CNKI采用“智能导师系统”“智能辅导”“智能教学系统”等关键词进行检索。另一方面,通过相关研究的参考文献进行回溯倒查(VanLehn, 2011; Steenbergen-Hu & Cooper, 2013; Kulik & Fletcher, 2016),对在学校应用较为广泛的ITSs产品进行专题搜索(如Cognitive Tutor、AutoTutor、WWC等)。最后,做初步数据处理,剔除软件开发报告、满意度调查、技术优化研究等不相关文献,最后总共产生了489篇可供进一步分析的候选文献。

2. 文献筛选

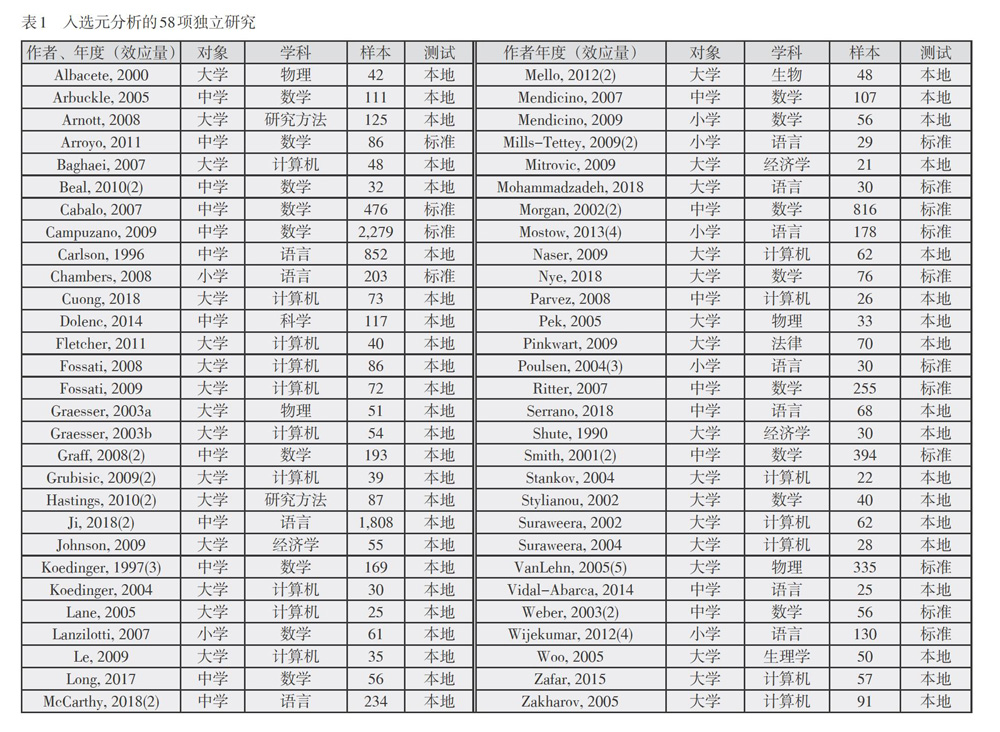

在粗略考察了小部分候选样本之后,制定了一份文献筛选标准,入选的候选文献必须满足这些条件:①采用实验或准实验设计,有对照组与实验组,且汇报了两组前测无显著差异,单组实验或未报告前测无显著差异的不予纳入。②实验组必须接受了智能导学系统的干预实践。如今计算机辅助教学系统层出不穷,对于智能导师系统概念的准确理解非常关键。CAI与ITSs的主要区别在于:前者只提供固定的机械性交互反馈,而后者能在学习过程中提供颗粒更精细的自适应反馈。同时,根据范莱恩(VanLehn, 2006)提出的ITSs包含外循环(outer loop)和内循环(inner loop)的反馈机制进行识别。③对照组接受了相同内容的常规教与学,但不能接受其他类型的计算机辅助教学或人类单独辅导等。④实验组与对照组都测量了知识、技能等学业目标,可以是卷面测试、现场技能评估、真实任务迁移等,但满意度、情感目标的测量结果不被接受。⑤被试群体是具有正常需求的学习群体,剔除有身心障碍、学习障碍的相关研究,但知识与能力基础有差异的相关研究是可接受的。⑥文献报告了必要的数据资料,可用于计算相应的效应量(Effect size)。最后从候选文献中遴选出58个符合标准的独立研究,可供分析的效应量达83个,其中部分独立研究提供了多个效应量,如表1所示(“作者”列括号中的数字表示所提供的效应量个数)。

入选分析的58份独立研究都是英文文献,最早的是在1990年,实验群体涵盖小学、中学、大学。总体上来说,代表性强、严谨性程度高:①入选研究的总样本达到10,764,而样本量最大是2,279,最小样本量为21;②在教育层次上,大学占比超过一半(53.45%),小学最少(12.07%);③在学科应用上,计算机(29.31%)、数学(29.31%)和语言(18.97%)是主力军,还涉及物理、经济学、心理研究方法、生物、法律等其他学科。

(二)特征编码

为分析特征变量对效应量的影响,在多轮考察部分入选文献的特征之后,研制了一份涵盖10个变量的研究特征编码表(如表2所示)。最初将这些内容详细记录,再将观察结果重新编码为有序的类别变量。

为何这样设计编码方式?首先,在实验时间上WWC建立了针对教育实证研究的接纳标准,而使用最为广泛的认知辅导系统从2007年开始有符合严格标准的干预研究,考虑到研究周期,特将2004年作为初始分类年份;其次,元分析注重发布偏倚的考察,在出版类型上作了正式出版(期刊/会议/书籍章节)与未正式出版(项目报告/学位论文/未发表手稿)的区分;最后,在标准化测试中使用的是权威机构研制的具有高信效度的测试内容,而本地自行测试是研究者自行设计的相关考试,在相关研究中发现了测试类型对效应量的显著调节作用(Kulik & Fletcher, 2016)。

(三)效应量计算方法

本研究采用综合元分析软件(Comprehensive Meta-Analysis 3.0)作为主要的数据处理与分析工具,将来自不同独立研究的原始数据进行合并,按照赫杰斯和奥利金(Hedges & Olkin, 1985)提出的标准化均差(Standardized Mean Difference, SMD)公式计算每个效应量,再依次计算合并后的平均效应量和分组效应量,每个效应量的计算数据需要至少包括双组实验的样本(N)、后测均值(Mean)和后测标准差(SD),而后结合SPSS软件将效应量与特征编码进行统计分析,了解研究特征对效应量的具体影响。

四、结果检验与分析

(一)发表偏倚检验

当所入选的实证研究样本无法代表可能存在的全体实证研究时就会发生发表偏倚。因此,在计算效应量之前,需要对是否存在发表偏倚进行估计和检验。通常使用的发表偏倚检验方法包括漏斗图法、Begg秩相关法和失安全系数(Fail-safe)等(李玉, 等, 2018)。本研究的漏斗图检验结果如图1,大部分研究分布在中线左右,整体呈漏斗形,但左边偏少一些且靠近底部有部分散点(标准误较大),可能会发生一定程度的偏倚。漏斗图只能按照定性的方式来表征结果,在判断时具有很大的主观性(Greenland, 1994),而且入选研究中已经囊括了部分非正式發表的手稿,因此需要进一步检验。Begg秩相关性通过分析效应与标准误是否相关来检验偏倚,发现其相关性(Tau)为0.123,且不显著(p=0.09),若将非正式发表的文献剔除,则相关性更低(Tau=0.03, p=0.64),说明不存在发表偏倚。失安全系数方法检验是为了排除存在偏倚的可能,计算最少需要多少个消极结果的研究才能使本结论发生逆转,失安全系数越大,说明存在偏倚的可能性越小。本研究发现其失安全系数为9806,远超过“5N+10”(N=83),说明发表偏倚的可能性很小。整体上考虑,存在发表偏倚的可能性很小。

(二)基本统计分析

数据样本执行效应量计算后发现,83个独立效应量中有75个(90.36%)实验组的后测成绩显著高于对照组。根据科恩(Cohen, 1992)效应量统计理论,效应量处在0.2时说明影响很小,处在0.5时说明是中等程度的影响,而达到0.8时表示影响显著,本研究发现超过一半(42项)的效应量达到0.5以上。因此,绝大部分研究表明智能导师系统能积极提升学业成就,而且半数研究达到了中等以上程度的正向影响。

(三)平均效应量计算

为更准确地表征智能导师系统对学业成就的影响,计算了其平均效应量,如表3所示,Q值检验显著(p<0.001)且I2明显高于50%,说明入选元分析的独立研究存在明显的异质性,宜采纳随机效应模型作为合并效应量的计算模型。因此,本研究的平均效应量为0.492,95%置信区间的效应量为0.408~0.577(p<0.000),表明智能导师系统对学业成就具有中等的正向作用,平均效应量处在0.408~0.577。

(四)影响效应量的特征因素

尽管平均效应量处于中等水平,但是在一些研究中效应量非常大而其他研究中效应量比较小,存在异质性。为弄清影响效应量的特征因素,研究分别对学生特征、发表特征和研究设计进行了效应量的分组分析及线性回归分析。

1. 学生特征对实验效应的影响

探究学生的国家属地、知识基础水平和教育层次对实验效应的影响。按照上述异质性检验方法(后续均按照该方法选择相应效应模型),发现这三个因素应该分别使用随机效应模型、固定效应模型和随机效应模型,如表4所示。在发展中国家和发达国家维度,智能导师系统均能显著提升学生学业成就。在发展中国家(g=0.777)的实验效果似乎高于发达国家(0.465),但在相应的随机效应模型中并未达到显著水平(p>0.05)。不管是知识基础一般,还是基础较差的学生,智能导师系统均显示出显著的积极影响,而且基础较差的学生(g=0.568)与基础普通的学生(g=0.291)比较,具有显著的差异(p<0.05),前者的平均效应量几乎是后者的两倍。对于所有教育层次的学生来说,智能导师系统都具有显著的积极作用,而且层次之间具有显著差异(p<0.05),对大学生、小学生的影响更大,对中学生的影响更小。因此,智能导师系统对于不同学生都具有显著的正向影响,而且对知识基础较低、大学生具有更为显著的积极影响。

2. 发表特征对实验效应的影响

为考察文献的发表特征对效应量的影响,研究从实施时间与发表类型上进行了效应量的分组计算,结果如表5所示。各年度区间的实验效果都具有显著的正向作用,虽然2005年至2011年看似效应量更高,但并未达到显著水平,即实验时间对效应量的变异并无实际影响。不同发表类型的文献都具有显著的正向提升作用,尽管正式发表类型(期刊、会议和书籍)文献的效应量较高,但与非正式发表类型的差异并不显著。

3. 研究设计对实验效应的影响

研究设计往往是影响实验效果的重要因素,研究从样本量、学科、应用产品、持续时间、测试类型等五个方面进行考察,如表6所示。在各个样本量区间,ITSs都显示出了显著的正向促进作用,而且组间存在显著的差异性,样本量越大,效应量越小,样本量低于200时效应量变化不大,而高于200之后效应量锐减至一半。在学科分类上,ITSs对理工科与文科都产生了显著的积极效应,但理工科的效应量显著高于文科。针对两类产品的实验都产生了积极的促进作用,但其他产品与认知辅导系统的影响成效上有显著的差异,前者是后者的三倍。无论实验持续时间的长短都具有正向的促进作用,但不同的持续时间具有显著的差异,短期(小于1周)与长期(超过15周)的实验效应都不如中期(1周~15周)好。不同的测试类型都具有显著的积极效应,但本地自行测试要显著优于标准化考试,前者的效应量超过后者的两倍。

4. 对平均效应量的调节影响分析

按照上述分析结果,在所有特征层面ITSs对学业成就都具有正向的显著提升作用,而且部分学生特征(如知识基础水平和教育层次)与研究设计特征(学科、产品、样本量、持续时间和测试类型)表现出了组间效应量的显著差异,但这些特征对平均效应量是否有调节影响还有待进一步验证,因为各类特征之间可能存在相关性。为此,研究结合线性回归分析方法驗证上述特征对于平均效应量变异的影响,拟合效果较好的是一个涵盖三个自变量的模型,如表7所示。

有显著调节作用的是测试类型、持续时间和样本量三个特征,虽然对平均效应量的变异解释程度并不高(R2=22.7%),但对平均效应量的变异具有显著的调节作用,依据其作用大小,依次为测试类型(-0.467)、持续时间(0.356)与样本量(-0.191),说明本地测试、较长实验时间、更小样本量会获得更大的效应量(此处使用的样本量为真实数量,未使用编码后的有序分类变量)。不同的知识基础、教育层次、学科和产品都有显著的效应量差异,却为何并没有对平均效应量变异产生显著影响?研究分析了这三个因素与其他因素之间的相关性,发现产品类型分别与测试类型、样本量和持续时间存在显著的相关性;教育层次分别与测试类型和样本量存在显著的相关性,知识基础水平又与教育层次存在显著的相关性;学科也与产品类型存在显著的相关性。可以认为,不同知识基础、教育层次、学科与产品之所以会产生显著的效应量差异,其背后实质上是这三个调节变量在起作用,如选用认知辅导系统的实验设计基本上都采纳大样本(80%)、标准化测试(90%)、中长期实验(超过15周的占70%),导致认知辅导系统产品的效应量较低。因此,可以认为,只有测试类型、持续时间与样本量才是显著调节平均效应量的关键特征。

五、总结与讨论

本研究通过对国外58项关于智能导师系统提升学业成就的独立实证研究进行了量化元分析,主要从发表偏倚检验、平均效应量的效应量的调节特征等方面进行了分析。

(一)智能导师系统对学业成就具有中等的正向促进作用

智能导师系统与学业成就之间呈显著的积极相关,超过九成的独立研究都发现了显著的正向促进效应,合并后的平均效应量达到0.492,即能将第50个百分位的学生提高至第68个百分位,且95%研究的效应量处在0.408与0.577之间。这与玛等人(Ma, et al., 2014)的研究结论一致,但与其他元分析(VanLehn, 2011; Kulik & Fletcher, 2016; WWC, 2016; Steenbergen-Hu & Cooper, 2013)的结果有较小的差异。范莱恩(VanLehn, 2011)区别了按步辅导(Step-based tutoring)与按分步辅导(Substep-based tutoring)等两类智能导师系统,前者为单个问题提供一个总体线索与解释,而后者则提供更精细的脚手架,将解决一个问题的相关提示细化为多个微提示,按照多个分步骤依次反馈。其中,按步辅导提高了0.76个标准差,而按分步辅导提高了0.4个标准差,而本研究并未加以区分,本研究效应量处在两者之间是合理的。在库里克与弗莱彻(Kulik & Fletcher, 2016)的研究中,通过本地测试获取的效应量占比是82%,明显高于本研究的66%,根据测试类型的调节作用可推断,其效应量比本研究高一些就不奇怪了。美国教育部有效教育策略资料中心(WWC, 2016)考察了认知辅导系统大规模应用的有效性,其中测试类型都是标准化考试。本研究发现大样本和标准化考试都对效应量具有显著的消极调节作用。因此,其结果明显低于本研究。至于斯滕贝格·胡与库珀(Steenbergen-Hu & Cooper, 2013)的效应量更低的原因,库里克与弗莱彻(Kulik & Fletcher, 2016)给出了相应解释,因为他们将智能导师系统的概念宽泛化(包括了部分CAI),纳入标准要求低,部分研究甚至没有恰当对照组、无双组前测等,这些解释在本研究中同样适用。所以,0.5左右的效应量比较符合研究现实。

(二)测试类型、持续时间与样本量对平均效应量具有显著调节作用

在所有特征类型上,ITSs对学业成就提升都具有显著的积极效应,而且知识基础、教育层次、学科、产品、样本量、持续时间和测试类型七个特征对相应的效应量均有显著影响。经过线性回归分析发现:测试类型、实验持续时间与样本量对平均效应量具有显著的调节作用。

测试类型对平均效应量具有显著的调节作用,在之前研究(Rosenshine & Meister, 1994; Koedinger, et al., 1997; 刘珊珊, 杨向东, 2015; Kulik & Fletcher, 2016)中均有此发现。在本地开发的测试中发现了更积极的效应,因为这类测试内容与教学目标和学习内容更为一致,而标准化测试题目经常是第三方开发的,考察内容更为宽泛但信效度更高,当然这两种测试类型都具有相应的参考价值,同时纳入两者可能更具有客观意义。

不同实验持续时间对平均效应量的影响都是积极、显著的,但实验持续的时间越长,智能导师系统越能提升学业成就,其背后可能是学生的技术接受程度、教师的实施充分性、组织干预的娴熟程度、教学策略的恰当性等多方面的综合优化。纳泽(Naser, 2009)在小型实验中发现,第二阶段比第一阶段的实验效应量要高出0.65。潘恩等人(Pane, et al., 2013)在大规模干预中也发现了类似的显著差异,第一年实验的平均效应量是-0.06,而第二年另一批学生的平均效应量是0.20,且达到显著的积极影响。此外,部分其他相关研究(Koedinger & Anderson, 1993; VanLehn, et al., 2005; Le, et al., 2009)中也有类似的发现。

不同样本量对效应量的影响也都是积极显著的。然而,样本量越大,平均效应量却显著地减少,尤其是以200作为样本量的临界点,斯滕贝格·胡与库珀(Steenbergen-Hu & Cooper, 2013)也发现了类似的样本临界点效应。样本量超过200以后,一个教师同时在不同班级授课这个重要实验条件一般是很难得到保证的,可能会对实验结果有所影响。

六、建议与展望

本研究的数据涵盖了28年间各教育层面在多个学科领域执行的58项独立实证研究,发现智能导师系統对学业成就提升的平均效应量为0.492,95%处于0.408至0.577之间,具有中等的正向促进作用,与其他相关元分析取得了较为一致的结果。此外,本研究提取了对平均效应量变异影响较大的三个因素,但总体上的解释程度比较有限,可能是由于对研究条件的考虑不够充分,包括教师能力水平、学生技术娴熟程度、智能导师系统的技术功能、学习目标分类、教学法等。因此,一方面,继续增加与跟踪对智能导师系统、自适应学习系统等先进辅导技术的实证考察,扩大实验研究规模与影响。特别是国内教育技术领域在实验研究上尚未形成主流,如针对智能导师系统就未发现一例符合要求的实验或准实验。如今在教育信息化事业大发展的背景下教育技术学科建设却有式微的风险,将循证作为学科建设的核心研究方法之一,会显著提升学科的科学性,在国家教育信息化事业发展中增加独特的“实证”话语权,在教育现代化进程中发挥指向性、引领性与变革性的突出作用。另一方面,规范教育技术的实证研究方法,增强研究设计的严谨性,形成完整、高质量的研究证据链,让政策制定者与教育实践者知道“某项教育技术在什么情况下能达到怎么样的提升成效”。前文提到的美国教育部有效教育策略资料中心(WWC, 2017)建立了实证教育研究的干预规范、报告标准及其实践指南,为研究者、教育者、政策制定者与学习者提供了一个可持续发展的证据积累框架,值得借鉴。

虽然ITSs比CAI的效应量并没有高出多少,但为当下智能化、精准化的自适应学习系统的发展与应用前景提供了坚实的证据基础。随着深度学习、语音识别、大数据等技术的不断发展,智能化将引发教与学发生更加深刻的变革(王珠珠, 2018)。期待在新一代人工智能支持下的自适应学习系统能对学业成就产生“两个西格玛”的改进效应,让孔子古老的因材施教的理想插上教育技术的翅膀,真正实现大规模的公平而优质的个性化学习。

[参考文献]

(*表示入选元分析的独立实证研究)

李佳丽. 2017. 不同类型影子教育对小学生学业成绩的影响——及其对教育不均等的启示[J]. 教育科学(5):16-25.

李玉,柴阳丽,闫寒冰. 2018. 思维导图对学生学业成就的影响效应——近十年国际思维导图教育应用的元分析[J]. 中国远程教育(1):16-27,28.

刘珊珊,杨向东. 2015. 课外辅导对学生学业成绩影响效应的元分析[J]. 教育发展研究(22):55-64.

潘云鹤. 2018. 人工智能2.0与教育的发展[J]. 中国远程教育(5):7-10,46,81.

王珠珠. 2018 . 教育信息化2.0:核心要义与实施建议[J]. 中国远程教育(7):5-8.

张志祯,张玲玲,罗琼菱子,郑葳. 2019. 人工智能教育应用的实然分析:教学自动化的方法与限度[J]. 中国远程教育(3):1-13,92.

*Albacete, P. L., & Vanlehn, K. A. (2000). Evaluating the Effectiveness of a Cognitive Tutor for Fundamental Physics Concepts. Proceedings of the 22nd Annual Meeting of the Cognitive Science Society, 25-30.

Anderson, J. R., Corbett, A. T., Koedinger, K. R., & Pelletier, R. (1995). Cognitive tutors: lessons learned. Journal of the Learning Sciences, 4(2), 167-207.

*Arbuckle, W. J. (2005). Conceptual understanding in a computer assisted Algebra I classroom. ProQuest Dissertations Publishing, University of Oklahoma, Norman.

*Arnott, E., Hastings, P., & Allbritton, D. (2008). Research methods tutor: evaluation of a dialogue-based tutoring system in the classroom. Behavior Research Methods, 40(3), 694-698.

*Arroyo, I., Royer, J. M., & Woolf, B. P. (2011). Using an intelligent tutor and math fluency training to improve math performance. International Journal of Artificial Intelligence in Education, 21(1), 135-152.

*Baghaei, N., Mitrovic, A., & Irwin, W. (2007). Supporting collaborative learning and problem-solving in a constraint-based CSCL environment for UML class diagrams. International Journal of Computer-Supported Collaborative Learning, 2(2), 159-190.

Bayraktar, S. (2001). A Meta-analysis of the Effectiveness of Computer-Assisted Instruction in Science Education, Journal of Research on Technology in Education, 34(2), 173-188.

*Beal, C. R., Arroyo, I. M., Cohen, P. R., & Woolf, B. P. (2010). Evaluation of animal watch: an intelligent tutoring system for arithmetic and fractions. Journal of Interactive Online Learning, 9(1), 64-77.

Blok, H., Oostdam, R., Otter, M. E., & Overmaat, M. (2002). Computer-assisted instruction in support of beginning reading instruction: a review. Review of Educational Research, 72(1), 101-130.

Bloom, B. S. (1984). The 2 sigma problem: The search for methods of group instruction as effective as one-to-one tutoring. Educational Researcher, 13(6), 4-16.

Burns, P. (1981). A quantitative synthesis of research findings relative to the pedagogical effectiveness of computer-assisted instruction in elementary and secondary schools. Dissertation Abstracts International, 42, 2946A.

*Cabalo, J. V., Jaciw, A., & Vu, M. (2007). Comparative effectiveness of Carnegie Learnings Cognitive Tutor Algebra I curriculum: A report of a randomized experiment in the Maui School District. Palo Alto, CA: Empirical Education, Inc.

*Campuzano, L., Dynarski, M., Agodini, R., & Rall, K. (2009). Effectiveness of reading and mathematics software products: Findings from two student cohorts. Washington, DC: U.S. Department of Education, Institute of Education Sciences.

*Carlson, P. A., & Miller, T. M. (1996). Beyond word processing: Using an interactive learning environment to teach writing. Brooks AFB, TX: Human Resources Directorate, Technical Training Research Division.

*Chambers, B., Abrami, P., Tucker, B., Slavin, R. E., Madden, N. A., & Cheung, A., et al. (2008). Computer-assisted tutoring in success for all: reading outcomes for first graders. Journal of Research on Educational Effectiveness, 1(2), 120-137.

Cohen, P. A., Kulik, J. A., & Kulik, C. L. C. (1982). Educational outcomes of tutoring: A meta-analysis of findings. American Educational Research Journal, 19(2), 237–248.

Cohen, J. (1992). A power primer. Psychological Bulletin, 112(1): 155-159.

*Dolenc, K., & Abersek, B. (2015). TECH8 intelligent and adaptive e-learning system: Integration into Technology and Science classrooms in lower secondary schools. Computers & Education, 82, 354-365.

*Fletcher, J. D. (2011). DARPA Education Dominance Program: April 2010 and November 2010 Digital Tutor assessments. Alexandria, VA: Institute for Defense Analysis.

*Fossati, D., Eugenio, B. D., Brown, C., & Ohlsson, S. (2008). Learning Linked Lists: Experiments with the iList System. International Conference on Intelligent Tutoring Systems, 5091, 80-89.

*Fossati, D., Di Eugenio, B., Ohlsson, S., Brown, C., Chen, L., & Cosejo, D. (2009). I learn from you, you learn from me: How to make iList learn from students. In: Dimitrova, V., Mizoguchi, R., Du Boulay, B., & Graesser, A. (Eds.), Proceedings of The 14th International Conference on Artificial Intelligence in Education (pp.186-195) IOS Press, Brighton.

Glass, G. V., McGaw, B., & Smith, M. L. (1981). Meta-analysis in social research. Beverly Hills, CA: Sage.

*Graesser, A. C., Jackson, G. T., Mathews, E. C., Mitchell, H. H., Olney, A., Ventura, M., & Chipman, P. (2003a). Why/AutoTutor: A test of learning gains from a physics tutor with natural language dialog. Proceedings of the Twenty Fifth Annual Conference of the Cognitive Science Society, 1-6.

*Graesser, A. C., Moreno, K., Marineau, J., Adcock, A., Olney, A., Person, N., & the Tutoring Research Group (2003b). AutoTutor improves deep learning of computer literacy: Is it the dialogue or the talking head? Proceedings of artificial intelligence in education, 47-54.

*Graff, M., Mayer, P., & Lebens, M. (2008). Evaluating a web based intelligent tutoring system for mathematics at German lower secondary schools. Education and Information Technologies, 13(3), 221-230.

Greenland, S. (1994). Invited commentary: a critical look at some popular meta-analytic methods. Am J Epidemiol, 140(3), 290-296.

*Grubi?ic, A., Stankov, S., Rosic, M., & ?itko, B. (2009). Controlled experiment replication in evaluation of e-learning systems educational influence. Computers & Education, 53, 591-602.

*Hastings, P., Arnott-Hill, E., & Allbritton, D. (2010). Squeezing out gaming behavior in a dialog-based ITS. In V. Aleven, H. Kay, & J. Mostow (Eds.), Intelligent tutoring systems (pp. 204-213), Berlin, Germany: Springer-Verlag.

Hedges, L. V., & Olkin, I. (1985). Statistical methods for meta-analysis. New York, NY: Academic Press.

Ji, X. R., Beerwinkle, A., Wijekumar, K. K., Lei, P., Malatesha Joshi, R., & Zhang, S. (2018). Using latent transition analysis to identify effects of an intelligent tutoring system on reading comprehension of seventh-grade students. Reading and Writing, 31(9), 2095-2113.

*Johnson, B. G., Phillips, F., & Chase, L. G. (2009). An intelligent tutoring system for the accounting cycle: enhancing textbook homework with artificial intelligence. Journal of Accounting Education, 27(1), 30-39.

Koedinger, K. R., & Anderson, J. R. (1993). Effective use of intelligent software in high school math classrooms. Proceedings of the World Conference on AI in Education, 1993, 241-248.

*Koedinger, K. R., Aleven, V., Heffernan, N., Mclaren, B., & Hockenberry, M. (2004). Opening the Door to Non-programmers: Authoring Intelligent Tutor Behavior by Demonstration. Intelligent Tutoring Systems. Springer Berlin Heidelberg.

*Koedinger, K. R., Anderson, J. R., Hadley, W. H., & Mark, M. A. (1997). Intelligent tutoring goes to school in the big city. International Journal of Artificial Intelligence in Education, 8(1), 30-43.

Kroesbergen, E. H., & Van Luit, J. E. H. (2003). Mathematics interventions for children with special educational needs: a meta-analysis. Remedial and Special Education, 24(2), 97-114.

Kulik, J. A., & Fletcher, J. D. (2016). Effectiveness of intelligent tutoring systems: a meta-analytic review. Review of Educational Research, 86(1), 42-78

Kulik, C. C., & Kulik, J. A. (1991). Effectiveness of computer-based instruction: An updated analysis. Computers in Human Behavior, 7, 75-94.

Kulik, J. A. (1994). Meta-analytic studies of findings on computer-based instruction. In E. L. Baker & H. F. ONeil Jr. (Eds.), Technology assessment in education and training (pp. 9-33), Hillsdale, NJ: Erlbaum.

Kulik, J. A. (2002). School mathematics and science programs benefit from instruction technology (Info Brief NSF 03-301). Washington, DC: National Science Foundation.

*Lane, H. C., & VanLehn, K. (2005). Teaching the tacit knowledge of programming to novices with natural language tutoring. Computer Science Education, 15(3), 183-201.

*Lanzilotti, R., & Roselli, T. (2007). An experimental evaluation of logiocando, an intelligent tutoring hypermedia system. International Journal of Artificial Intelligence in Education, 17(1), 41-56.

*Le, N. T., Menzel, W., & Pinkwart, N. (2009). Evaluation of a constraint-based homework assistance system for logic programming. Proceedings of the 6th International Conference on Web-based Learning, Edinburgh, UK, 367-379.

*Long, Y., & Aleven, V. (2017). Enhancing learning outcomes through self-regulated learning support with an open learner model. User Modeling and User-Adapted Interaction, 27(1), 55-88.

Ma, W., Adesope, O. O., Nesbit, J. C., & Liu, Q. (2014). Intelligent tutoring systems and learning outcomes: A meta-analysis. Journal of Educational Psychology, 106(4), 901-918.

*McCarthy, K. S., Likens, A. D., Johnson, A. M., Guerrero, T. A., & Mcnamara, D. S. (2018). Metacognitive overload: positive and negative effects of metacognitive prompts in an intelligent tutoring system. International Journal of Artificial Intelligence in Education, 28(3), 420-438.

*Mello, S., Olney, A., Williams, C., & Hays, P. (2012). Gaze tutor: a gaze-reactive intelligent tutoring system. International Journal of Human-Computer Studies, 70(5), 377-398.

*Mendicino, M., & Heffernan, N. (2007). Comparing the learning from intelligent tutoring systems, non-intelligent computer-based versions, and traditional classroom instruction. ProQuest Dissertations Publishing, West Virginia University, Morgantown.

*Mendicino, M., Razzaq, L., & Heffernan, N. T. (2009). A comparison of traditional homework to computer-supported homework. Journal of Research on Technology in Education, 41(3), 331-359.

*Mills-Tettey, G. A., Mostow, J., Dias, M. B., Sweet, T. M., Belousov, S. M., & Dias, M. F., et al. (2009). Improving child literacy in Africa: experiments with an automated reading tutor. International Conference on Information and Communication Technologies and Development, 6, 129-138.

*Mitrovic, A., Martin, B., Suraweera, P., Zakharov, K., Milik, N., & Holland, J. (2009). Aspire: an authoring system and deployment environment for constraint-based tutors. International Journal of Artificial Intelligence in Education, 19(2), 155-188.

*Mohammadzadeh, A., & Sarkhosh, M. (2018). The Effects of Self-Regulatory Learning through Computer-Assisted Intelligent Tutoring System on the Improvement of EFL Learner Speaking Ability. International Journal of Instruction, 11(2), 167-184.

*Morgan, P., & Ritter, S. (2002). An experimental study of the effects of Cognitive Tutor Alegbra I on student knowledge and attitude. Available from Carnegie Learning, Inc.

*Mostow, J., Nelson-Taylor, J., & Beck, J. E. (2013). Computer-guided oral reading versus independent practice: comparison of sustained silent reading to an automated reading tutor that listens. Journal of Educational Computing Research, 49(2), 249-276.

*Naser, S. (2009). Evaluating the effectiveness of the CPP-Tutor, an intelligent tutoring system for students learning to program in C++. Journal of Applied Sciences Research, 5(1), 109-114.

*Nguyen, D. H. C., Arch-Int, N., & Arch-Int, S. (2018). FUSE: A Fuzzy-Semantic Framework for Personalizing Learning Recommendations. International Journal of Information Technology & Decision Making, 17(4), 1173-1201.

*Nye, B. D., Pavlik, P. I., Windsor, A., Olney, A. M., Hajeer, M., & Hu, X. (2018). Skope-IT: overlaying natural language tutoring on an adaptive learning system for mathematics. International Journal of STEM Education, 5(1), 1-20.

Pane, J. F., Griffin, B. A., McCaffrey, D. F., & Karam, R. (2013). Effectiveness of cognitive tutor algebra I at scale. Educational Evaluation and Policy Analysis, 36(2), 127-144.

*Parvez, S. M. (2008). A pedagogical framework for integrating individual learning style into an intelligent tutoring system. [Unpublished manuscript], Lehigh University, Bethlehem.

*Pek, P. K., & Poh, K. L. (2005). Making decisions in an intelligent tutoring system. International Journal of Information Technology & Decision Making, 4(02), 207-233.

*Pinkwart, N., Ashley, K., Lynch, C., & Aleven, V. (2009). Evaluating an intelligent tutoring system for making legal arguments with hypotheticals. International Journal of Artificial Intelligence in Education, 19(4), 401-424.

*Poulsen, R. (2004). Tutoring bilingual students with an automated reading tutor that listens: results of a two-month pilot study. Journal of Educational Computing Research, 36(2), 191-221.

Ritter, G. W., Barnett, J. H., Denny, G. S., & Albin, G. R. (2009). The effectiveness of volunteer tutoring programs for elementary and middle school students: A meta-analysis. Review of Educational Research, 79(1), 3-38.

*Ritter, S., Kulikowich, J., Lei, P. W., Mcguire, C. L., & Morgan, P. (2007). What Evidence Matters? A randomized field trial of Cognitive Tutor Algebra I. International Conference on Supporting Learning Flow Through Integrative Technologies, 13-20.

Rosenshine, B., & Meister, C. (1994). Reciprocal teaching: A review of the research. Review of Educational Research, 64(4), 479–530.

*Serrano, M. A., Vidal-Abarca, E., & Ferrer, A. (2018). Teaching self-regulation strategies via an intelligent tutoring system (TuinLECweb): Effects for low-skilled comprehenders. Journal of Computer Assisted Learning, 34(5), 515-525.

*Shute, V. J., & Glaser, R. (1990). A large-scale evaluation of an intelligent discovery world: Smithtown. Interactive Learning Environments, 1(1), 51-77.

*Smith, J. E. (2001). The effect of the Carnegie Algebra Tutor on student achievement and attitude in introductory high school algebra. ProQuest Dissertations Publishing, Virginia Polytechnic Institute and State University, Blacksburg.

Sosa, G. W., Berger, D. E., Saw, A. T., & Mary, J. C. (2011). Effectiveness of computer-assisted instruction in statistics: A meta-analysis. Review of Educational Research, 81(1), 97-127.

*Stankov, S., Glavinic, V., & Grubi?ic, A. (2004). What is our effect size: Evaluating the educational influence of a web-based intelligent authoring shell? Eighth IEEE International Conference on Intelligent Engineering Systems. 545-550.

Steenbergen-Hu, S., & Cooper, H. (2013). A meta-analysis of the effectiveness of intelligent tutoring systems on K-12 students mathematical learning. Journal of Educational Psychology, 105(4), 970–987.

Steenbergen-Hu, S., & Cooper, H. (2014). A meta-analysis of the effectiveness of intelligent tutoring systems on college students academic learning. Journal of Educational Psychology, 106(2), 331-347.

*Stylianou, D.A. & Shapiro, L. (2002). Revitalizing Algebra: the effect of the use of a cognitive tutor in a remedial course, Journal of Educational Media, 27(3), 147-171.

*Suraweera, P., & Mitrovic, A. (2002). KERMIT: A constraint-based tutor for database modeling. 6th International Conference of ITSs, 377-387.

*Suraweera, P., & Mitrovic, A. (2004). An Intelligent Tutoring System for Entity Relationship Modelling. International Journal of Artificial Intelligence in Education archive, 14, 375-417.

Tamim, R. M., Bernard, R. M., Borokhovski, E., Abrami, P. C., & Schmid, R. F. (2011). What forty years of research says about the impact of technology on learning a second-order meta-analysis and validation study. Review of Educational Research, 81(1), 4-28.

VanLehn, K. (2006). The behavior of tutoring systems. International Journal of Artificial Intelligence in Education, 16(3): 227-265.

VanLehn, K. (2011). The relative effectiveness of human tutoring, intelligent tutoring systems, and other tutoring systems. Educational Psychologist, 46(4), 197-221.

*Vanlehn, K., Lynch, C., Schulze, K., Shapiro, J. A., Shelby, R., & Taylor, L., et al. (2005). The Andes physics tutoring system: five years of evaluations. International Journal of Artificial Intelligence in Education, 15(3), 147-204.

*Vidal-Abarca, & E., Gilabert, R., et al. (2014). TuinLEC, an intelligent tutoring system to improve reading literacy skills. Journal for the Study of Education and Development, 37(1), 25-56.

*Weber, W.A. (2003, August 10). An Evaluation of the Reasoning Mind Program at Hogg Middle School. Retrieved December 23, 2018, from http://www.reasoningmind.org/wp-content/uploads/2013/11/2003_Pilot_Independent_Evaluation.pdf

What Works Clearinghouse. (2016). WWC Intervention Report for Cognitive Tutor. Retrieved December 12, 2018, from http://ies.ed.gov/ncee/wwc/Intervention/818

What Works Clearinghouse. (2017). WWC Version 4.0 Standards Handbook. Retrieved December 20, 2018, http://ies.ed.gov/ncee/wwc/multimedia/40

*Wijekumar, K. K., Meyer, B. J., & Lei, P. (2012). Large-scale randomized controlled trial with 4th graders using intelligent tutoring of the structure strategy to improve nonfiction reading comprehension. Educational Technology Research and Development, 60(6), 987-1013.

*Woo, C. W., Evens, M. W., Freedman, R., Glass, M., Shim, L. S., & Zhang, Y., et al. (2006). An intelligent tutoring system that generates a natural language dialogue using dynamic multi-level planning. Artificial Intelligence in Medicine, 38(1), 25-46.

Woolf, B. P. (2009). Building intelligent interactive tutors: student-centered strategies for revolutionizing e-learning. Telearn, 59(5), 337-379.

*Zafar, A., & Albidewi, I. (2015). Evaluation study of eLGuide: a framework for adaptive e-learning. Computer Applications in Engineering Education, 23(4), 542-555.

*Zakharov, K., Mitrovic, & A., Ohlsson, S. (2005). Feedback Micro-engineering in EER-Tutor. International Conference on Artificial Intelligence in Education, IOS Press, 718-725.

責任编辑 韩世梅