在线学习测评技术的价值、理论和应用审视

葛文双 韩锡斌 何聚厚

摘要:随着人才培养理念的转变和新型在线学习形式的涌现,传统的知识本位测评已难以满足社会发展对人才评价的需要,注重规模化、智能化、个性化的在线学习测评技术受到广泛关注。通过对学习成果认证的类型划分及演变过程的剖析可以看出,在线学习测评技术正在从注重时间固定的知识掌握型学习成果认证向关注时间灵活的能力发展型学习成果认证转变,深度学习成为其发展的价值导向。从在线学习测评技术的理论基础来看,知识本位的掌握度测评主要依托基于行为主义的程序教学理论,而能力本位的发展性测评则依托认知主义和建构主义学习理论。上述教学和学习理论与信息技术的结合,使得自动测试与实时反馈、同伴互评、基于学习分析的测评、数字徽章等在线学习测评技术应用模式被广泛采纳。在线学习测评技术的发展使得学习更加开放与多元,但仍存在测评系统不够智能、测评数据不够安全等问题。同时,教师在运用测评数据开展有效教学设计、监控学习过程、进行教学反思等方面的能力亦有待提升。重新认识学习测评的角色,并通过测评为学习者提供更加个性化的学习服务支持,是未来在线学习测评技术的发展方向和价值追求。

关键词:在线学习;测评技术;学习成果认证;学习分析;应用模式

中图分类号:G434? ?文献标识码:A? ? 文章编号:1009-5195(2019)06-0052-10? doi10.3969/j.issn.1009-5195.2019.06.006

一、引言

长久以来,在以学校教育为主的学历、学位认证中,考试作为一种富有成效的测评方式被广泛运用。随着技术的不断发展和在线教育的日益普及,如何促使在线测评与传统测评方式一样有效,成为重要的研究话题。一时间,各种针对上机考试和在线考试的研究成为热点,但由于其采用的测评理论主要是针对知识传授型教学模式而构建的,因而这些研究更多被视为是对原有测评手段或方式的技术强化。进入21世纪,随着社会对人才技能与个体发展的日益关注,教育更注重对沟通交流能力、问题解决能力、批判性思维和全球化胜任力的培养。经济合作与发展组织在其近期发布的《教育与技能的未来:教育2030》(The Future of Education and Skills: Education 2030)中,提出要关注面向终身学习、全人教育的未来学习能力建设(OECD,2018)。一方面,这种发生在人才评价本质层面上的改变,让面向传统学习方式的测评体系难以有效应对;另一方面,互联网技术所催生的MOOCs、Micro-Lecture、Flipped Learning等新型学习方式,也促使针对在线学习测评的研究再度受到关注。当前,在线学习测评技术研究更关注教学过程中的实现问题,主要聚焦于测评的规模化、智能化等相关话题,缺少思维变革主导下的系统性创新。因此,本研究从技术驱动的学习成果认证分类与发展的视角来诠释在线学习测评技术的重要价值,并从其研究的理论框架、应用模式及面临的挑战来展开系统分析。

二、基于学习成果认证分类的价值分析

“互联网+”时代的技术进步促使教育环境发生了显著变化,在线学习变得越来越普遍,正式与非正式情境下的学习研究也日益受到关注。作为知识与文化传承重要途径的学校一直以教学时间和场所相对固定的方式存在,而网络大学、虚拟大学等在线教育形式的出现使得学习可以跨越时空界限,同时也改变了我们对于学校的传统认知。信息时代的到来使得知识呈现出爆炸式增长的态势,人们对学习的认知不再局限于对知识的记忆,更强调对知识的理解以及生产新的知识。这也改变了人们对学习测评的认知,使得以传统学校考试和职业资格考试为代表的、强调“知道什么”的知识本位认证体系变得难以满足学习的基本需求(DeVon et al.,2007)。一种强调“能做什么”的能力发展型认证开始受到关注,其不再强调标准的唯一性,而更重视个体在任务处理和问题解决过程中的能力表现,并强调采用档案评估、报告访谈和技能展示等更加多元化的测评方式(Stevens et al.,2017)。互联网的发展引发了学习方式的数字化变革,使得学习者的学习时间变得更加灵活。与此同时,学习成果认证体系的价值导向发生了显著的变化,这使得我们有必要对學习成果认证和测评体系进行重新认知(Siemens et al.,2015)。因此,笔者基于认证方式和时间安排两个维度构建了四象限空间的学习成果认证分类框架(见图1),并以此解释技术驱动下的各类学习成果认证的变迁,进而凸显在线学习测评技术在此过程中的重要价值。

1.时间固定的知识掌握型学习成果认证

时间固定的知识掌握型学习成果认证是学校教育中最为传统和普遍的学习成果认证方式。早在康德1798年发表的《系科之争》和纽曼1873年发表的《大学的理念》中就将教育的价值功能界定为人才培养,而对于人才的认证主要通过学校颁发学历与学位的方式来进行(韩锡斌等,2016)。学校按照学科、专业来组织学历和学位认证,其通过固定的学业年限和课程设置来要求学生完成认证所需的学时和学分,而考试则被作为检验学生知识掌握程度的主要手段。知识经济与全球化进程促使学习成果认证不再局限于某一个国家或地区,以博洛尼亚进程为标志的“欧洲高等教育资格框架”实现了学校间采用固定学习时长和知识掌握度的认证标准化(刘宝存,2009)。特别是“欧洲学分转换系统”的实施,使得29个国家实现了不同教育体系之间的学位互认(韩锡斌等,2016),也进一步促进了面向知识掌握度的认证体系的发展,让学习测评得以实现标准化和规模化。

2.时间灵活的知识掌握型学习成果认证

英国开放大学于1969年开创了开放式学习模式,这让学校集中组织学习者在固定时间和地点进行学习的方式得以改变,也让学习者对学习时间的掌控变得更加灵活(The Open University,2017)。从上个世纪末到本世纪初,互联网的迅速普及使在线学习成为可能,基于网络教育的学位项目随之兴起,其主要采用的是时间灵活的知识掌握型学习成果认证方式(韩锡斌等,2015)。相对于传统的学习成果认证方式,这种认证方式对学业年限的要求更为宽松,给予了学习者更大的学习自由度,允许学习者按照自己的步调来控制学习进度。同时,这种学习成果认证方式也为不同背景的学习者提供了更多的学习机会。然而,由于网络教育的入学门槛相对传统学历教育要低得多,且师生在时空上的分离使其教育质量难以控制,加之对分层教学和个性化学习的“过度关注”进一步影响了其教育质量,因而网络教育毕业证书的含金量饱受社会质疑。而MOOCs的出现引发了新一轮的在线教育热潮,许多知名高校也开始关注基于MOOCs的在线学习方式,这为发展高质量时间灵活的知识掌握型学习成果认证提供了新机遇。目前,edX、Coursera和FutureLearn等MOOCs平台都通过在线开放学习的方式为学习者提供具有竞争力的学位认证项目。例如美国佐治亚理工学院的计算机科学硕士学位项目就是其中杰出的代表,其被视为高品质在线学位认证的典范(Baker et al.,2018)。

3.时间固定的能力发展型学习成果认证

时间固定的能力发展型学习成果认证方式起源于传统的学徒制教育,其言传身教的教学方式要求师傅根据学生的特点来分阶段提升他们的技能水平。随着社会经济转型对技术人才需求的激增,工程技术类院校借鉴学徒制教育的特点,在固定的学制时间内培养学生从业所需的职业技能,这使得时间固定的能力发展型学习成果认证最先出现在职业教育中。随着信息社会对互联网人才需求的快速增长,一种全新的时间固定的能力发展型学习成果认证项目开始出现。针对互联网行业新型技术人才短缺的现状,美国在线教育机构Udacity于2014年推出了“纳米学位”(Nano Degree)项目。该项目提供网站开发、移动程序设计、数据分析等微学位认证课程,并通过与AT&T、Google、Amazon、Facebook和IBM等知名企业的合作,设计了与企业人才需求相匹配的课程内容。在“纳米学位”项目中,学习者可以通过编译程序、设计案例和创造作品来展现自己的能力水平,这使得“纳米学位”成为一种新型的职业能力证明(Gee,2014)。截至2019年5月,已经有75000名学习者通过Udacity的“纳米学位”项目获得了认证学位,并且有84%的毕业者在学业结束后的半年内获得了更好的职位,其平均年薪达24000美金,这使得“纳米学位”被视为高含金量的新型学位(Thrun,2019)。与此同时,高等院校也开始探索能力发展型学位认证。例如,密涅瓦大学从2014年开始面向全球推出能力发展型的本科学位项目。该项目依托互联网实施创新型的教学模式,采用在线学习互动平台对学习者的电子档案进行记录,并在四年内对其各个维度的能力发展进行跟踪,以确保每个学习者在毕业时都会获得自己独特的能力证明(Minerva Project,2019)。这种基于固定时间的能力发展型学习成果认证越来越受到重视,使得学习测评能够更好地反映出学习者真实的能力水平。

4.时间灵活的能力发展型学习成果认证

能力发展型学习成果认证也受到了传统教育机构的关注,他们开始尝试从学习时间的维度进行创新,于是一种强调时间灵活的能力发展型学习成果认证开始出现。时间灵活的能力发展型学习成果认证强调对学习者先前学习经验和能力的测评(王迎,2012),也就是说,若学习者到达了获取学位所规定课程的要求,就可以对其能力进行认证,并转换成相应课程的学分(Shapiro,2014)。时间灵活的能力发展型学习成果认证借鉴了胜任力模型的理念,关注学习者已有社会经验和学习经历的价值,不再要求已具备相关能力的学习者重复修读已掌握的课程,这就使得学生不必按照规定的课程来获得学分。美国西部州长大学较早采用这种时间灵活的能力发展型学习成果认证方式,其对学生的测评并不完全按照课程的学习时间和进度安排来组织,也允许学生通过先前学习测评或经验证明材料来获得课程学分(韩锡斌等,2016)。这使得学习成果认证变得更加灵活和方便,也更趋向于反映学习者的真实能力水平。

5.学习成果认证变迁凸现在线学习测评技术价值

从学习成果认证的发展趋势可以发现:随着课程教学愈发强调以学习者为中心,测评技术的价值和作用更加突出;在线学习测评技术的发展促使学习成果认证越来越灵活开放,其功能特征也从诊断性、终结性走向过程性、系统性(Jisc,2010)。以课堂教学为中心的传统测评体系正在被以学习服务为中心的测评体系所取代,这一转变从在线学习测评技术的发展过程可以窥见:随着计算机技术被引入以纸笔为主的传统考试,电子化测评(e-Assessment)开始兴起;随着互联网技术介入教学过程,基于学习管理系统的过程性评价被广泛采用,在线测评(Online Assessment)開始流行;人工智能技术使学习服务与分析变得更加智能,具有“智慧基因”的在线测评技术开始关注面向学习者能力发展的真实化测评(Authentic Assessment)。本文所指的“在线学习测评技术”是不同时期面向课程教学层面的测评技术和方法的集合。当前,在线学习测评技术正处于从关注知识掌握到注重能力发展的转变阶段,因而,对其进行前瞻性、系统化分析对未来在线学习测评的发展具有重要意义。

三、理论框架

1.学习目标分类的重要价值:指向深度理解的过程化测评

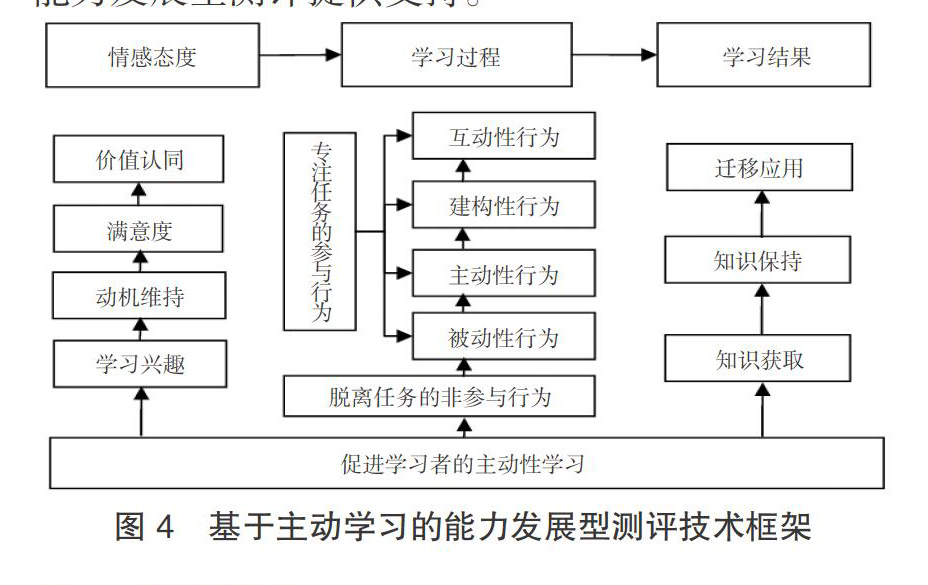

作为一种有目的的活动,学习测评本身带有价值判断的功能。传统教学更多通过考试来测评学习者的外显行为,用以判断学习者的知识掌握程度。这种方式虽然能为学习者带来“惰性知识”,却无法帮助其实现对知识的深度理解。从互联网时代学习成果认证的分类和发展来看,学习测评越来越注重对学习者真实能力的评价,其价值导向也更加指向深度学习。能力发展型测评对学习目标的分类提出了更高要求,因而有必要对其理论框架进行系统解读。安德森和克拉斯沃尔对布鲁姆的教学目标分类理论进行了补充,提出从人的认知过程和知识类型两个维度来构建分类框架,对学习、教学、评价以及三者之间的关系进行了重新梳理(L·W·安德森等,2007)。据此,笔者基于学习目标分类框架,从学习者的新知产生、知识关联和知识的应用迁移等不同认知阶段,以及实现学习者的深度学习和促进其能力发展的视角,构建了基于学习目标分类的过程化测评技术框架(见图2)。该框架可为实现学习测评从关注知识掌握到关注能力发展的体系变革提供支撑,进而促进学习测评技术从提供外部支持向嵌入学习本身的根本性转变。

2.知识本位的掌握度测评:行为主义指向的程序教学

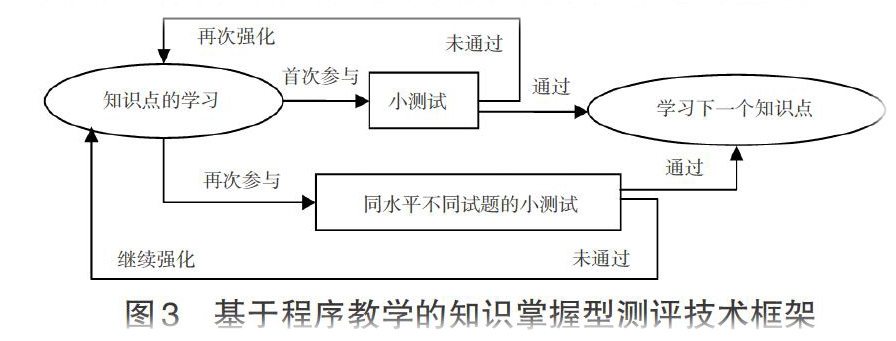

知识本位的掌握度测评作为行为主义理论视角下的典型测评方法,其主要理论基础为程序教学理论。程序教学最早发源于普莱西设计的教学测验和计分机器,随后斯金纳从行为主义的视角对程序教学进行了论证。程序教学论认为学习是刺激和反应之间联结的强化过程,强调教学要关注外部刺激,要将复杂的学习过程分解为详细方案,因而技术支持的教学系统要遵循积极反应、小步子、即时反馈和自定步调的原则,要具有清晰的教学模式和组织流程(韩锡斌等,2012)。由此,基于直线式、衍枝式和莫菲尔德式等典型程序教学模式,笔者构建了基于程序教学的知识掌握型测评技术框架(见图3),其可以作为开展客观知识测评技术研究的基础。

该测评技术框架已在教学实践中经过长期检验:在计算机多媒体教学时代,基于程序教学的计算机辅助测评与自动化阅卷系统得到了长足发展(李艺等,2013);在信息技术与课程整合的时代,程序教学支持的电子应答系统为课堂教学提供即时的反馈性测评,促使知识掌握度测评进一步发展;在“互联网+”学习时代,xMOOCs的测评模式成为程序教学的典型应用,实现了客观知识掌握度测评的规模化应用。

3.能力本位的发展性测评:认知主义与建构主义指向的主动学习

能力本位的发展性测评更适合于针对主观理解、问题解决和批判性思考等高阶思维能力的测评,其主要理论基础为认知主义和建构主义。认知主义重视以往经验的作用,强调对个体复杂思维过程的解释和激活图式的特殊意义,即教师要把知识组织成为对学生有意义的样式,以促进知识的掌握和迁移(Driscoll,2005)。基于这种认知信息加工模型,各种强调练习、游戏、模拟与人机对话的早期计算机专家系统被开发出来。建构主义学习理论进一步将知识获取分为入门、熟练和精通三个阶段,并指出建构性的学习环境对熟练阶段的学习者最为有效(Mayer,2018)。因此,基于建构主义设计的学习系统更关注学习者在分析、处理和解决问题等方面的能力建构,这为能力发展性测评提供了理论支撑。随着计算机支持的协作式、个性化学习管理系统的问世,在线学习测评技术愈发关注社会化学习,也更为强调针对学习者主动学习能力的测评。

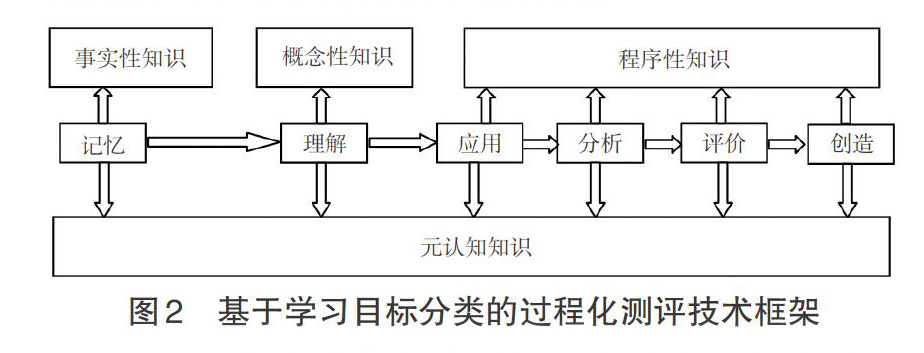

基于建构主义的ICAP模型将学习者的认知投入模式按照其学习活动的外显行为和产出分为互动性(Interactive)、建构性(Constructive)、主动性(Active)和被动性(Passive)等四种类型,其中主动性认知投入所产生的学习效果要明显优于被动性认知投入,而互动性认知投入更可能引发深度学习(Chi et al.,2018),这为优化能力发展性测评提供了理论依据。基于上述分析,笔者以促进学习者主动学习为目标,将情感态度、学习过程和学习结果作为学习者能力发展的测评维度,对主动学习所引发的学习者思维深度进行了不同程度的划分,由此构建了基于主动学习的能力发展型测评技术框架(见图4)。该框架强调激励学习者的主动学习行为,可从学习方式变革的视角为实施多维度、多元化的能力发展型测评提供支持。

四、应用模式

就发展轨迹来看,从早期的计算机辅助考试到如今反映学习进程的过程性测评,在线学习测评技术愈发呈现出智能化和自动化的特征。本部分主要从四个方面介绍在线学习测评技术的主要应用模式。

1.自动测试与实时反馈

在线学习中的自动测试主要被用于客观性和主观性两类试题的自动化评价。面向客观性试题的自动测试主要采用自动标记的多项选择和短文字简答方式,通过对答案的自动检查来评价学习者的知识掌握程度(Admiraal et al.,2015)。学习者在参与这类测试时,系统会自动判定他们的答案是否正确,并给出相应的提示与分析信息。这类自动测试最初被应用于传统课堂的形成性评价环节,主要采用电子应答系统对学习者的概念性知识掌握情况进行诊断。例如英国开放大学的OpenMark系统,其对测试的交互性和反馈的即时性进行了加强,并实现了断点测试功能(Jordan,2013)。目前这类技术在MOOCs中有着广泛应用,其通过小测试或阶段性考试的形式来实现过程化评价,以帮助学习者更好地了解自己的学习状况,同时也将教师从繁重的阅卷工作中解放出来,使其能够有更多的时间关注课程教学本身。面向主观性试题的自动测试主要利用自然语言处理技术,将学习者答案与参考答案进行基于语义相似度的文本特征比对,进而评判学生者的回答是否正确(刘伟等,2016)。面向主观性试题的自动测试最初被用于短文本简答题,如OpenMark和Moodle系统都针对简答题提供了基于关键词和同义词匹配的测评功能,以对学习者的回答进行语义文本分析性评判(Jordan,2013)。而潜在语义分析技术的出现,使在线测评系统可以对文本概念、文字风格和语法结构进行更为精准的分析(Warschauer et al.,2006),这促使e-rater、Intelligent Essay Assessor和OpenEssayist等写作类自动测试系统得到了大范围应用(Jordan,2013)。在上述两类自动测试中,实时反馈的即时性和有效性是关键。已有的实时反馈功能主要通过智能导师模块来实现,这对于事实性、概念性和程序性知识的测评比较有效,而在思维策略性知识的测评效果上则并不显著(Bates,2014)。

2.同伴互评

为弥补上述测评技术在思维策略性知识测评上的不足,同伴互评被引入课堂教学和在线教学,其被认为是替代传统评价方式的一种较为有效的测评技术(Formanek et al.,2017)。同伴互评的主要实现机制如下:第一步,教师通过系统发布互评任务和评价量规;第二步,学习者按照规定的时间提交任务;第三步,系统根据互评机制将需要评价的任务分发给学习者,学习者在规定时间内完成评价,并给出评分和评语;第四步,系统对成绩进行审核,并公布学习者成绩和评语。通过分析上述机制可以发现,互评者的信赖程度(即内在信度)以及互评者评价与教师评价间的相似性(即聚合效度)是互评有效的关键(Bouzidi et al.,2009)。例如,Coursera、edX等主流MOOCs平台都采用了基于匿名随机分组的互评机制,其将学习者分为每4~5人一组,确保学习者可参与的评价任务数量一致,并规定学习者要严格根据评价量规进行互评(Biggs,2013)。又如加利福尼亚大学的标准化同伴互评系统(Calibrated Peer Review),其要求参与互评的学习者先对教师评价过的论文或作品进行评价,再根据学习者评价与教师评价间的相似程度对前者进行信度赋值,并将其作为同伴互评成绩的计算依据(郑燕林等,2015)。此外,同伴互评中用于学习者之间相互评分的评价量规对于互评的有效性也极为关键。一个有效的互评量规要包含明确的指标、权重和评分内容,并需要对其信效度進行验证。例如,美国大学协会针对论文、学习项目、口头报告和课堂合作等主观性任务提供了经过检验校正的VALUE评价量规(Rhodes et al.,2013),为在线学习中同伴互评任务的设计提供了借鉴。

3.基于学习分析的测评

计算机自适应测试技术的引入使在线学习测评系统变得更加智能。基于项目反应理论(Item Response Theory)构建的适应性测试模型可以将学习者能力和试题难度进行关系映射,进而根据学习者的能力水平来调整试题难度和选择试题类型,从而初步实现了基于学习者知识掌握程度的助学功能,这为规模化学习测评创造了条件(Rossano et al.,2017)。但这类学习测评系统所存储的学习时长、行为特征和成绩等数据均为反映学习者客观行为的痕迹型数据,缺少能够反映学习者参与度、投入度的状态型数据,而学习分析技术可以弥补这一不足。美国教育部教育技术办公室在其发布的《通过教育数据挖掘和学习分析技术优化教学》(Enhancing Teaching and Learning Through Educational Data Mining and Learning Analytics)报告中提出:学习分析可以利用更为丰富的教育大数据来开展学术性分析、行为性分析和预测性分析;学习分析要综合运用信息科学、社会学、计算机科学、统计学、心理学和学习科学中的理论、技术、方法和模型,去解释和分析影响学习者学习的各种重要因素;从更为全面和系统的视角来看,不仅要对学习者的学习行为表现进行测评,也要为其学习提供适应性的反馈支持(Bienkowski et al.,2012)。

学习分析技术在测评中的应用一般不是孤立的,需要将其同已有的在线学习系统及其他管理系统进行关联,从而构建更加完善的基于学习分析技术的测评体系。学习分析涉及数据采集、数据存储、数据分析、数据表示与应用服务等五个环节,这构成了学习分析的核心要素(李艳燕等,2012)。为强化学习分析的有效性,应做到以下三点:首先,需要保证分析模型的适切性;其次,数据采集不能只针对课程属性、学生成绩等表层数据,更需要关注学习过程中的事务级数据(Transaction-Level Data);再次,在处理和分析事务级数据时,要有针对性地运用技术和方法,不能以简单的维度性指标来呈现分析结果,而需要就学习者的知识差距与特殊需求提供详细的分析报告(Nyland et al.,2017)。总体而言,当前较为有效的基于学习分析的测评是从课程层面对学习成效的评价和对学习服务的重构,并将学习目标、学习活动、学习评价和学习反馈进行关联,进而为学习者、教师和管理者提供不同视角的分析报告。

4.数字徽章

数字徽章(Digital Badge)作为一种以图标或徽标表征学习成果的数字标记(Digital Tokens),被用于正式和非正式学习中的学习成就或能力认证(EDUCAUSE,2012)。数字徽章主要有以下三方面的用途:一是用于激励学习者的学习动机,即采用奖励的方式来鼓励学习者获取学习积分,而这些积分可被用于学习身份升级和礼物兑换(Newby et al.,2016);二是用于标识学习成就,即采用不同的徽章去代表各类学习成就,如小徽章用于标识学习单元或知识点,大徽章用于标识课程,更大的徽章则作为职业技能资质的标识(Ellis et al.,2016);三是用于识别学习者的学习路径,即不同的数字徽章代表不同等级的知识水平和技能经验。通过分析学习者取得的徽章,可以追踪其学习过程(West et al.,2016)。目前,在数字徽章的技术应用层面已经确立了标准和规范,例如美国谋智基金会(The Mozilla Foundation)的开放徽章基础架构(Mozilla Foundation & Peer 2 Peer University,2012)、数字化承诺联盟(Digital Promise)的“微证书”(Cator,2016)等,这些标准和规范推进了数字徽章的标准化应用。目前应用数字徽章的全球性学习项目尚较少,其中IBM的开放徽章项目(Open Badging Program)的成功显示出该技术具有光明的应用前景。开放徽章已被全球超过40个学习项目所采用,通过开放徽章认证获得了职业发展和晋升的学习者超过168000名(IMS Global,2017)。可以预见,未来数字徽章的规模化应用将为在线学习中的学习成果认证带来新的发展契机。

五、面临的问题与挑战

在线学习测评技术的发展为学习评价提供了更加便捷、灵活的手段与方式,促使学习变得更加开放和多元,也为基于能力本位的教育提供了支持,但在应用层面上仍面临诸多问题和挑战。

1.大多数测评系统不够“智能”,基于学习分析的测评应用面临诸多问题

传统学习测评注重对考试成绩的评定。在这种价值目标的引导下,大多数在线测评系统过于注重对知识的考核,无法满足对学习者综合能力进行评价的需要,这使得系统的功能相对单一,智能程度和可扩展性较差。学习分析技术的出现使测评系统变得更加智能,其在算法模型和可视化分析上的优势已经开始展现。但从应用状况来看,依然面临较多问题:第一,测评系统的分析深度不够。测评系统所采集的数据多为结构化数据(如测评分数、在线时长、点击次数等),而对非结构化数据(如学习者在线提问、互动讨论等)的采集不足,这导致其难以对测评结果进行深度分析,不能有效揭示学习者的思考过程和方式。第二,测评系统的分析结果较为片面。由于系统所采集的数据基本来自正式学习环境,而未有效聚合非正式学习环境中的数据,这就造成了分析结果在数据维度上的缺失,从而降低了分析的有效性和可靠性。第三,分析结果的呈现方式过于简单,可借鉴性不强。现有测评系统大多仅以数据图表、仪表盘等方式对结果进行呈现,缺乏对改善教学和优化学习的关注。第四,测评系统缺少具有效度的测评框架和分析方法。现有的应用更多是面向学习成績与学习行为的关联性数据挖掘,这并没有突破传统测评思维方式的局限。即使是目前较为先进和智能的Knewton系统,其在测评环节上仍存在诸多不足(张华华等,2016),距离“智能”依然有较大的差距。

2.测评系统的数据安全备受质疑,提升在线学习测评的可信度迫在眉睫

在线测评一方面由于其灵活、多样的优势而得以迅速发展,另一方面也由于其存在的信息安全问题而饱受质疑。目前已有的测评系统在数据安全性和测评可信度上存在如下两方面亟待解决的问题。

一是如何提高测评系统的安全性,防止数据被窃取和篡改。在线学习测评系统中保存着学习者的个人属性、学习行为等重要数据,因此其数据的安全性倍受重视。为防止数据被恶意篡改和窃取,测评系统大多采用对敏感数据进行加密的方式来提升系统的安全性,但缺乏从测评过程监控的角度所进行的安全优化。目前许多测评系统缺少行为监测功能,不能对异常测评数据进行有效的检测与回溯,这导致了严重的安全隐患。

二是如何甄别测评对象的真实身份,提升在线测评的可信度。在线测评需依托网络环境,而参与测评的个体可能是学习者本人,也可能是替考者,甚至是智能机器,这就使得对测评对象的有效甄别成为亟需解决的现实问题。目前大部分测评系统所采用的甄别手段是数字身份认证,也就是通过对比注册信息的方式来甄别测评对象身份,由于其技术相对简单,故甄别结果的可信度较低。也有部分在线教育平台和测评机构将生物识别技术用于身份核验,如Coursera在部分认证课程中采用击键生物识别技术(Keystroke Biometrics)来甄别测评对象的身份,美国罗格斯大学(Rutgers University)则通过摄像头对测评对象的脸部特征进行核验(李凤英等,2017)。此外,部分在线教育平台也在尝试加强对测评过程的监管,如edX与Software Secure公司合作开发的Remote Proctor Now (RPNow)监考系统,其通过网络摄像头对测评进行全程记录,并利用图像识别和人工审查相结合的方式实现了精准高效的考试监控(李凤英等,2017)。然而,由于基于上述技术手段的考试监控往往对测评对象的设备和学习平台的人力投入有较高要求,因而尚难以实现规模化应用。

3.教师应用测评技术的能力不足,基于测评数据的有效教学难以落地

技术的发展使得教学、学习与评价间的边界变得模糊,未来教育将从“经验主义”走向“数据主义”(余胜泉,2018)。借助测评工具和测评系统提供的数据,来分析和把握学习者的问题意识、知识储备和学习状态,成为教师需具备的关键能力。而教师对测评数据认识和应用上的不足成为其开展基于测评数据的有效教学的挑战,具体表现在以下几个方面。

一是教师需要具备基于测评数据开展有效教学设计的能力。教师往往习惯从传统教学流程出发,将测评系统应用于知识诊断、阶段测试和总结考试等环节,而并不善于借助测评数据对教学过程进行设计和优化。未来教师需要基于测评系统所提供的数据来进行教学决策,从准确把握学习起点、个性化定制学习目标、动态组织教学内容、灵活调整教学策略、即时进行评价反馈和推荐个性化资源等六个维度来开展有效的教学设计(陈明选等,2019)。

二是教师需要具备基于测评数据对教学过程进行有效监管的能力。教师在数据素养上的欠缺,使其难以基于测评数据来对教学进行有效干预并调整教学策略,更无法实现即时的反馈,这成为将测评数据应用于教学的障碍。教师需要具备依靠测评数据有效监管教学过程的能力,这种能力主要表现为:能通过“表现预测”驱动学习者有效学习,能通过“迭代监测”促进个性化教学,能通过“质量预警”对教学和学习过程进行优化(吴虑,2019)。

三是教师需要具备基于测评数据对教学实践进行有效反思的能力。在基于测评数据开展教学反思方面,目前教师更多是将阶段测验和结业考试数据用于总结性教学反思,而这类教学反思的作用较为有限。教师需要基于测评数据开展更多针对教学过程的教学反思,通过数据驱动对教学的不断迭代和优化,形成与未来学习相适应的“互联网+”教学模式。

综上所述,学习测评可以更好地促进学习者的发展,使教育回归本质。对于在线学习测评技术的探索不应仅停留在技术层面,更应不断促进测评在价值导向层面上的转变。针对在线学习测评技术的研究需要以一种全新的思维来重新认识学习测评的角色,并将云计算、情境感知和人工智能等新兴技术有效融入其中,使得测评能够与学习的内在本质相契合,这将是未来在线学习测评技术研究的重要方向。与此同时,从测评的视角构建教育大数据,并挖掘其背后的知识表征和协同决策价值,进而为学习者提供更加主动和个性化的学习服务支持,这将是在线学习测评技术研究的价值追求。

参考文献:

[1][美]L·W·安德森等(2007).学习、教学和评估的分类学(布鲁姆教育目标分类学修订版)(简缩本) [M].皮连生.上海:华东师范大学出版社:36.

[2]陈明选,耿楠(2019).測评大数据支持下的有效教学研究[J].远程教育杂志,37(3):95-102.

[3]韩锡斌,刘英群,周潜(2012).数字化学习环境的设计与开发[M].北京:中央广播电视大学出版社:18-21.

[4]韩锡斌,王玉萍,张铁道等(2015).远程、混合与在线学习驱动下的大学教育变革——国际在线教育研究报告《迎接数字大学》深度解读[J].现代远程教育研究, (5):3-11,18.

[5]韩锡斌,王玉萍,张铁道等(2016).迎接数字大学:纵论远程、混合与在线学习——翻译、解读与研究[M].北京:清华大学出版社:96-104.

[6]李凤英,何屹峰,齐宇歆(2017).MOOC学习者身份认证模式的研究——基于双因子模糊认证和区块链技术[J].远程教育杂志,35(4):49-57.

[7]李艳燕,马韶茜,黄荣怀(2012).学习分析技术:服务学习过程设计和优化[J].开放教育研究,18(5):18-24.

[8]李艺,单美贤(2013).“教师”的智慧:谈程序教学思想的兴起与归宿[J].电化教育研究,34(7):11-16.

[27]Ellis, L. E., Nunn, S. G., & Avella, J. T. (2016). Digital Badges and Micro-credentials: Historical Overiew, Motivational Aspects, Issues, and Challenges[M]//Ifenthaler, D., Mularski, B. N., & Mah, K. D. (eds.) (2016). Foundations of Digital Badges and Micro-Credentials: Demonstrating and Recognizing Knowledge and Competencies. New York: Springer:3-21.

[28]Formanek, M., Wenger, M. C., & Buxner, S. R. et al. (2017). Insights About Large-Scale Online Peer Assessment from an Analysis of an Astronomy MOOC[J]. Computers & Education,113:243-262.

[29]Gee, S. (2014). Udacity Offers Nano Degrees[EB/OL]. [2018-06-17]. https://www.i-programmer.info/news/150-training-a-education/7438-udacity-offers-nanodegrees.html.

[30]IMS Global(2017). Mapping Digital Transformation: Identifying and Understanding Pragmatic Trends in the Application of Technology to Improve Learning Impact[EB/OL]. [2018-12-10].? https://www.imsglobal.org/sites/default/files/2017LearningImpactReport.pdf.

[31]Jisc(2010). Effective Assessment in a Digital Age[EB/OL]. [2018-04-06]. https://www.jisc.ac.uk/podcasts/effective-assessment-in-a-digital-age-06-sep-2010.

[32]Jordan, S. (2013). E-assessment: Past, Present and Future[J].New Directions in the Teaching of Physical Sciences, (9):87-106.

[33]Mayer, R. E. (2018). Educational Psychologys Past and Future Contributions to the Science of Learning, Science of Instruction, and Science of Assessment[J]. Journal of Educational Psychology, 110(2):174-179.

[34]Minerva Project(2019). Build Upon a Solid Foundation[EB/OL]. [2019-01-05]. http://www.minerva.kgi.edu/academics/four-year-curriculum/.

[35]Mozilla Foundation & Peer 2 Peer University (2012). Open Badges for Lifelong Learning: Exploring an Open Badge Ecosystem to Support Skill Development and Lifelong Learning for Real Results Such as Jobs and Advancement [EB/OL]. [2018-11-23]. https://wiki.mozilla.org/images/b/b1/OpenBadges-Working-Paper_092011.pdf.

[36]Nyland, R., Davies, R. S., & Chapman, J. et al. (2017). Transaction-Level Learning Analytics in Online Authentic Assessments[J]. Journal of Computing in Higher Education, 29(2):201-217.

[37]Newby, T., Wright, C., & Besser, E. et al. (2016). Passport to Creating and Issuing Digital Instructional Badges[M]//Ifenthaler, D., Mularski, B. N., & Mah, K. D. (eds.) (2016). Foundations of Digital Badges and Micro-Credentials: Demonstrating and Recognizing Knowledge and Competencies. New York, Springer:179-201.

[38]OECD(2018). The Future of Education and Skills Education 2030[EB/OL]. [2019-02-16].? http://www.oecd.org/education/2030/E2030%20Position%20Paper%20(05.04.2018).pdf.

[39]Rhodes, T., & Finley, A. (2013). Using the VALUE Rubrics for Improvement of Learning and Authentic Assessment[EB/OL]. [2019-08-15]. https://commission.fiu.edu/helpful-

documents/competency-based-courses-degrees/using-the-value-rubrics-for-improvement.pdf.

[40]Rossano, V., Pesare, E., & Roselli, T. (2017). Are Computer Adaptive Tests Suitable for Assessment in MOOCs[J]. Journal of e-Learning and Knowledge Society,13(3):71-81.

[41]Shapiro, J. (2014). Competency-Based Degrees: Coming Soon to a Campus Near You[EB/OL]. [2018-02-17]. http://chronicle.com/article/Competency-Based-Degrees-/144769/.

[42]Siemens, G., Gasevic, D., & Dawson, S. (2015). Preparing for the Digital University: A Review of the History and Current State of Distance, Blended, and Online Learning[EB/OL]. [2018-02-16]. https://linkresearchlab.org/PreparingDigitalUniversity.pdf.

[43]Stevens, B., Hyde, J., & Knight, R. et al. (2017). Competency-Based Training and Assessment in Australian Postgraduate Clinical Psychology Education[J]. Clinical Psychologist,21(3):174-185.

[44]The Open University(2017). Exhibition: The OU Story[EB/OL]. [2018-11-05]. http://www.open.ac.uk/library/digital-archive/exhibition/53/theme/5/page/1.

[45]Thrun, S. (2019). Taking Udacity to New Heights[EB/OL]. [2019-06-01]. https://blog.udacity.com/2019/05/udacity-new-heights.html..

[46]Warschauer, M., & Ware, P. (2006). Automated Writing Evaluation: Defining the Classroom Research Agenda[J]. Language Teaching Research, 10(2):157-180.

[47]West, D., & Lockley, A. (2016). Implementing Digital Badges in Australia: The Importance of Institutional Context[M]//Ifenthaler, D., Mularski, B. N., & Mah, K. D. (eds.) (2016). Foundations of Digital Badges and Micro-Credentials: Demonstrating and Recognizing Knowledge and Competencies. New York, Springer:467-482.

收稿日期 2019-03-02 責任编辑 谭明杰